La ressource que nous avons conçue pour vous aujourd’hui, va vous faciliter la vie et booster votre business. Notre outil Indicateurs Analyse Produit va vous aider à :

Télécharger notre dashboard excel d’indicateurs analyse produits

📕 Sommaire :

L’essentiel à retenir sur l’analyse produit

L’analyse produit : ça consiste en quoi ?

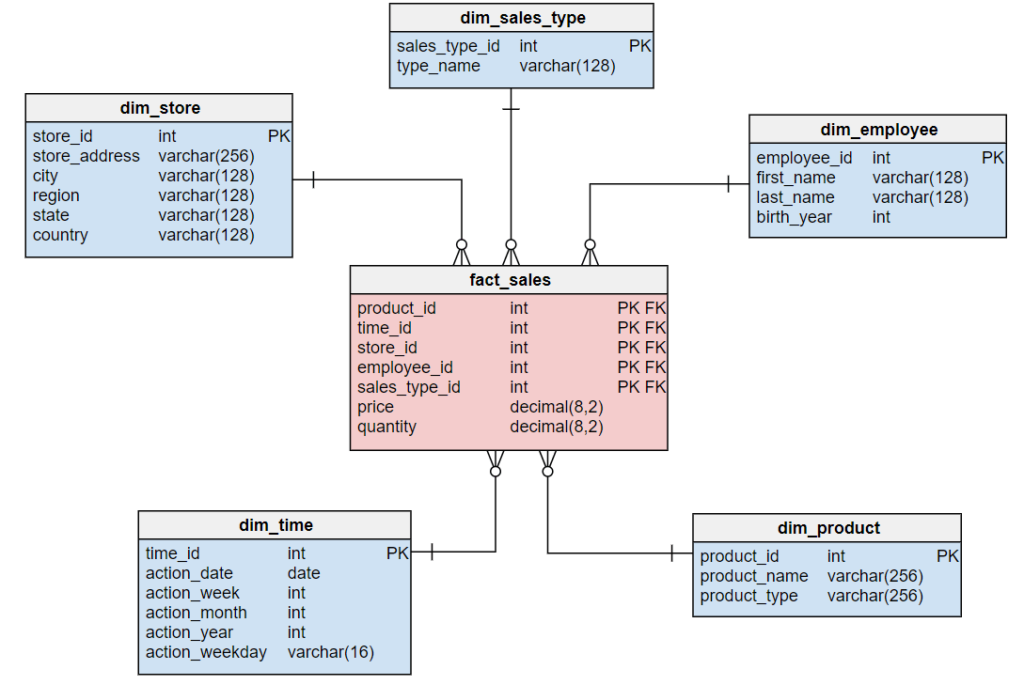

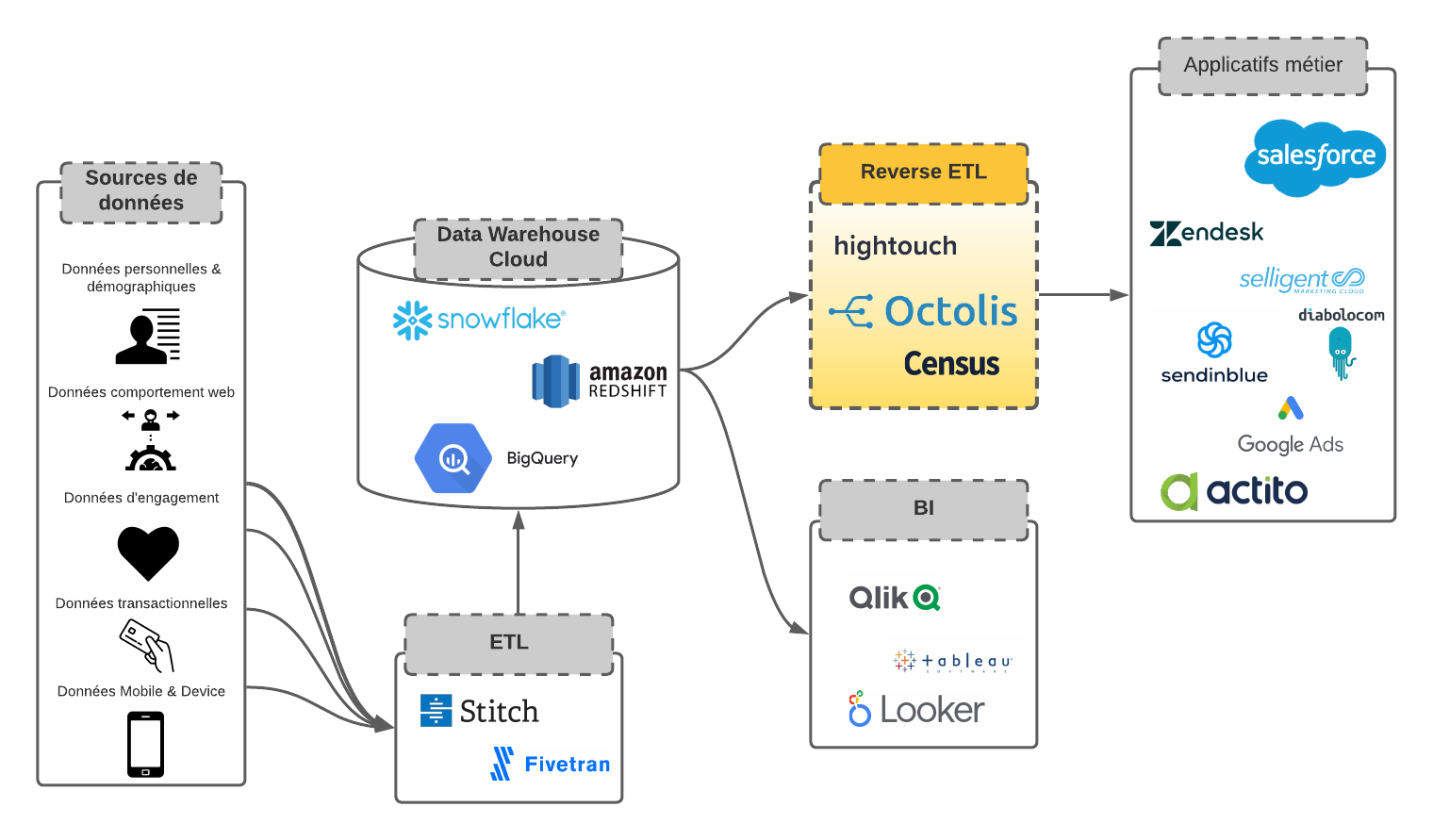

Comme son nom l’indique, l’analyse produit consiste à collecter et analyser des données provenant de différentes sources de vente pour comprendre les comportements des clients et les tendances d’achat, avec pour finalité : l’optimisation de l’expérience client et de la stratégie de ventes, en se basant sur des informations précises et actualisées.

Les avantages d’une bonne analyse produit

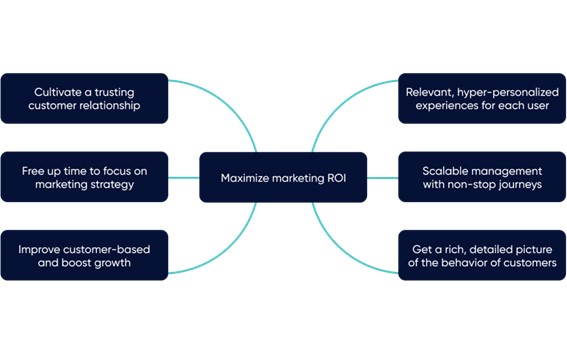

Effectuer une bonne analyse produit ne peut être que bénéfique pour votre business.

Voici les principaux avantages de l’approche :

Cependant, pour effectuer une analyse produit rigoureuse, la liste d’indicateurs clés est assez longue, et peut porter à confusion vu le nombre de facteurs qui entrent en jeu. Mais, heureusement pour vous, on a minutieusement sélectionné les indicateurs les plus pertinents à évaluer, et on vous les a regroupés en 5 catégories principales :

Comment structurer votre reporting produit ?

Vous n’avez toujours pas su choisir les bons indicateurs pour votre analyse ?

Voici notre tableau résumé qui vous guide avec les questions importantes que vous devez vous poser pour mieux choisir vos indicateurs clés.

Indicateurs clés : Tableau résumé

| Catégorie | Indicateurs |

|---|---|

| Revenus | - Croissance des revenus / Global - Croissance des revenus / Catégorie de produits - Croissance des revenus / Canal de vente - Revenus totaux - Revenus des 365 derniers jours |

| Marge | - Marge brute - Marge totale - % Marge brute - Marge brute des 365 derniers jours |

| Commandes et clients | - Nombre de commandes - Nombre de commandes total - Nombre de commandes total des 365 derniers jours - Nombre de commandes retour - Nombre de commandes saison été - Nombre de commandes saison automne - Nombre de commandes saison hiver - Nombre de commandes saison printemps - Nombre de clients - Nombre de clients depuis 365 jours - Taux de rétention - Nombre de premières commandes - Nombre de premières commandes depuis 365 jours - Taux de premières commandes - Nombre de clients avec 2+ commandes de ce produit - Taux de clients avec avec 2+ commandes de ce produit - Nombre de commandes en ligne - Nombre de commandes en magasin |

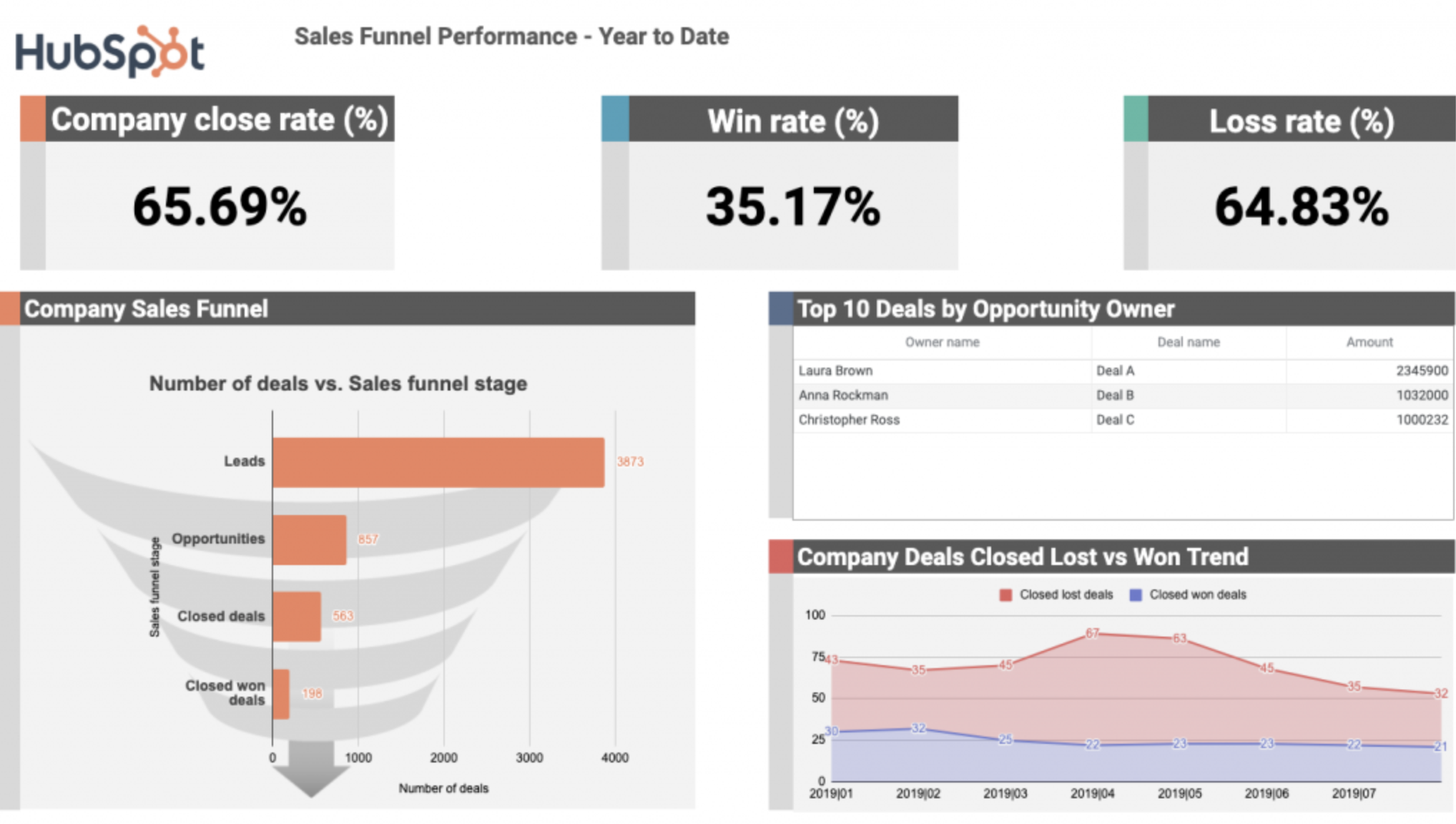

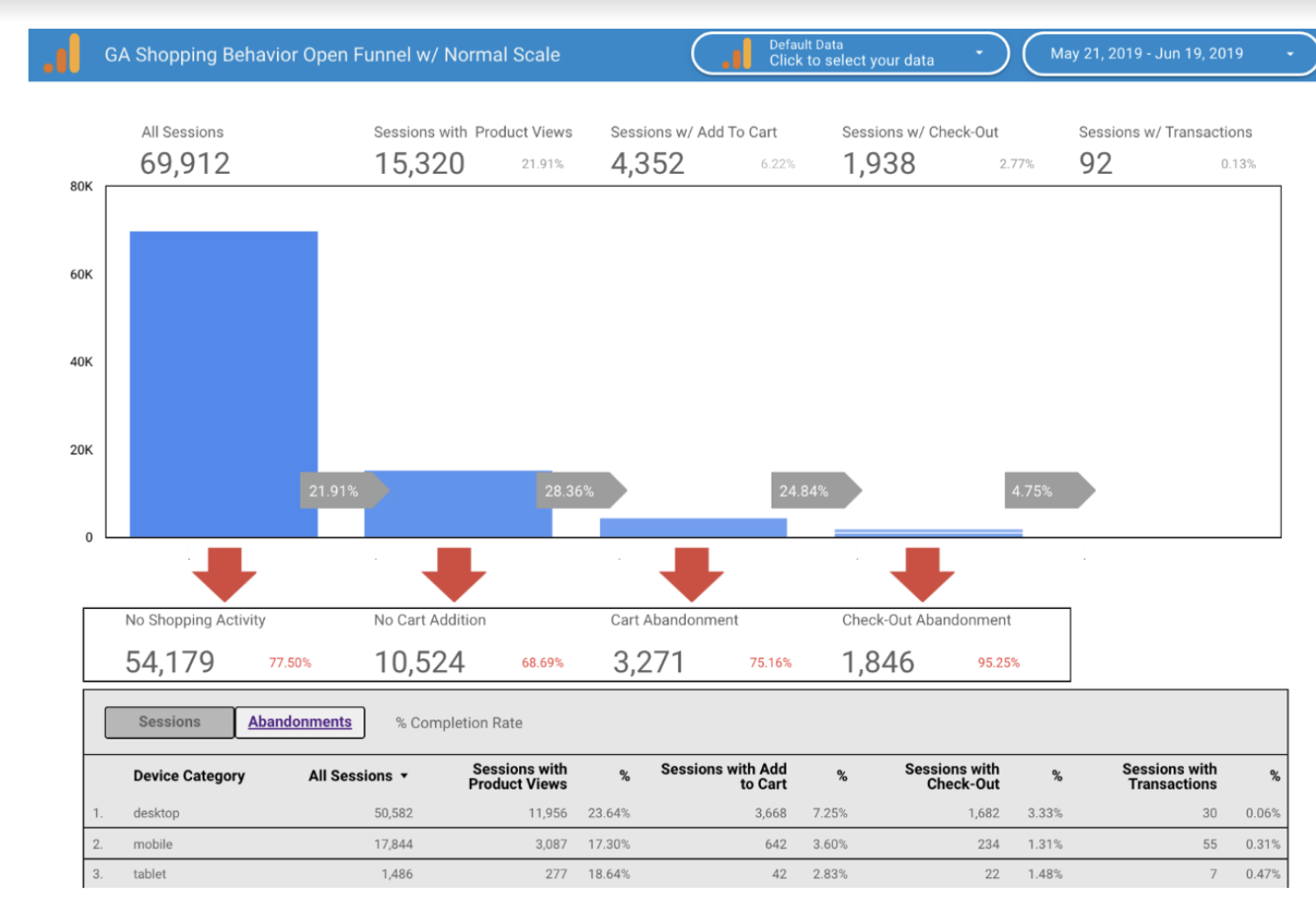

| Performance commerciale | - Taux de conversion - Coût d'acquisition client (CAC) - Valeur vie client (VVC) - Taux d'attrition - Temps de vie moyen (LTV) - Délai moyen d'inter-achat - Panier moyen - Taux d'un produit par rapport au panier moyen - Taux de vente croisée - Taux de retour produit - Taux de complétion des fiches produits - Temps moyen de mise en marché |

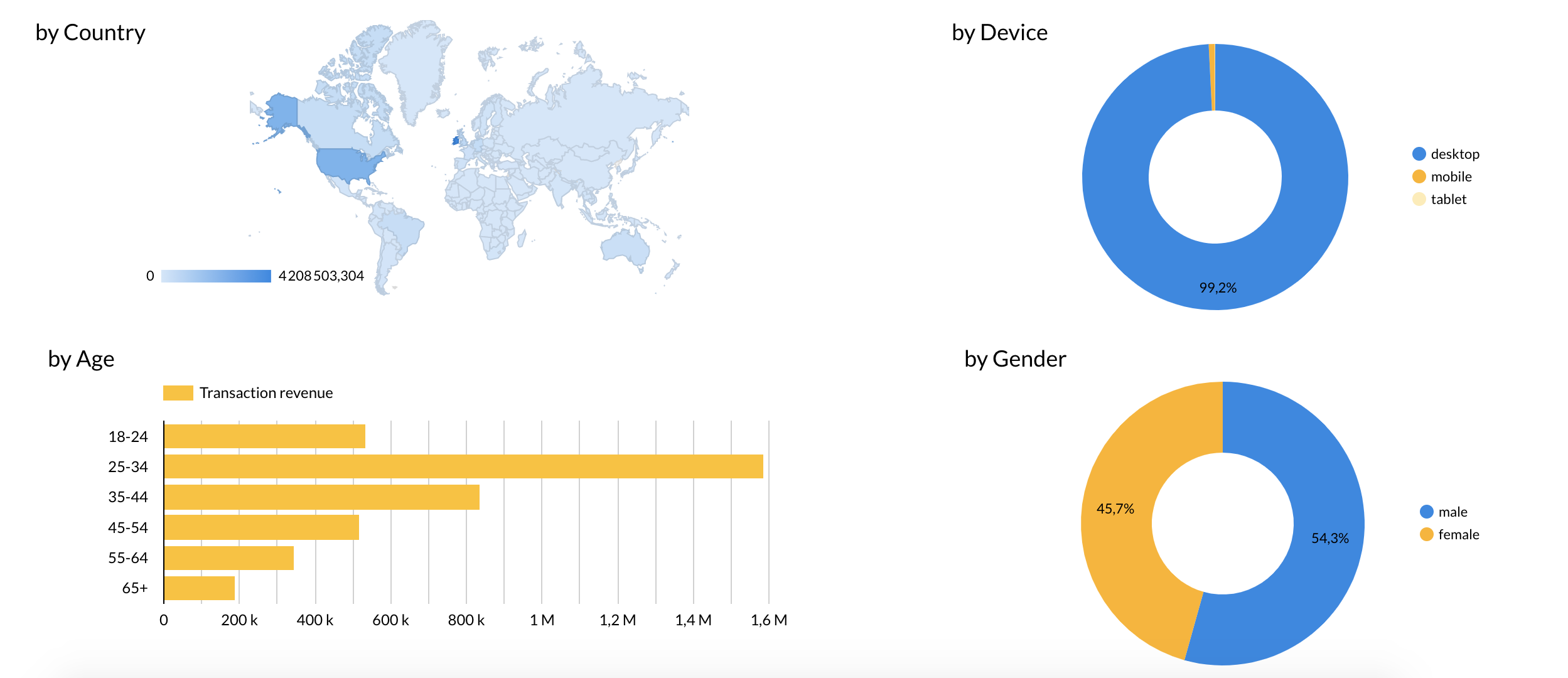

| Comportements utilisateur | - Taux de satisfaction client - Taux d'abandonnement - Temps moyen de traitement des commandes - Taux de rebond par page produit - Taux de clics sur le bouton "Ajouter au panier" - Nombre de vues par page produit - Taux de traffic source - Taux de clics sur les images du produit - Taux de clics sur le bouton "Acheter maintenant" - Taux de clics sur les liens de produits associés - Taux de clics sur les liens de produits similaires - Taux de clics sur les liens de produits complémentaires |

Il est vrai que toutes les questions qu’on vous a présentées sont du même degré d’importance. Mais un reporting produit bien structuré, ne veut pas forcément dire qu’il devrait tout inclure. Ayez donc la liberté de choisir les indicateurs qui vous conviennent au mieux, et soyez le plus pertinent possible dans votre choix.

Impact sur le revenu

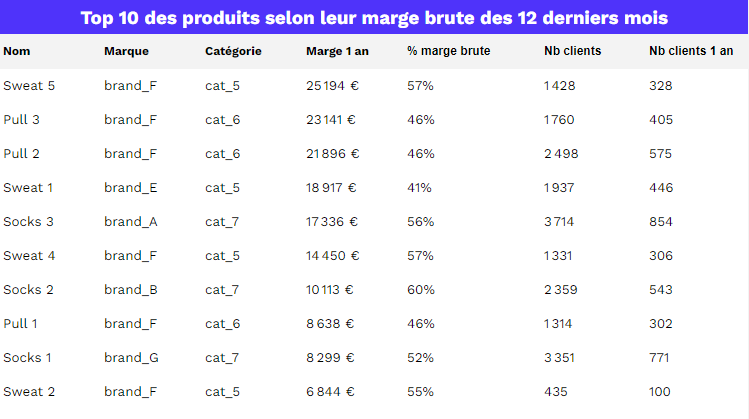

Impact sur la marge

Impact sur les commandes et les clients

Impact sur la performance commerciale

Impact sur le comportement utilisateur

Le rôle de l’analyse produit en E-Commerce / Retail

Connaissance produits : définition et objectifs

On a beau entendre le mot “Produit” et “Analyse”, et directement croire que la notion Analyse Produit est standard, peu importe son contexte d’utilisation.

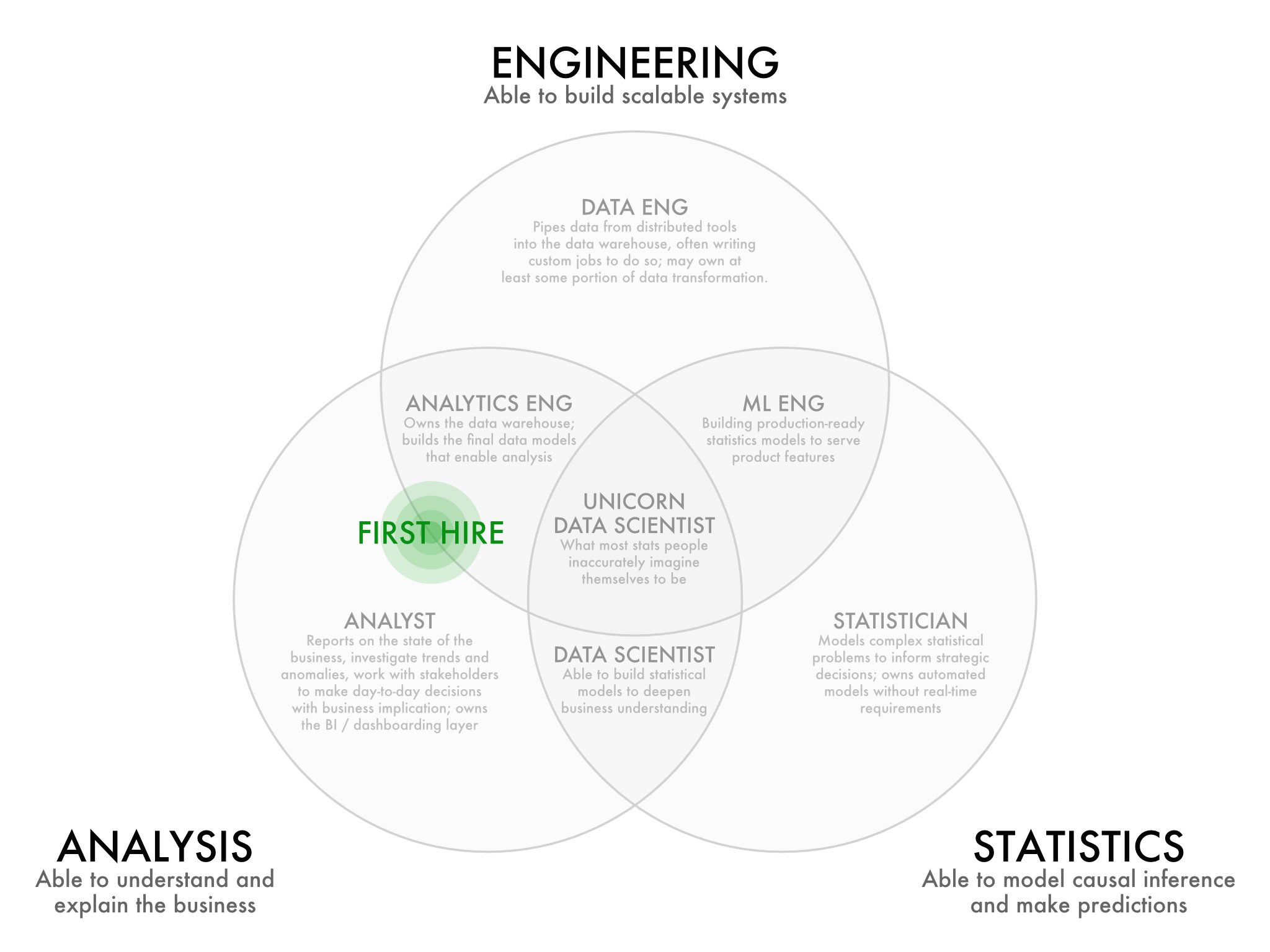

Dans le monde du retail, on évite assez souvent d’utiliser le terme “Product Analytics” -qui, en soi, représente l’analyse des parcours utilisateurs sur les applications et les sites web et souvent remplacé par la notion de “Retail Analytics”.

De ce fait, l’analyse ou connaissance produit en retail permet de prendre des décisions éclairées sur les prix, les stocks, le marketing, le merchandising, et toute sorte d’opérations en magasin, grâce à des algorithmes prédictifs provenant de sources internes (historique d’achats des clients, par exemple) et des référentiels externes (comme les données du marché ou mêmes les prévisions météorologiques).

Pourquoi faire une l’analyse produit ?

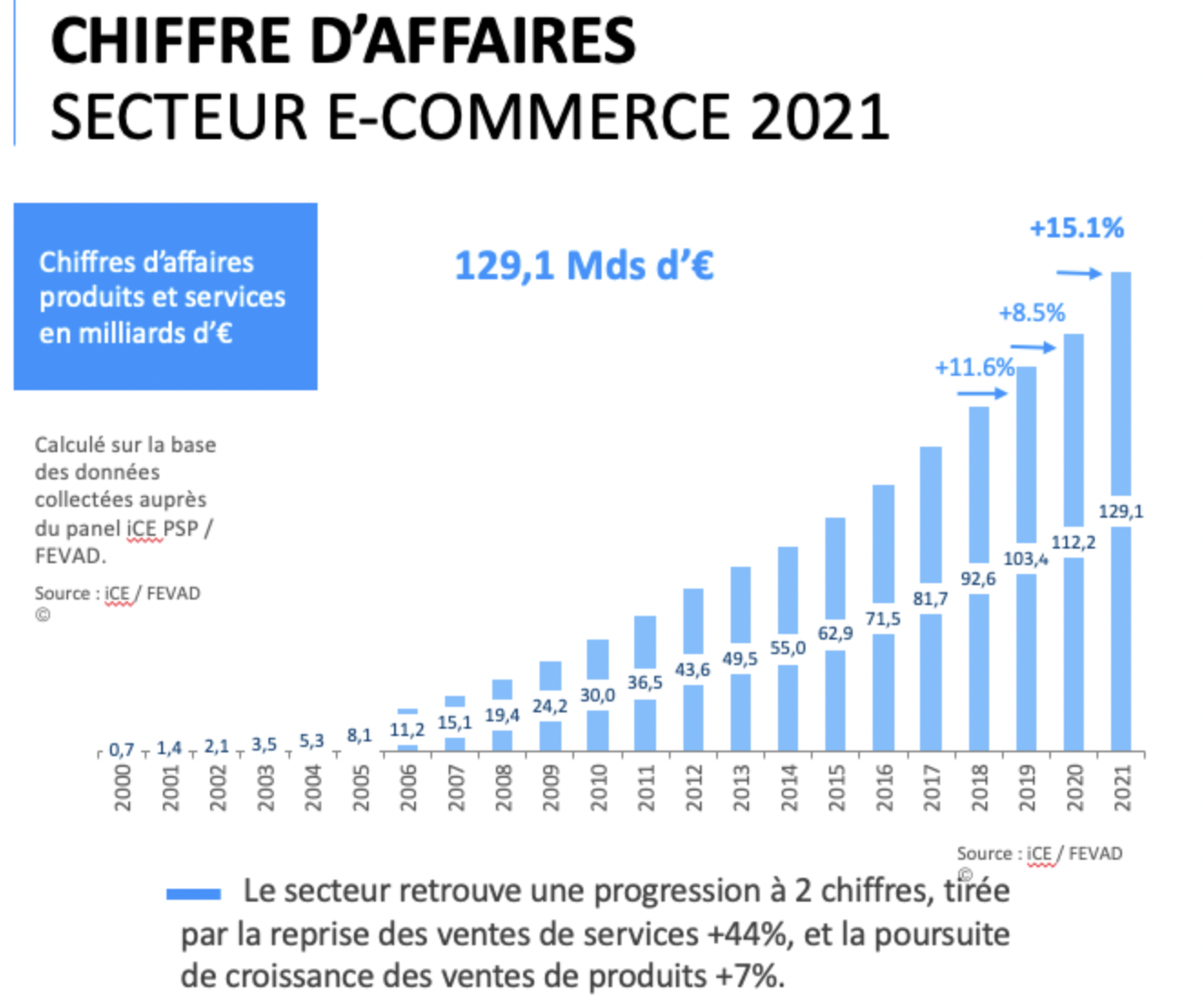

Vos objectifs principaux en tant qu’ bon E-commerçant ou Retailer, c’est d’optimiser toute sorte d’opération liée à la vente, afin de réduire les coûts et d’améliorer les marges. Pour vous montrer comment l’analyse produit peut vous aider à atteindre vos objectifs, on commence déjà par vous présenter ses bienfaits :

Analyse produit : Les bonnes pratiques

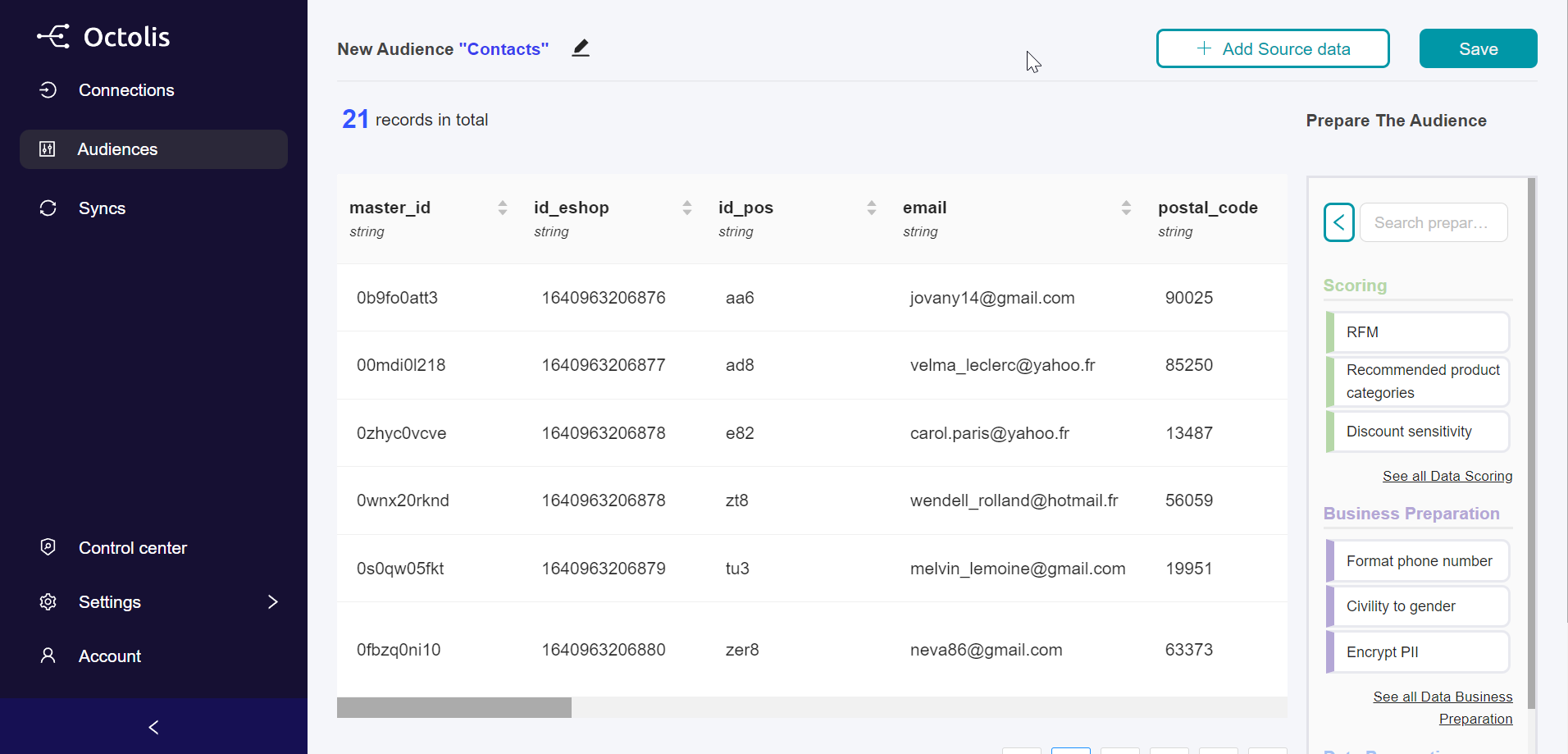

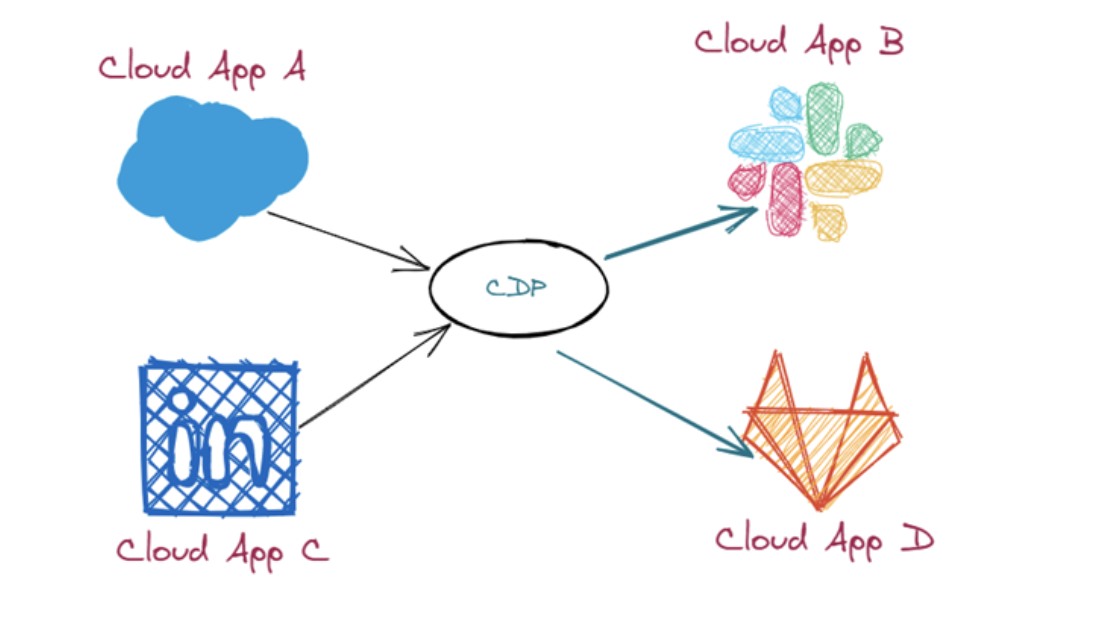

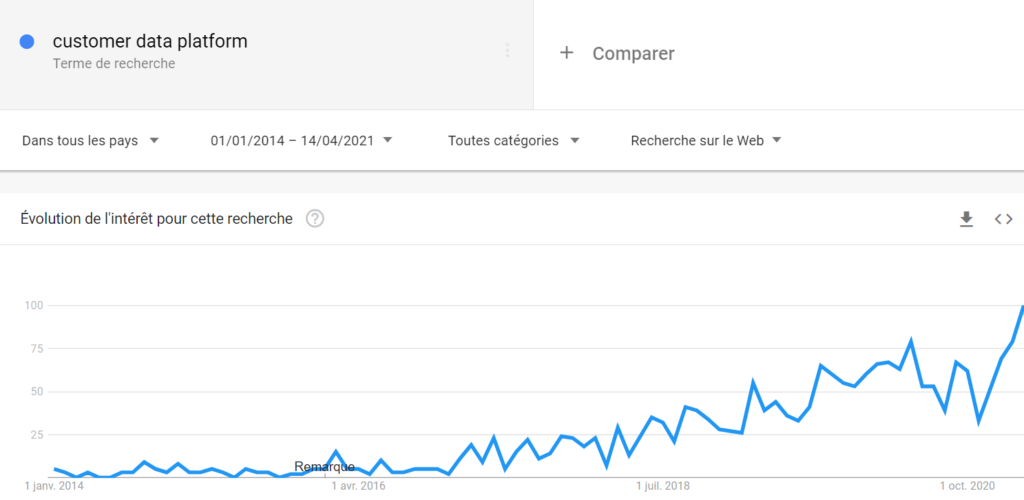

Exploiter pleinement les données client

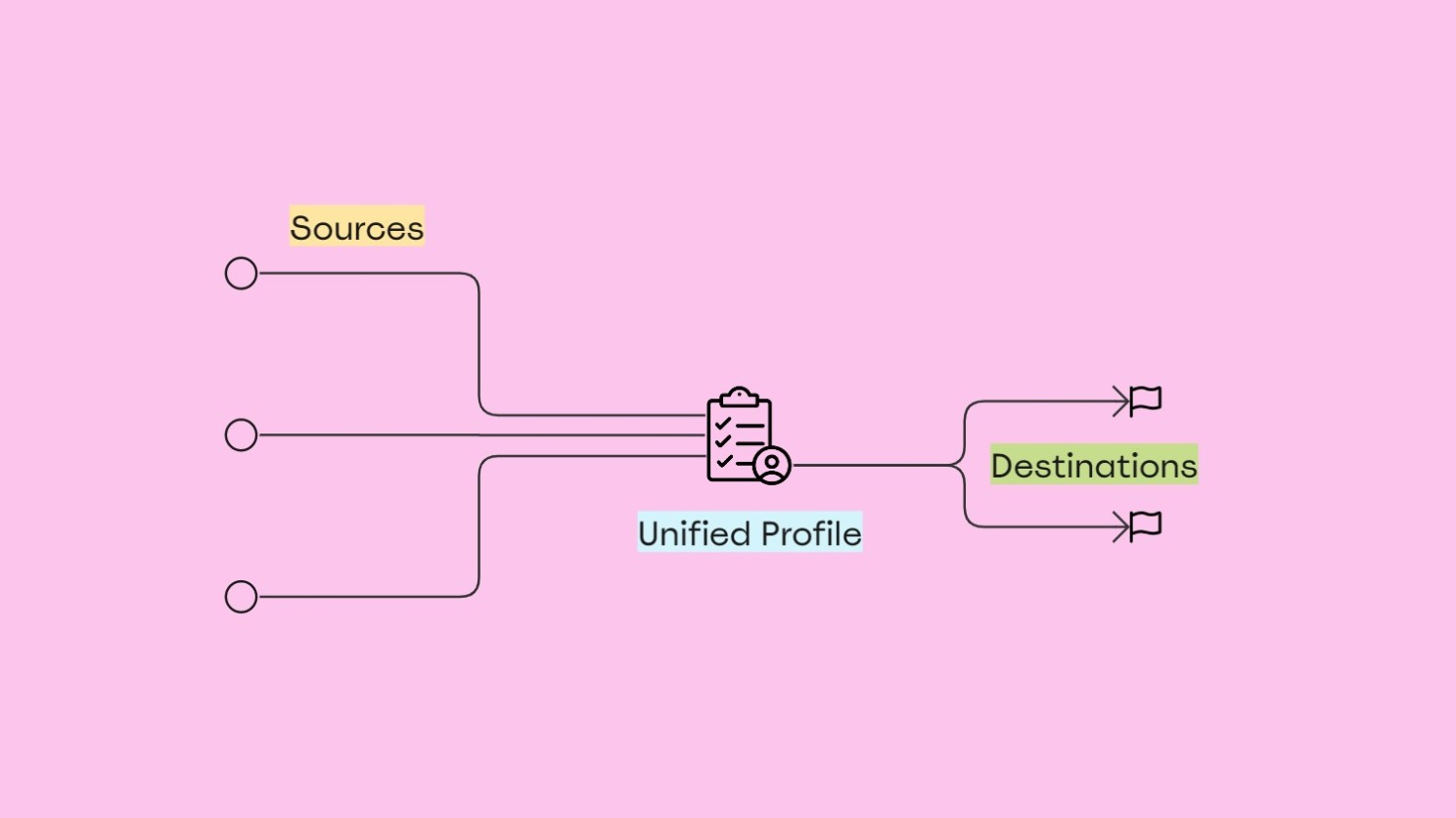

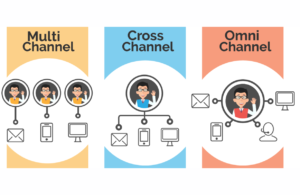

Vu la multitude d’interactions que vos clients ont avec votre marque, il est naturel que vous ayez accès à un volume important de données vous informant sur leur parcours d’achat, et leur comportement.

Un bon retailer aura tendance à combiner ses données clients provenant de plusieurs sources (tels que leurs propres programmes de fidélité, les systèmes de points de vente, les historiques d’achats, etc.) avec des données complémentaires achetées auprès de courtiers. Les détaillants font également une distinction entre les « clients » (les personnes qui ont déjà fait affaire avec eux) et les « consommateurs » (qui comprennent ceux qui pourraient être de bons prospects).

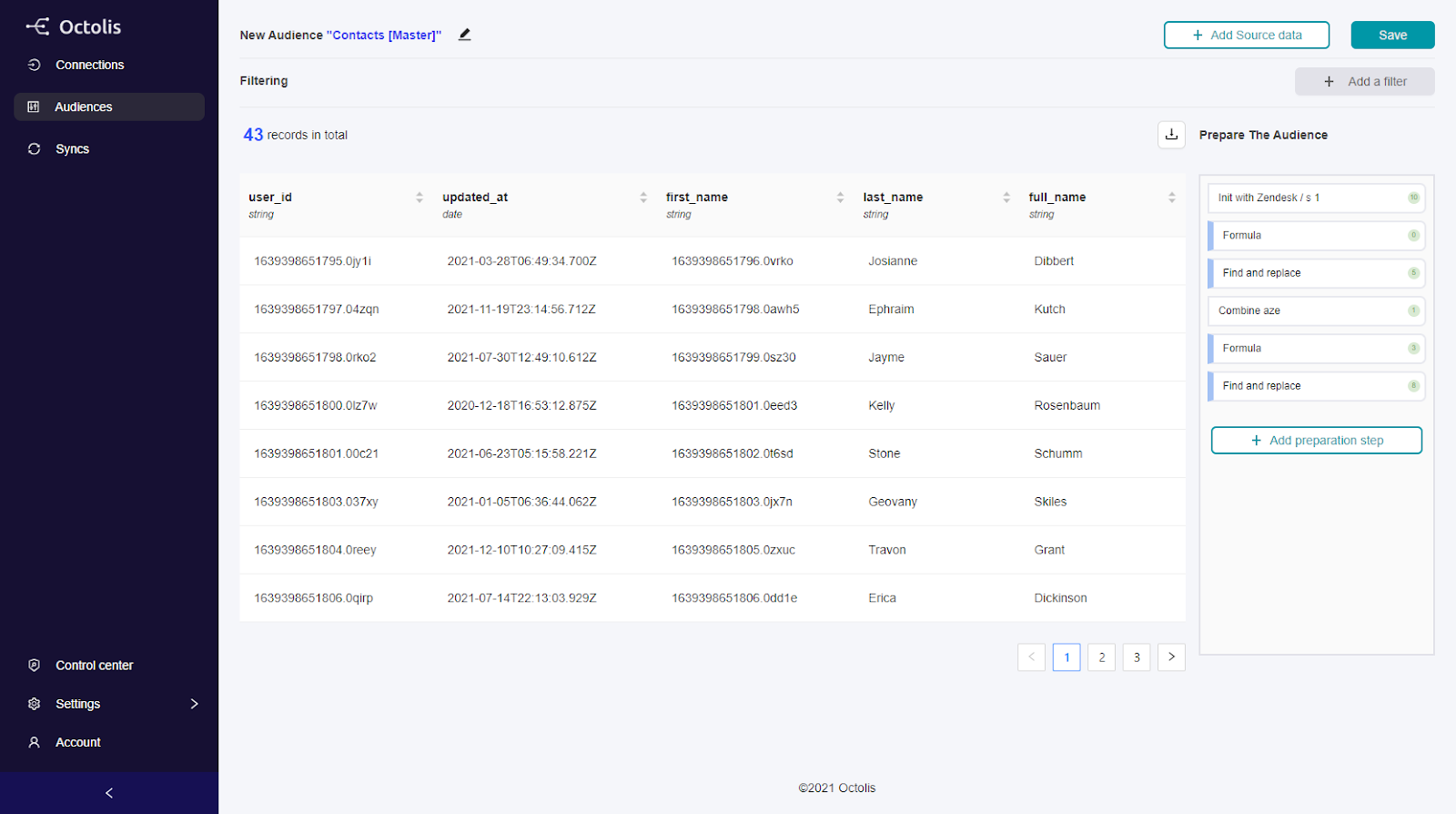

Les données de ces derniers peuvent contribuer à éclairer la « modélisation d’audiences looka like » – par exemple, un détaillant identifie Mark comme un excellent client, puis recherche d’autres personnes ayant des attributs similaires et les cibles avec des offres spéciales.

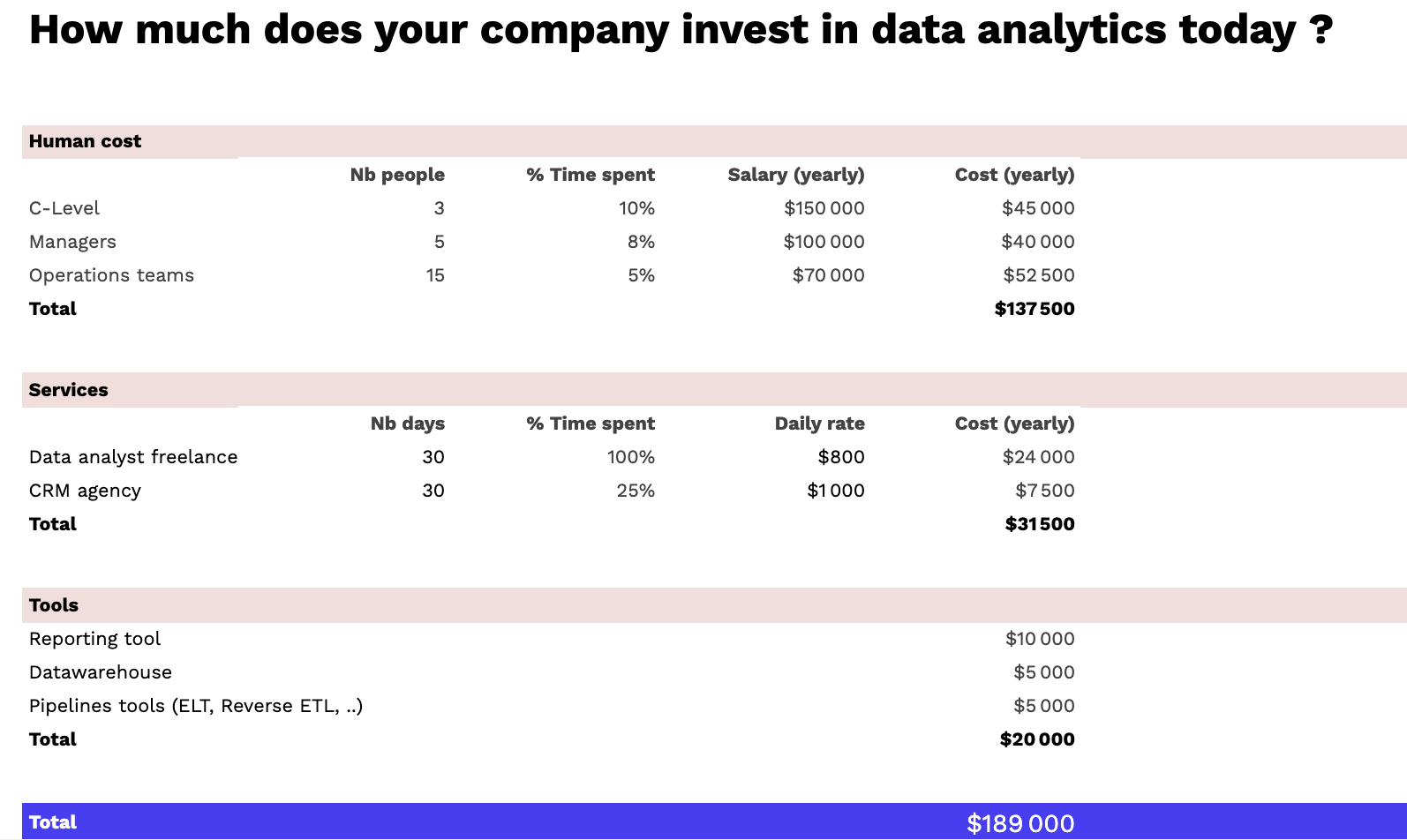

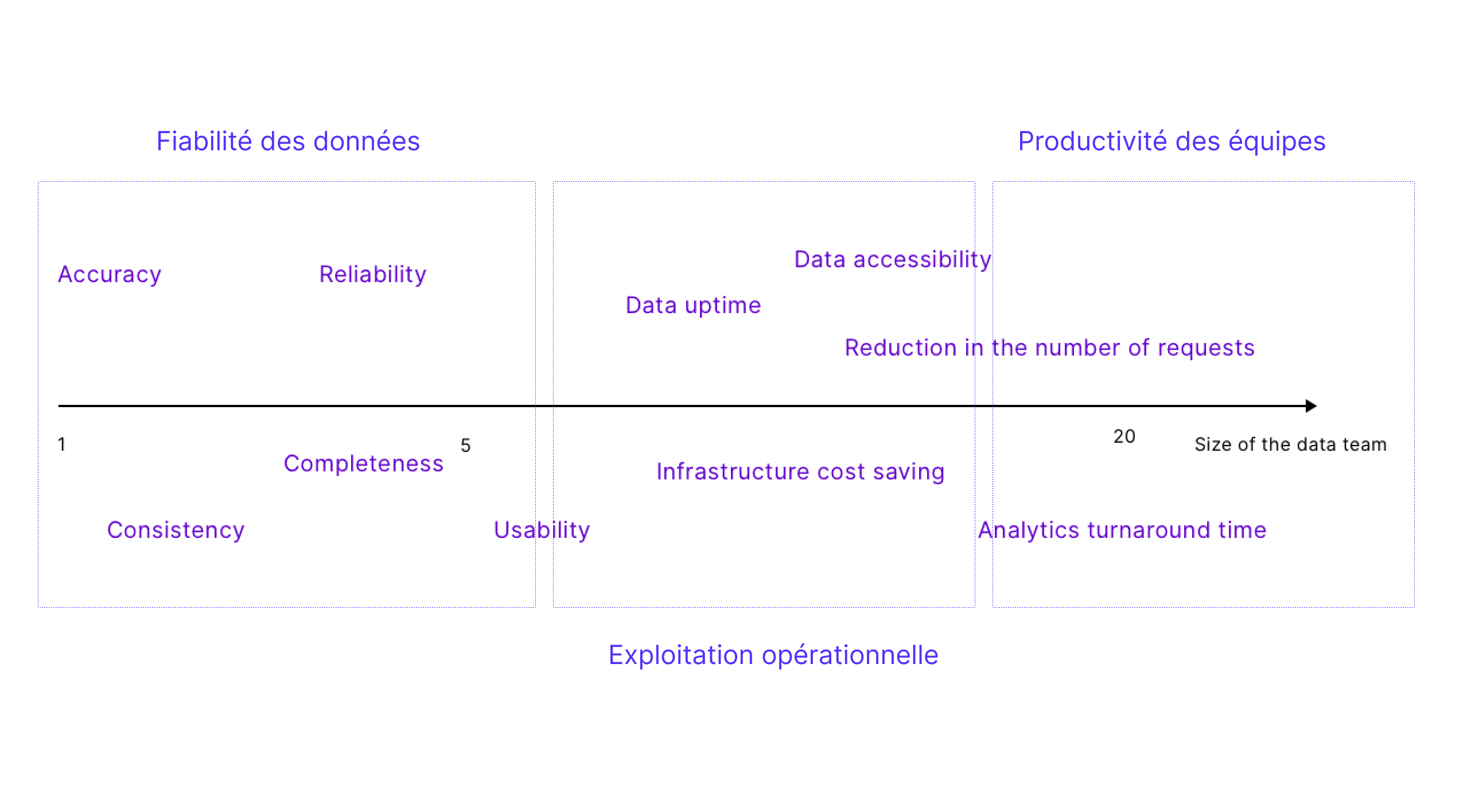

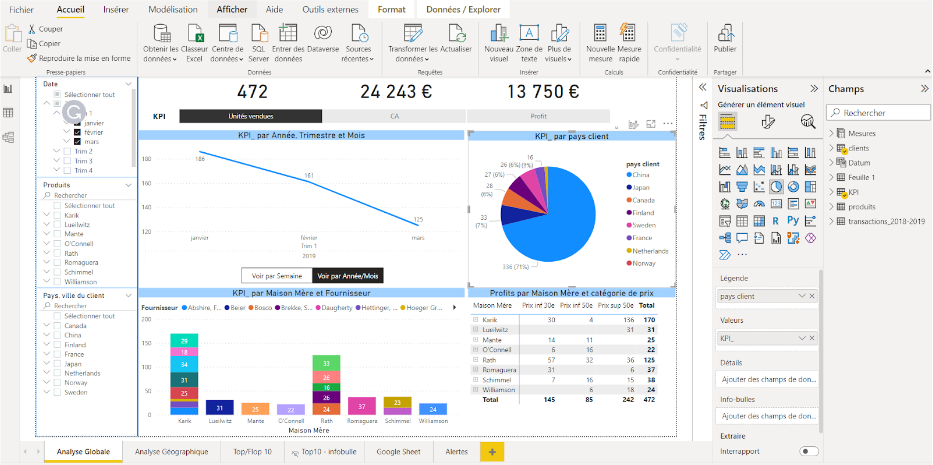

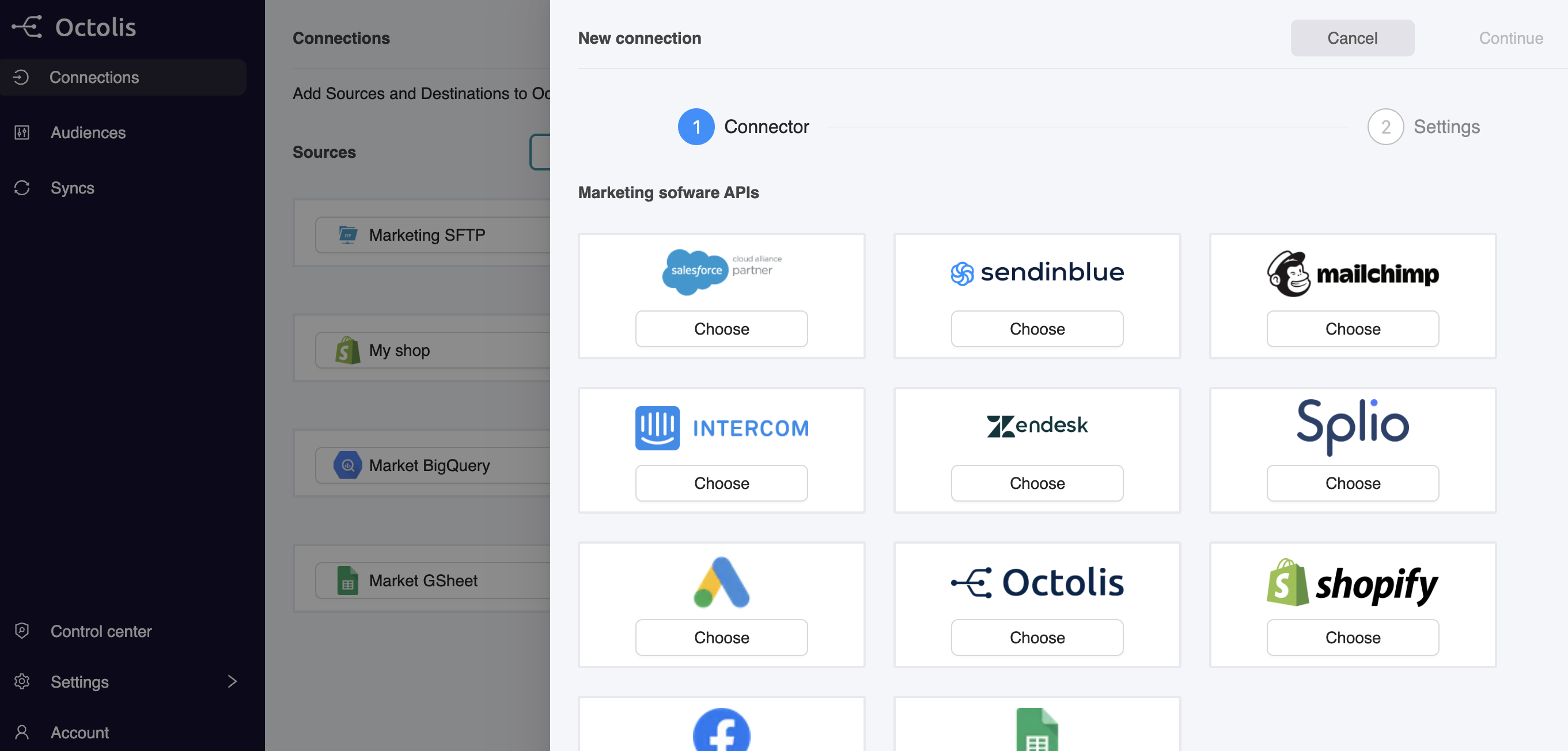

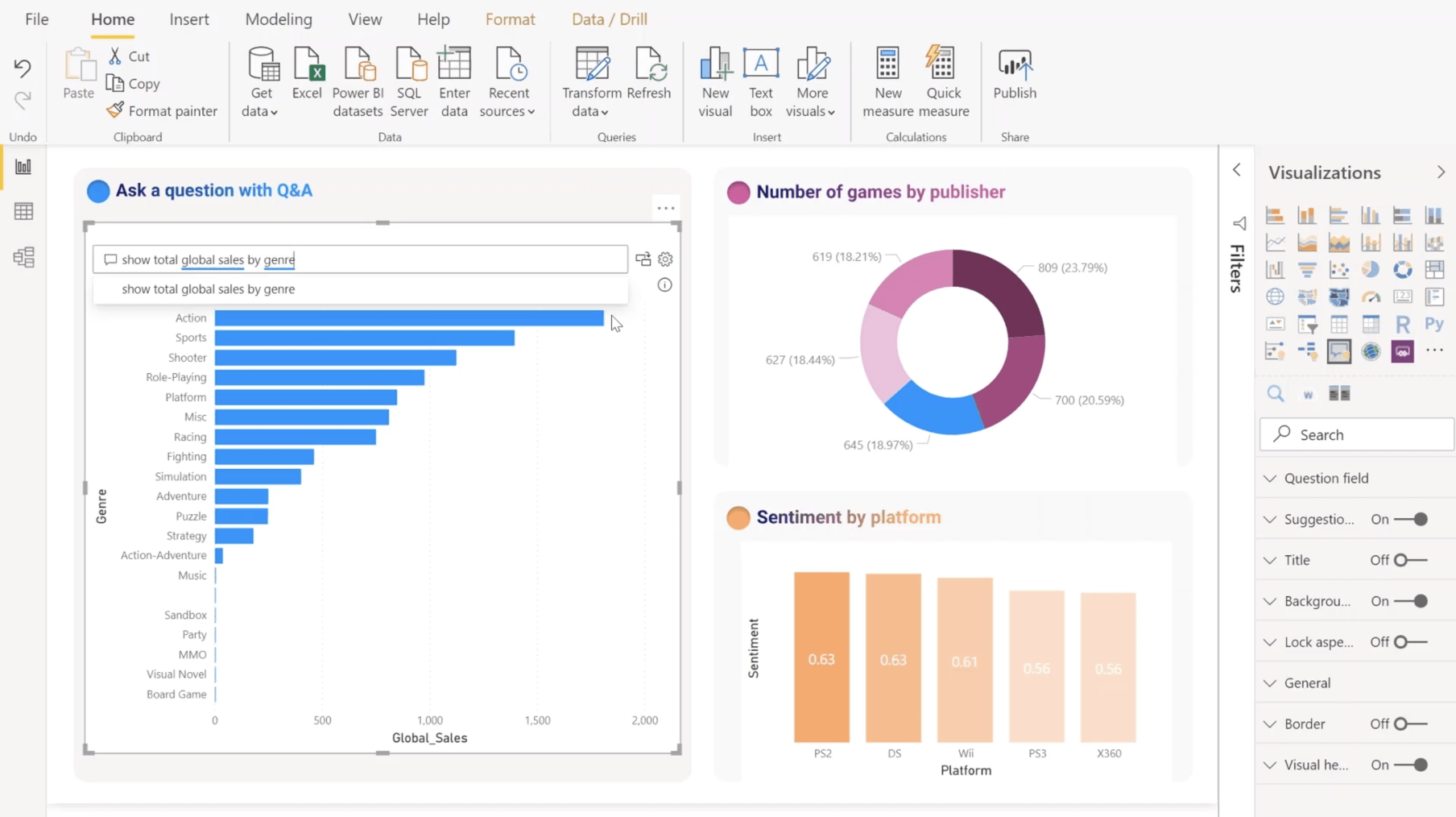

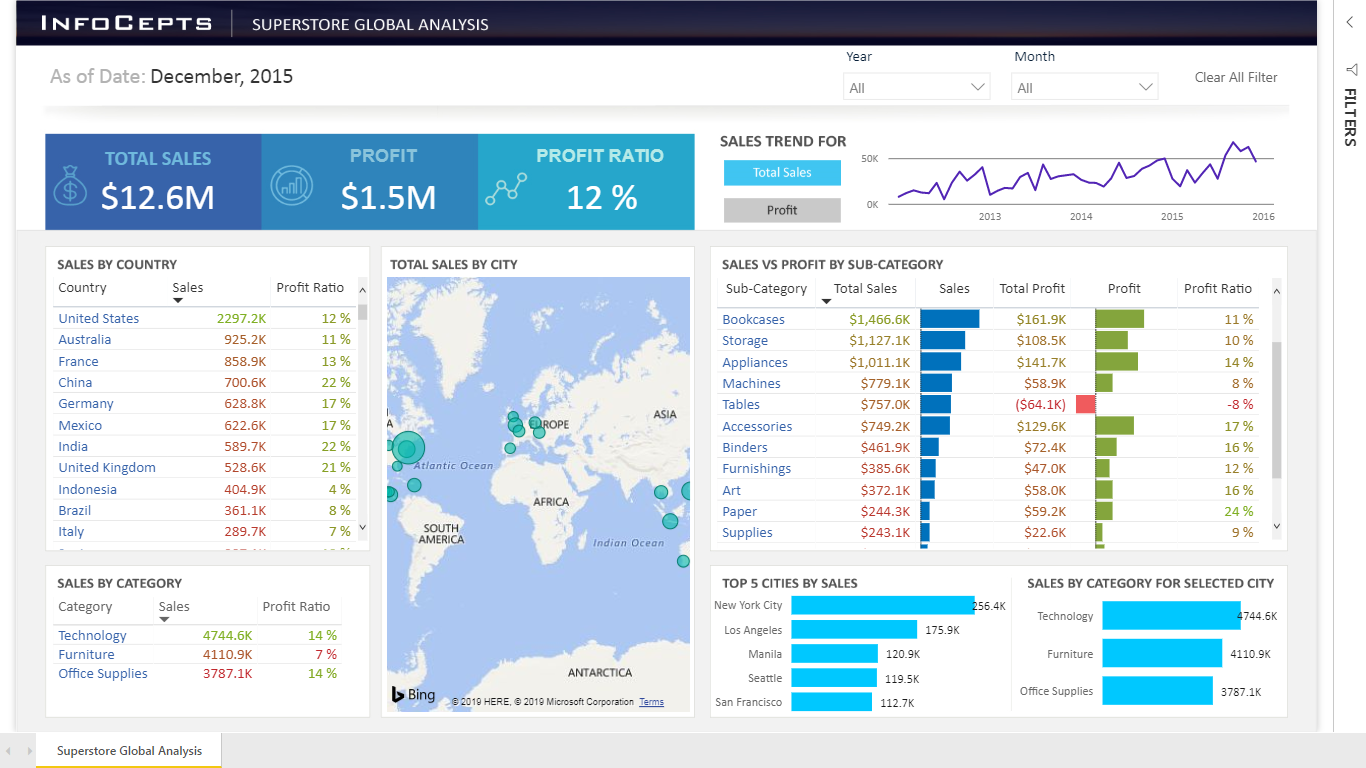

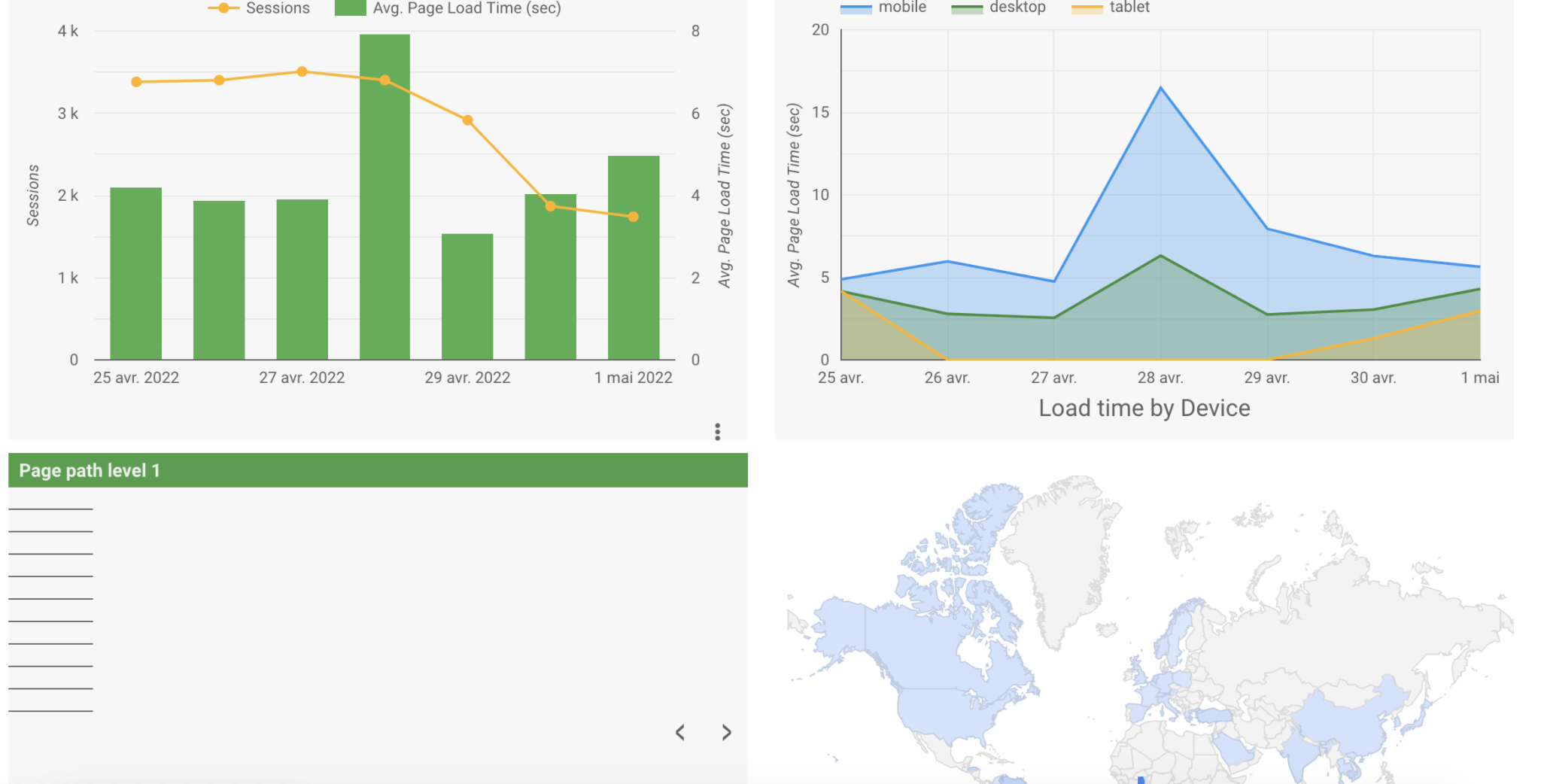

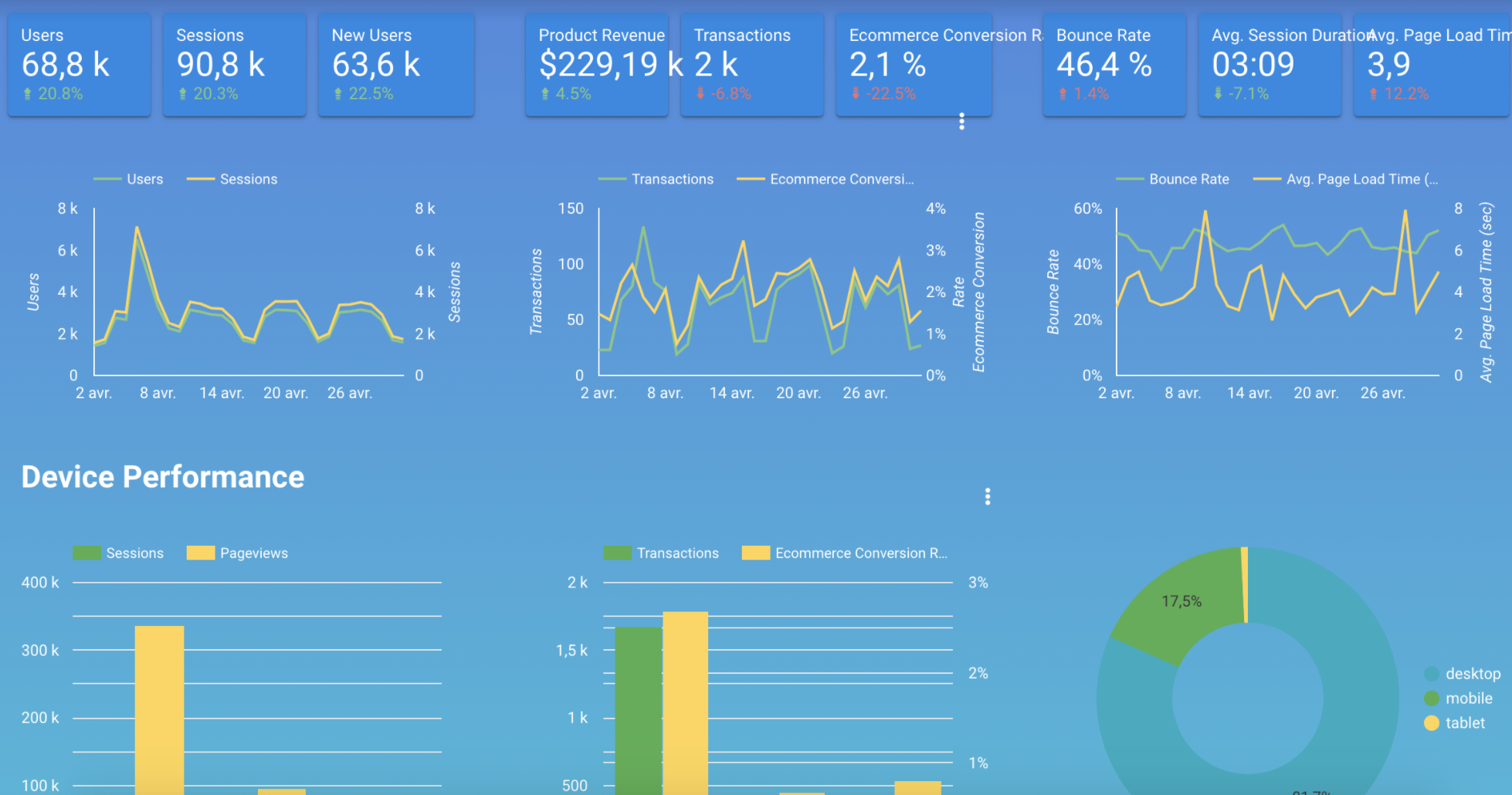

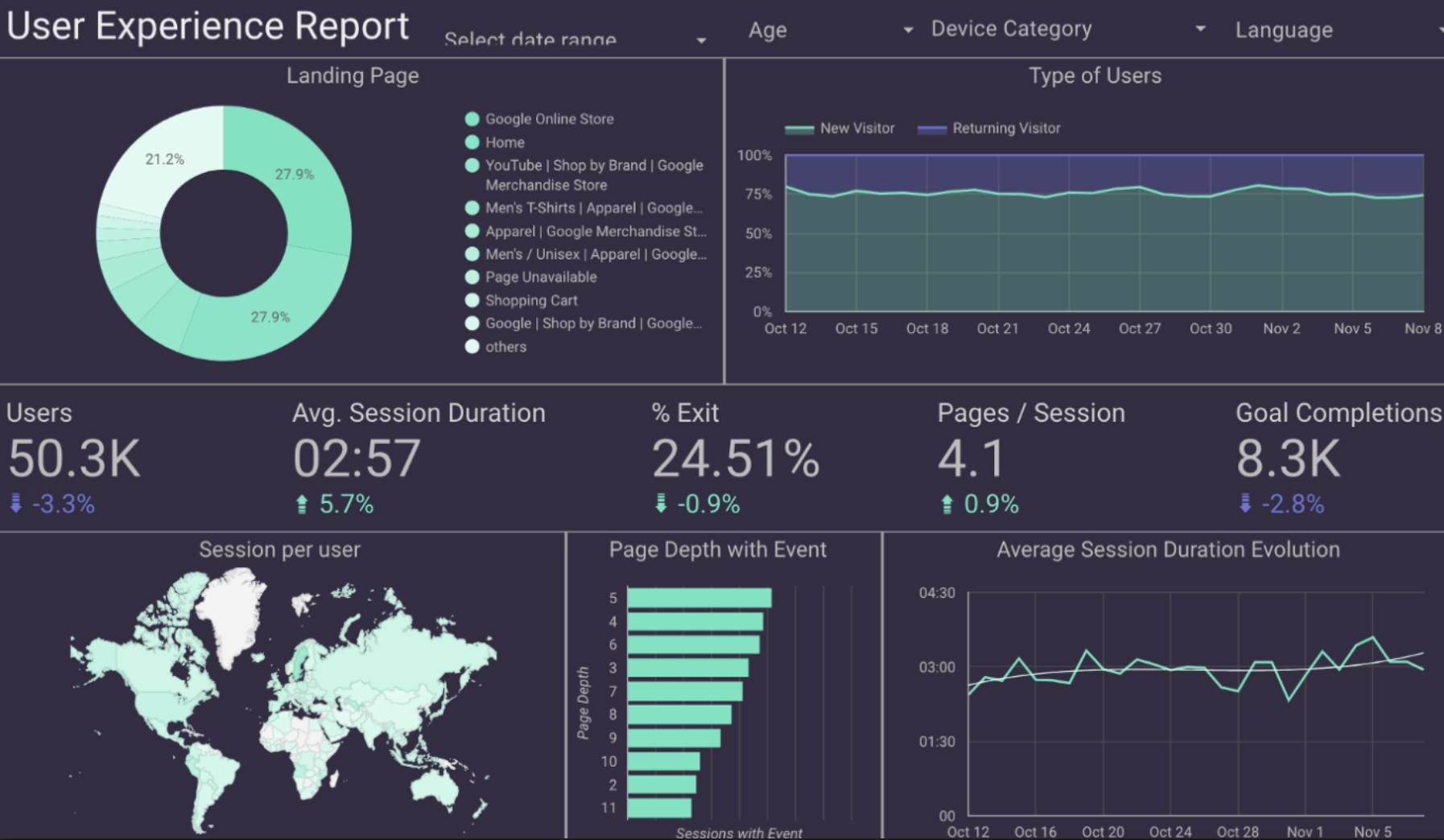

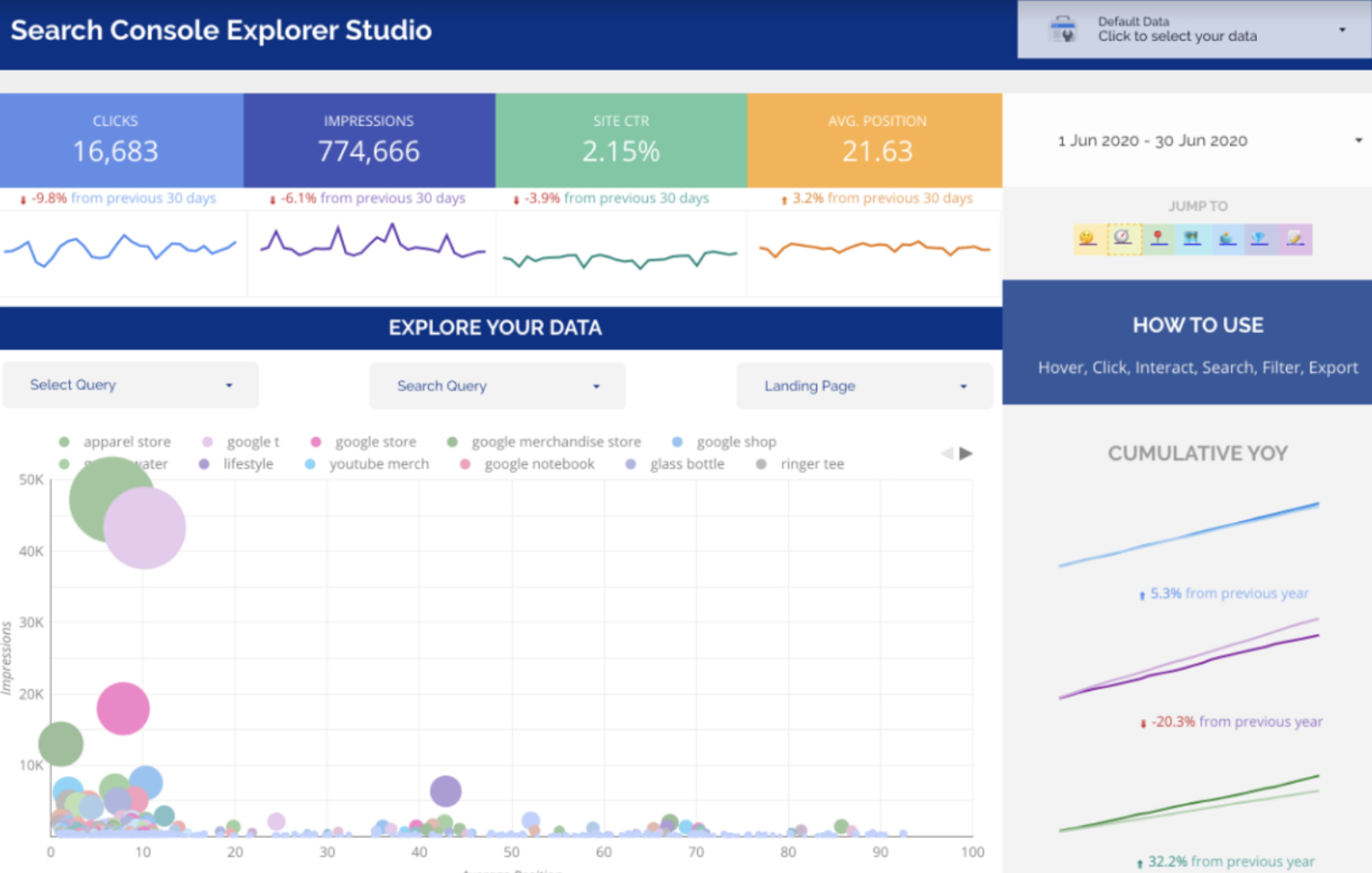

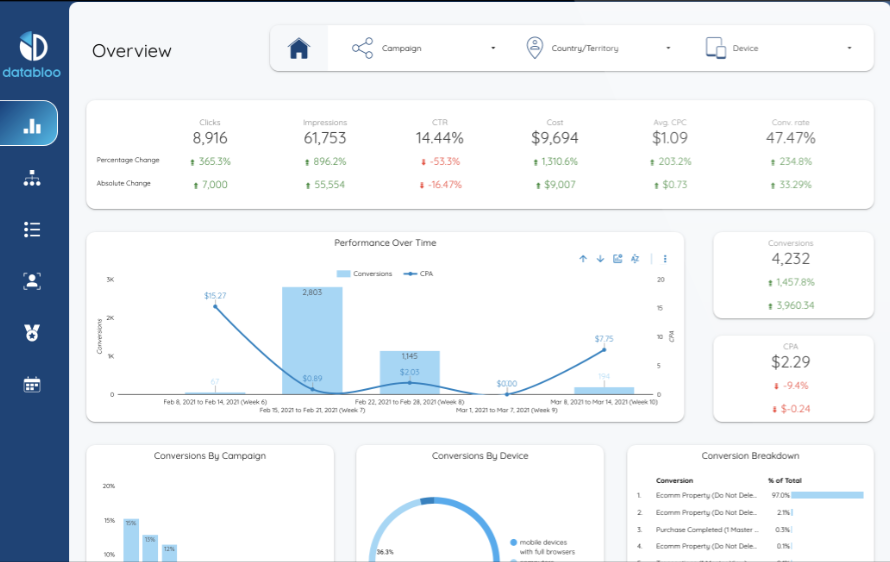

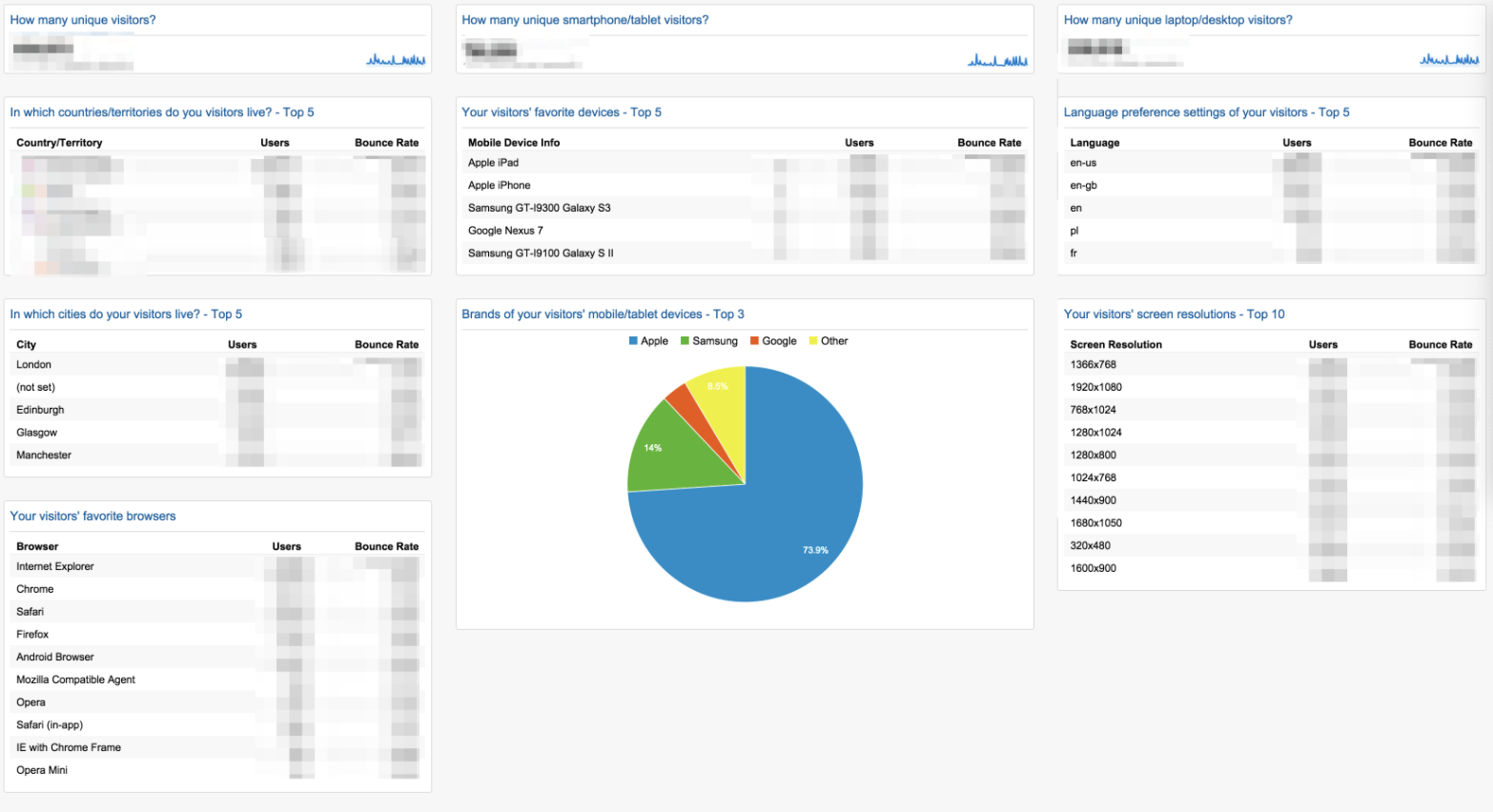

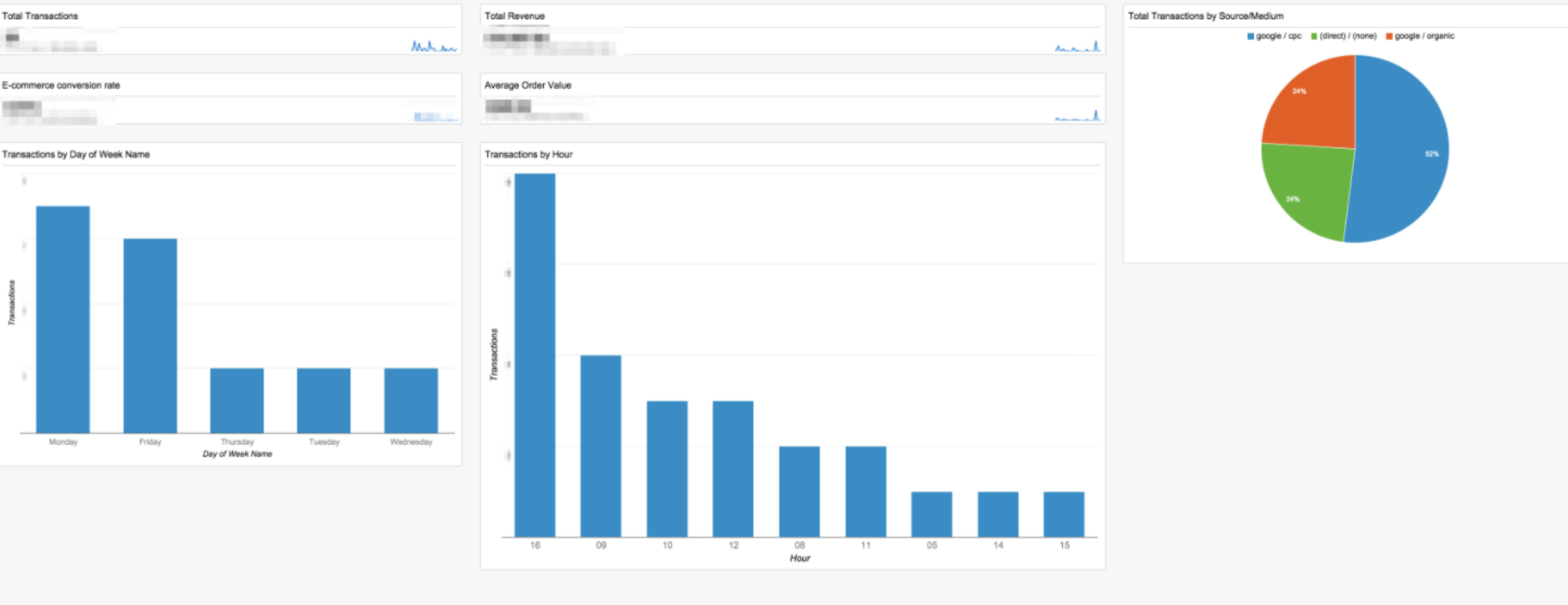

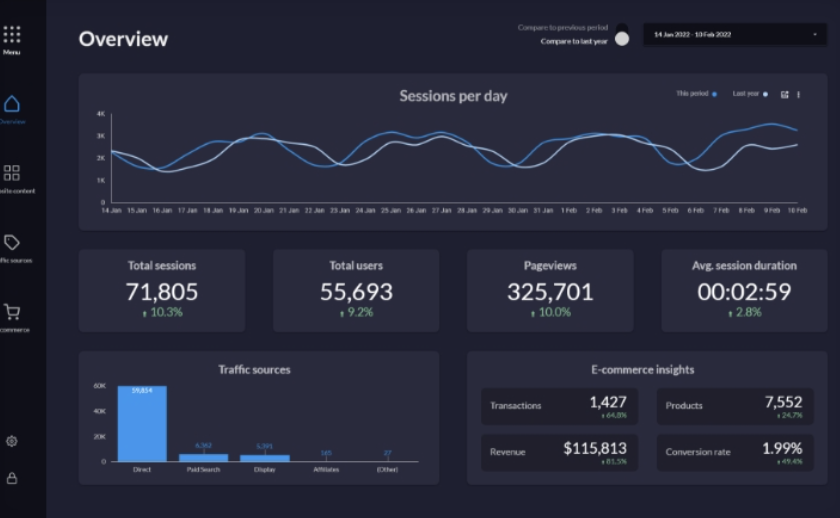

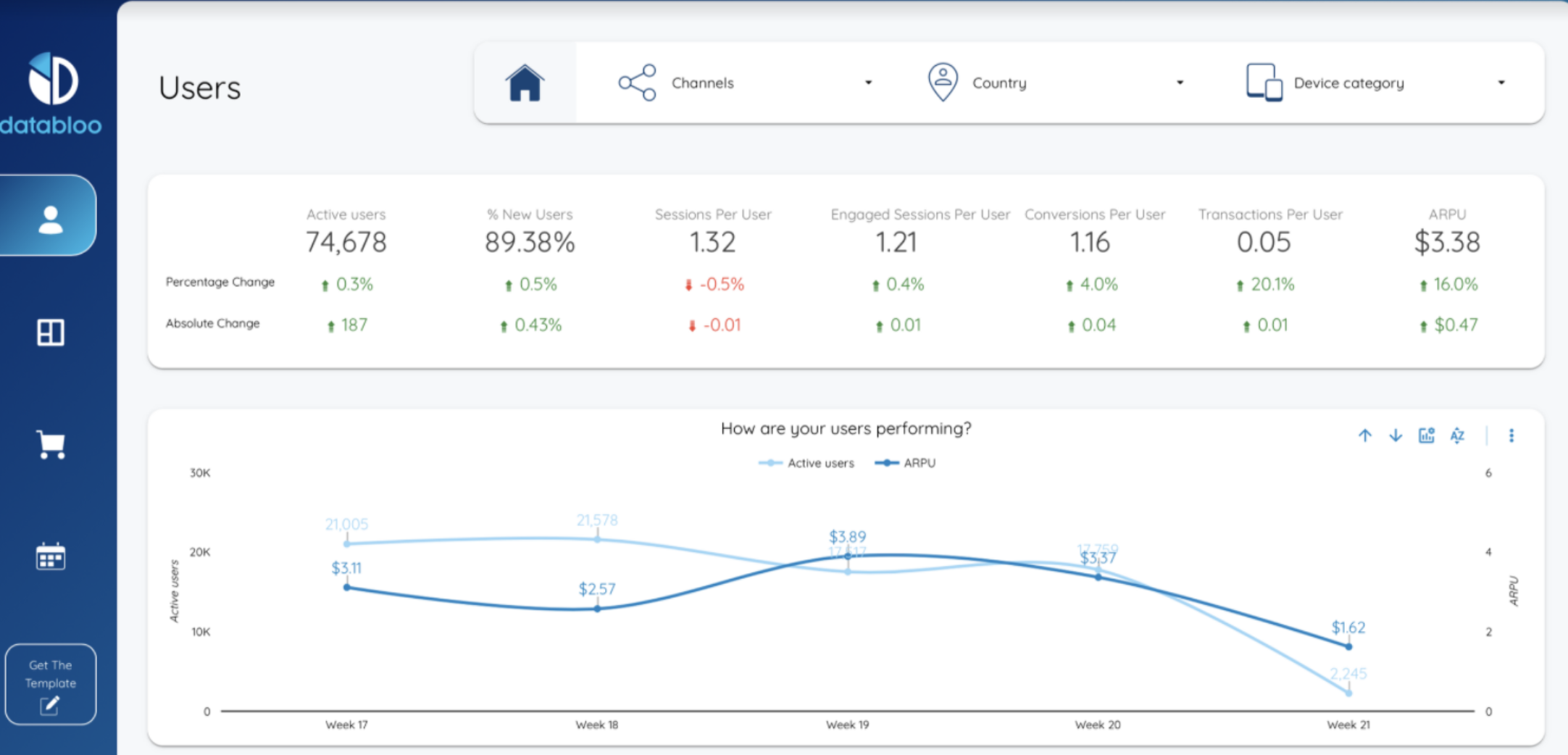

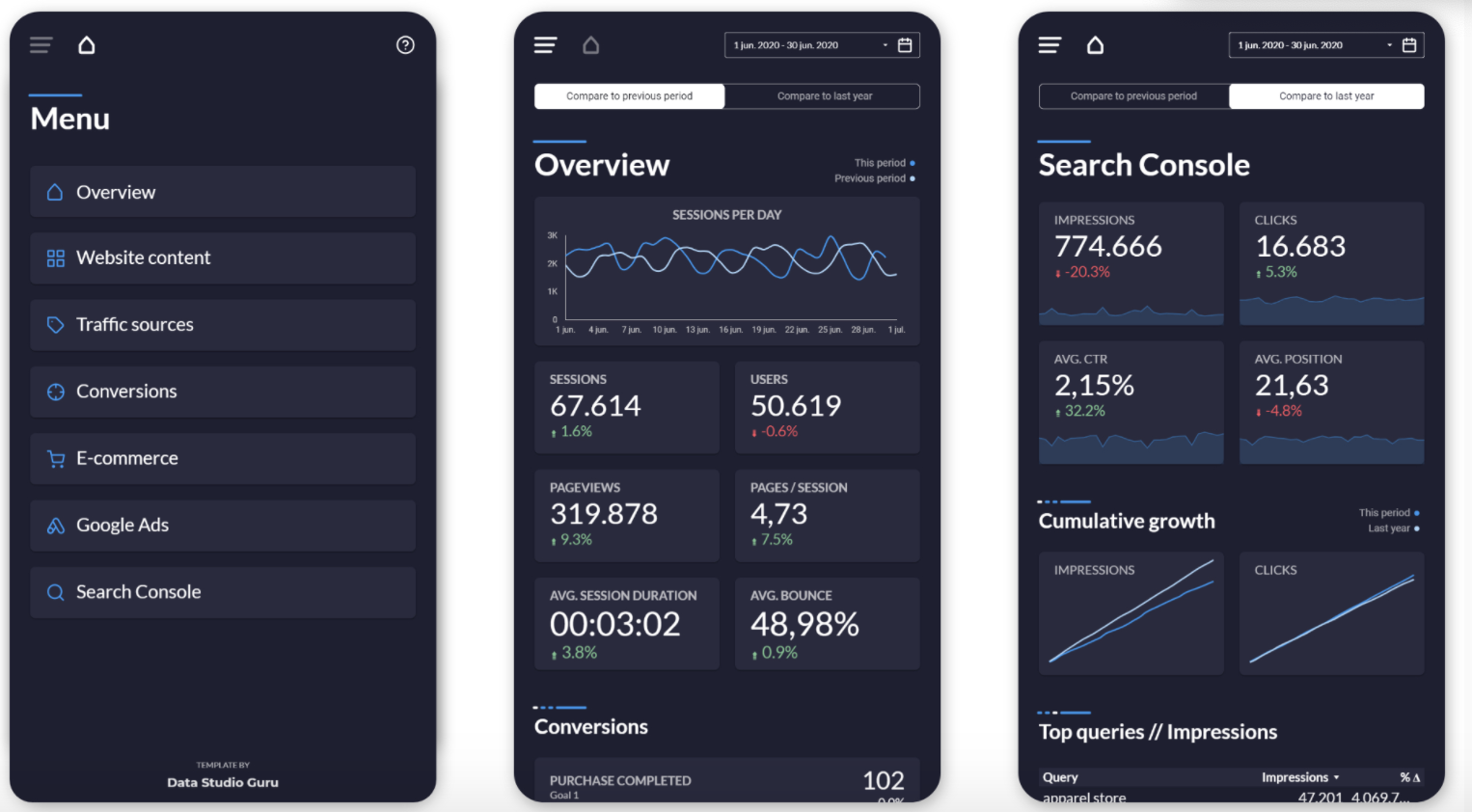

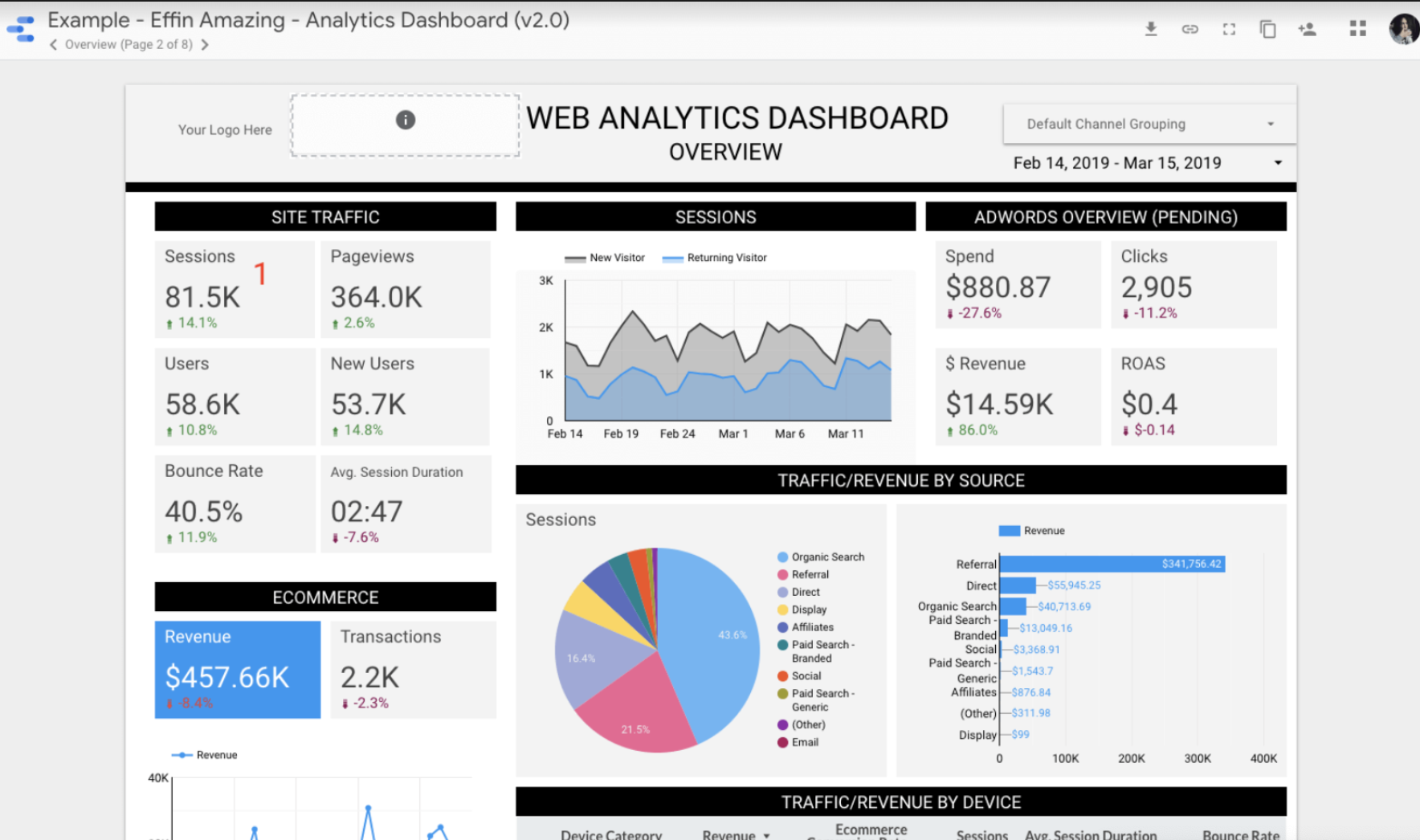

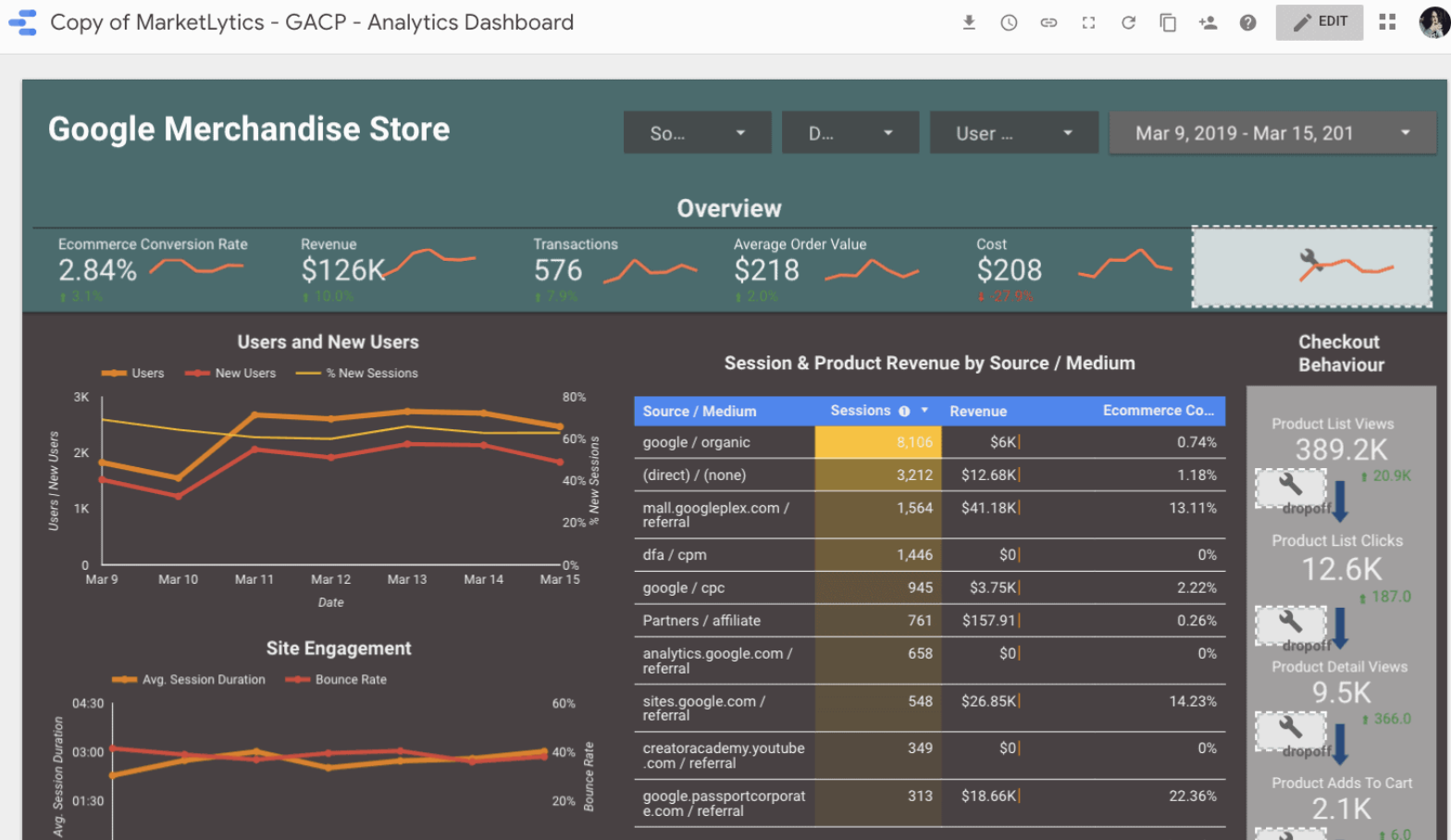

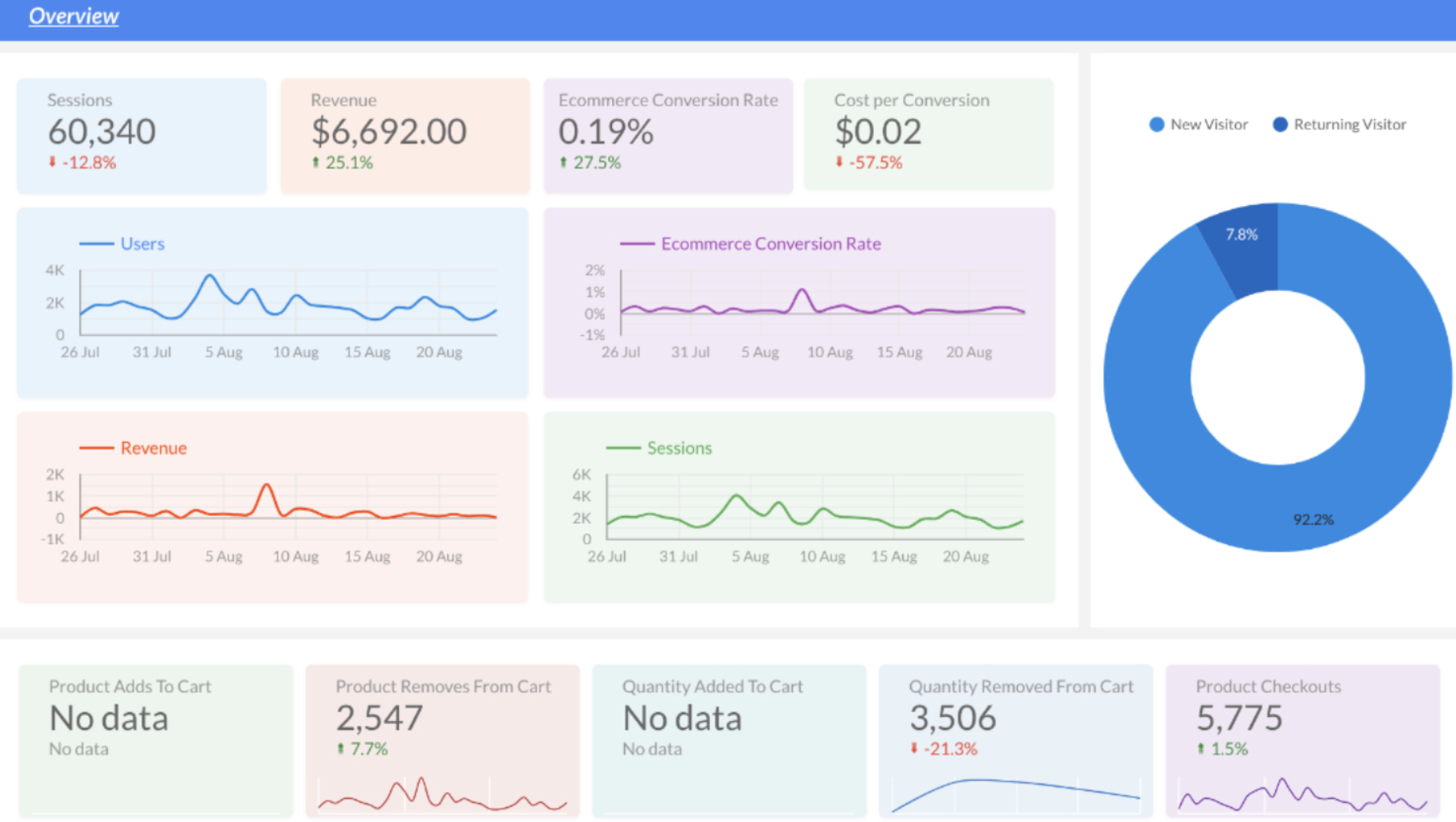

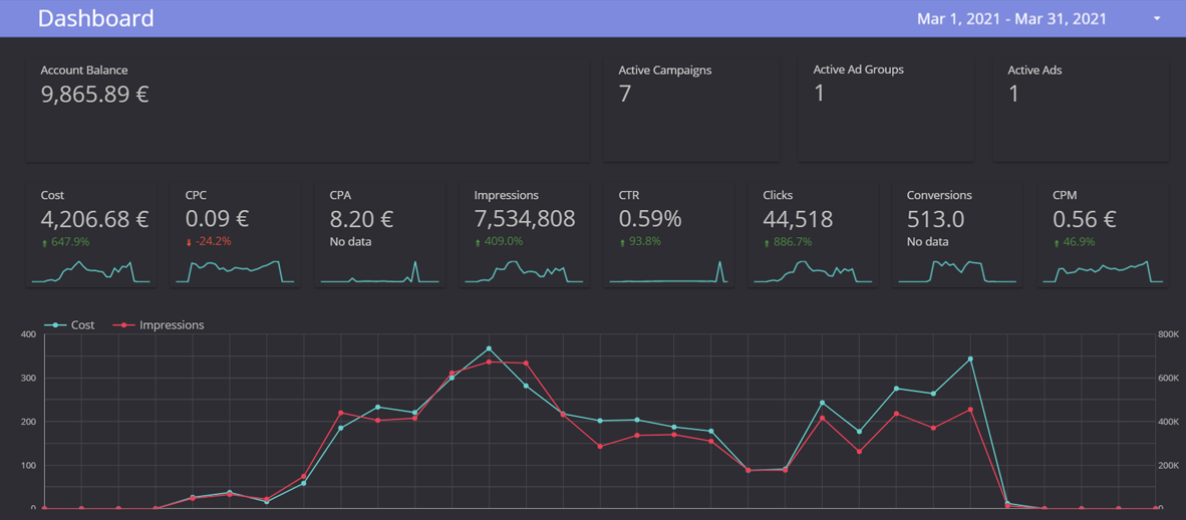

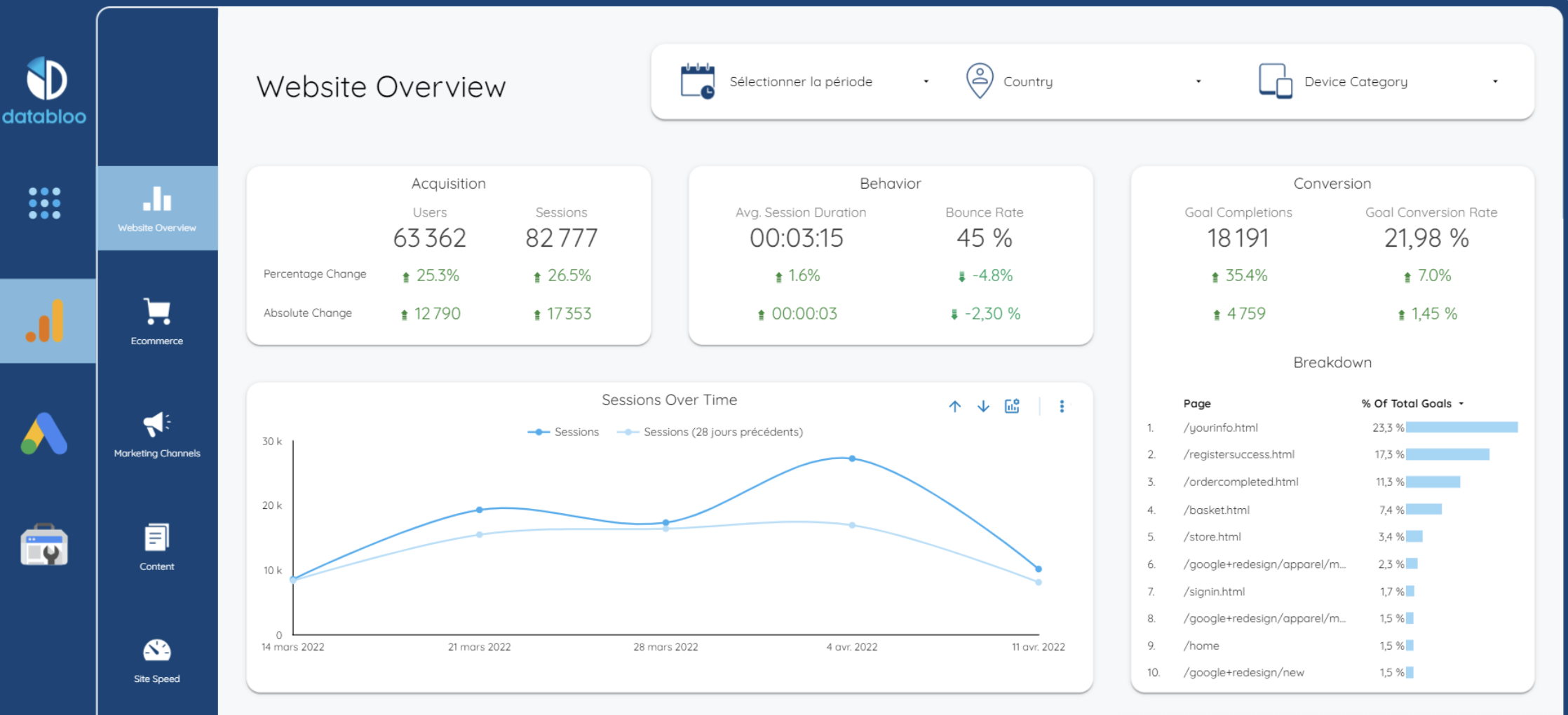

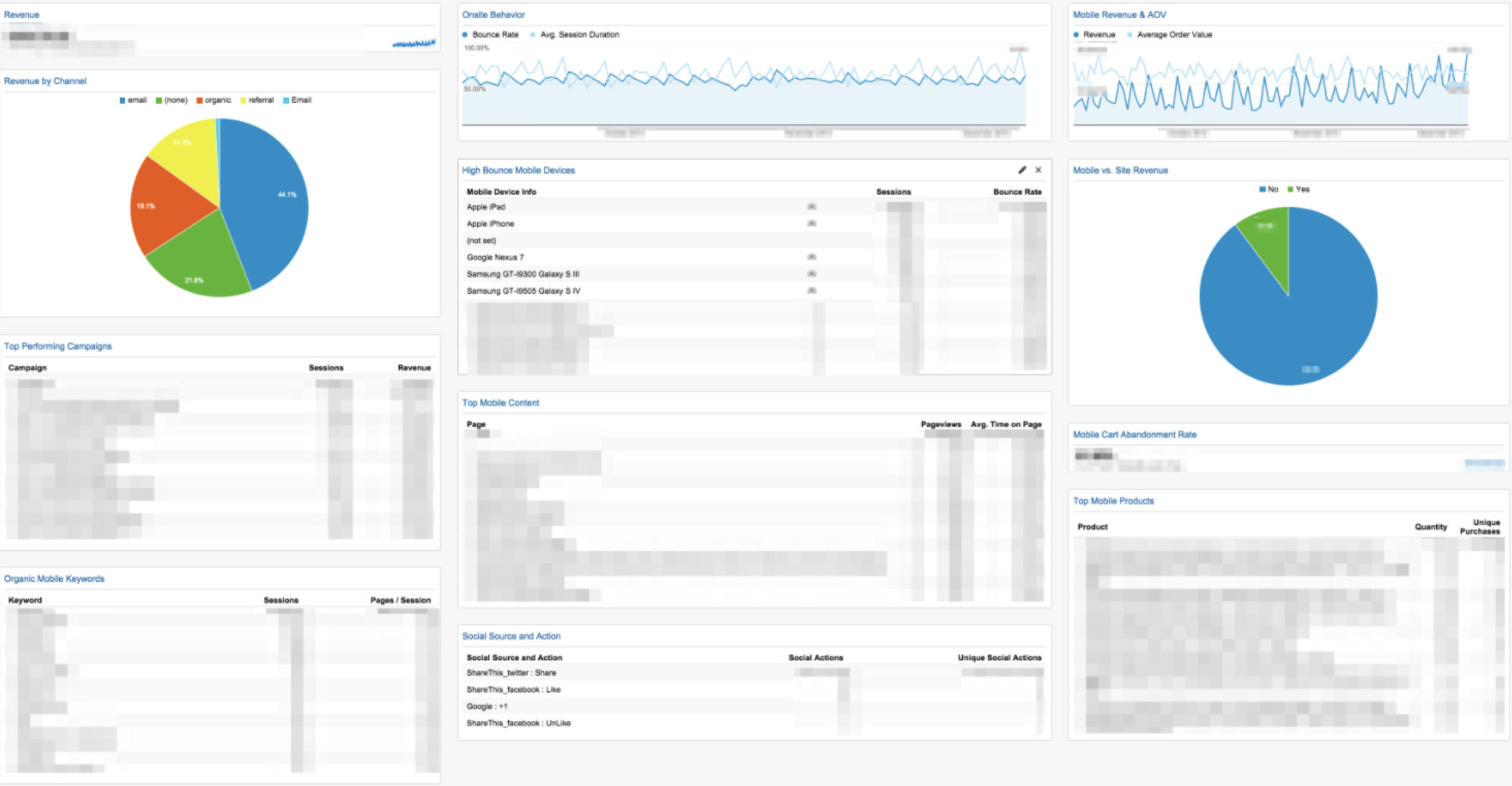

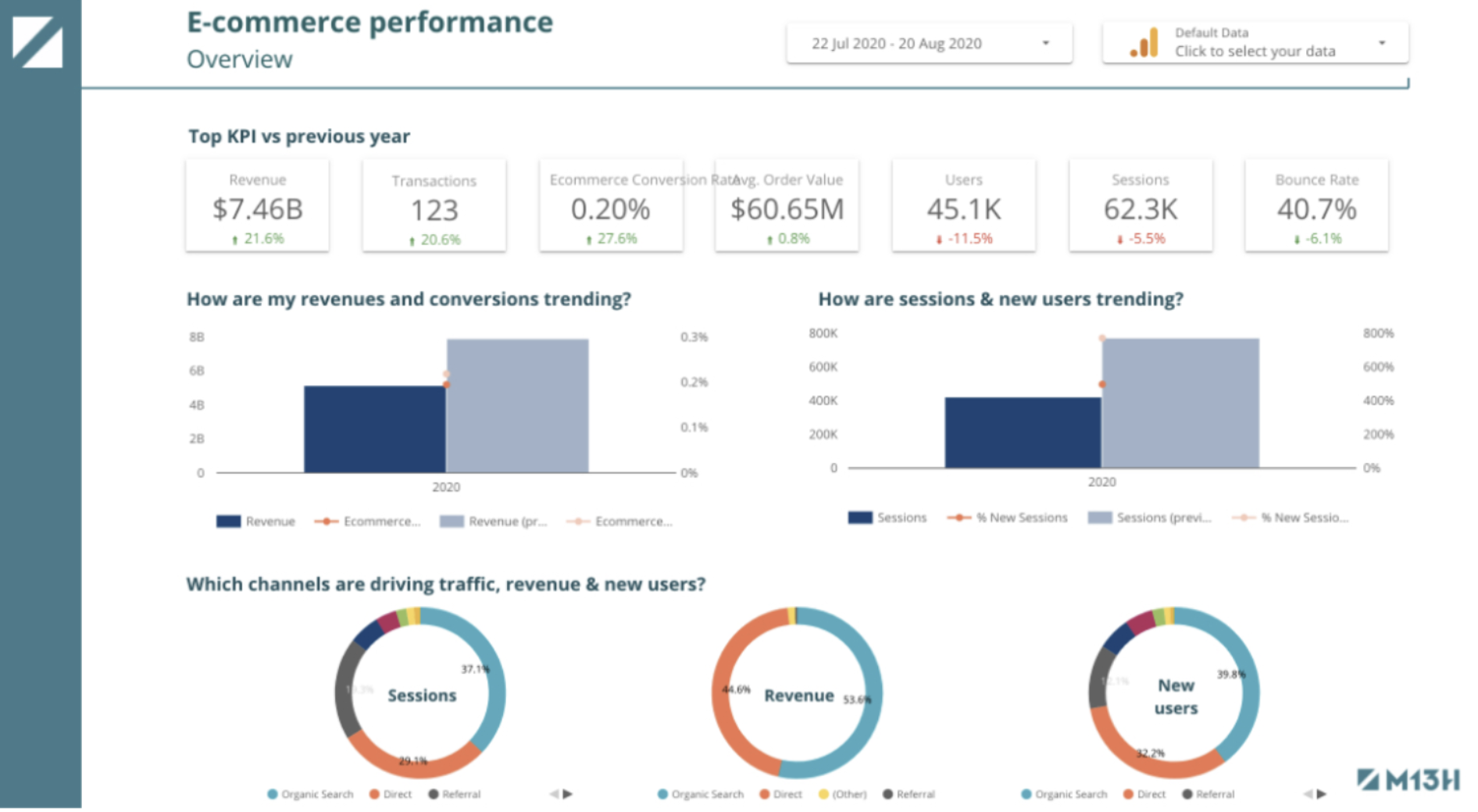

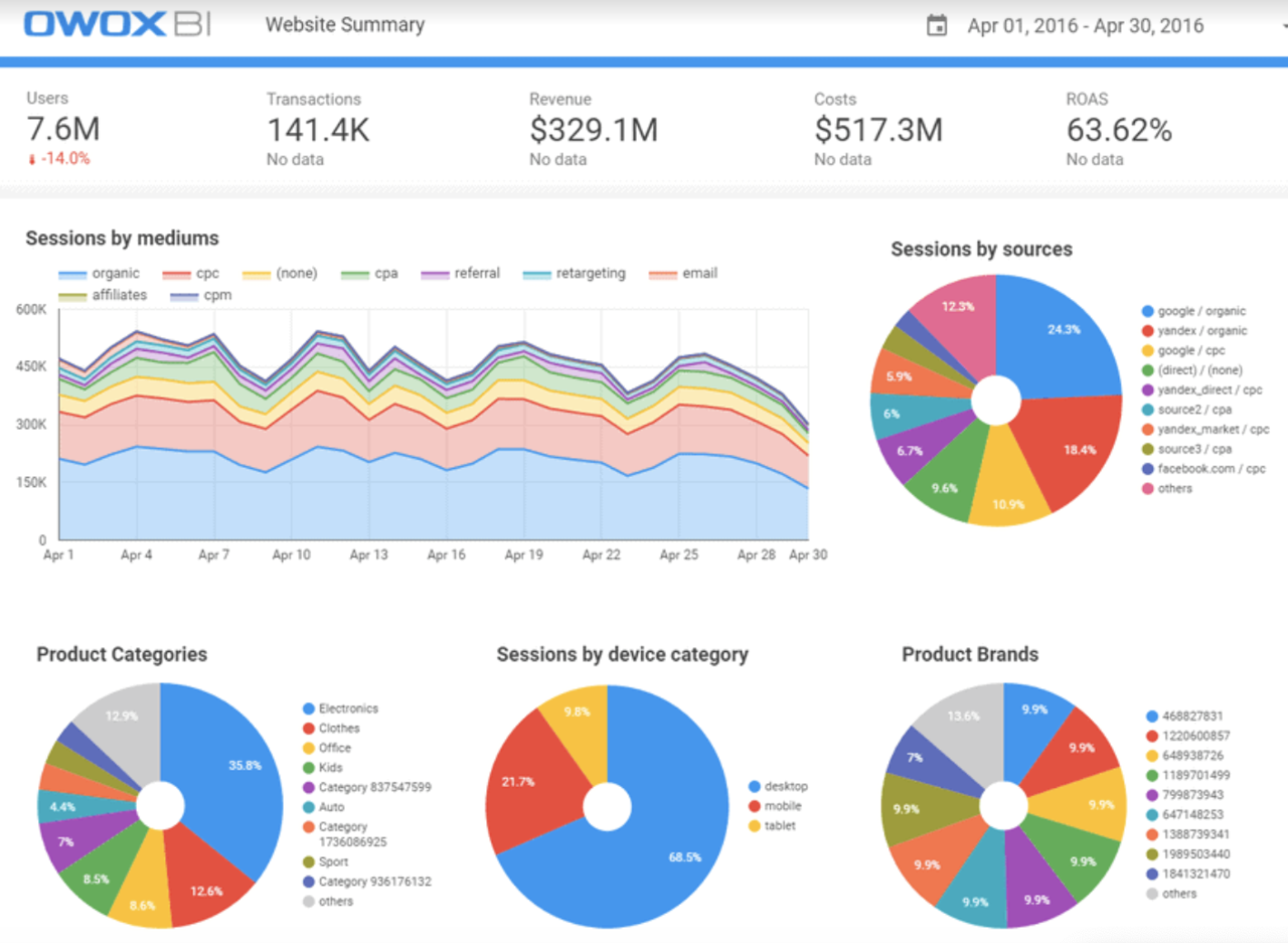

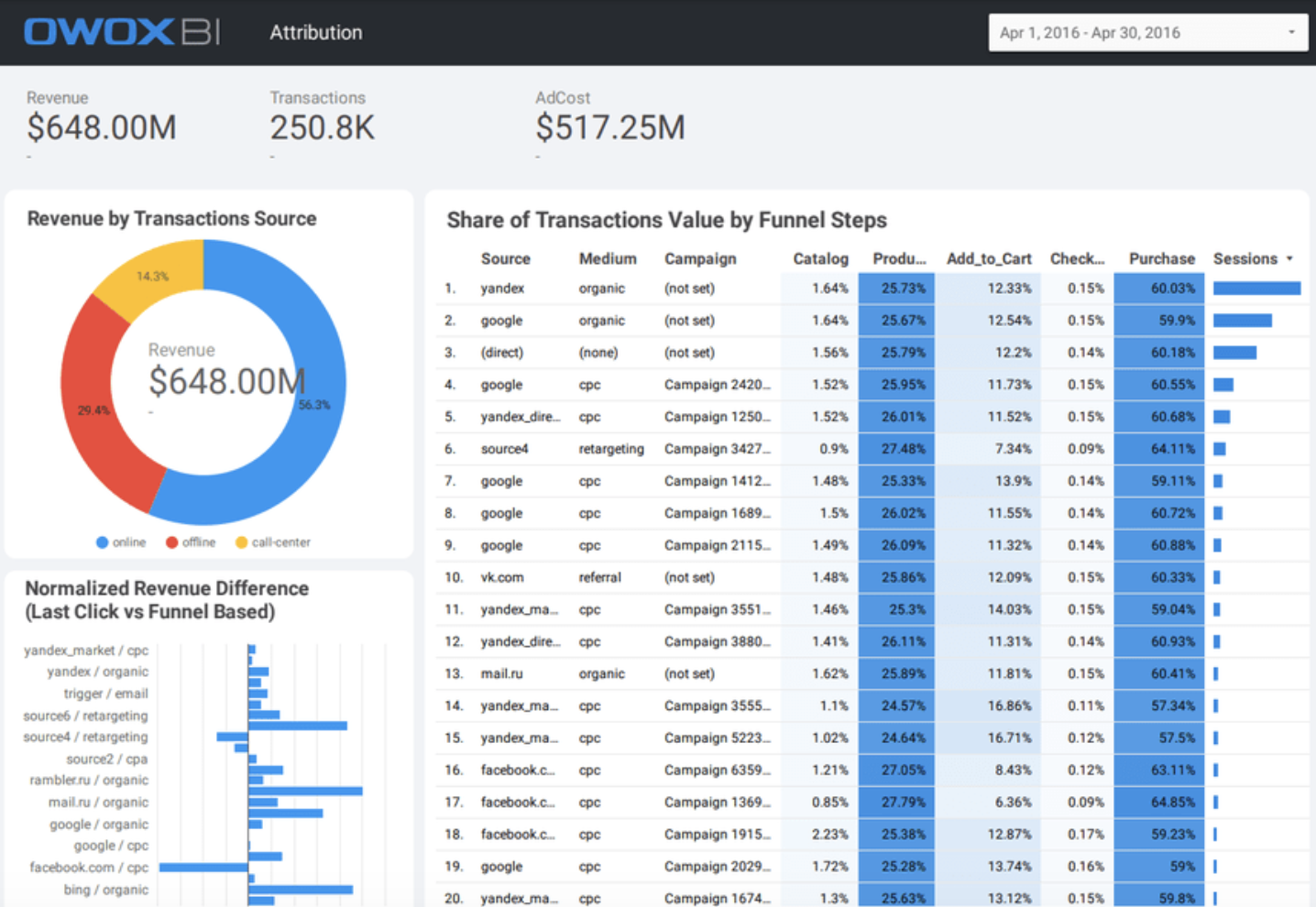

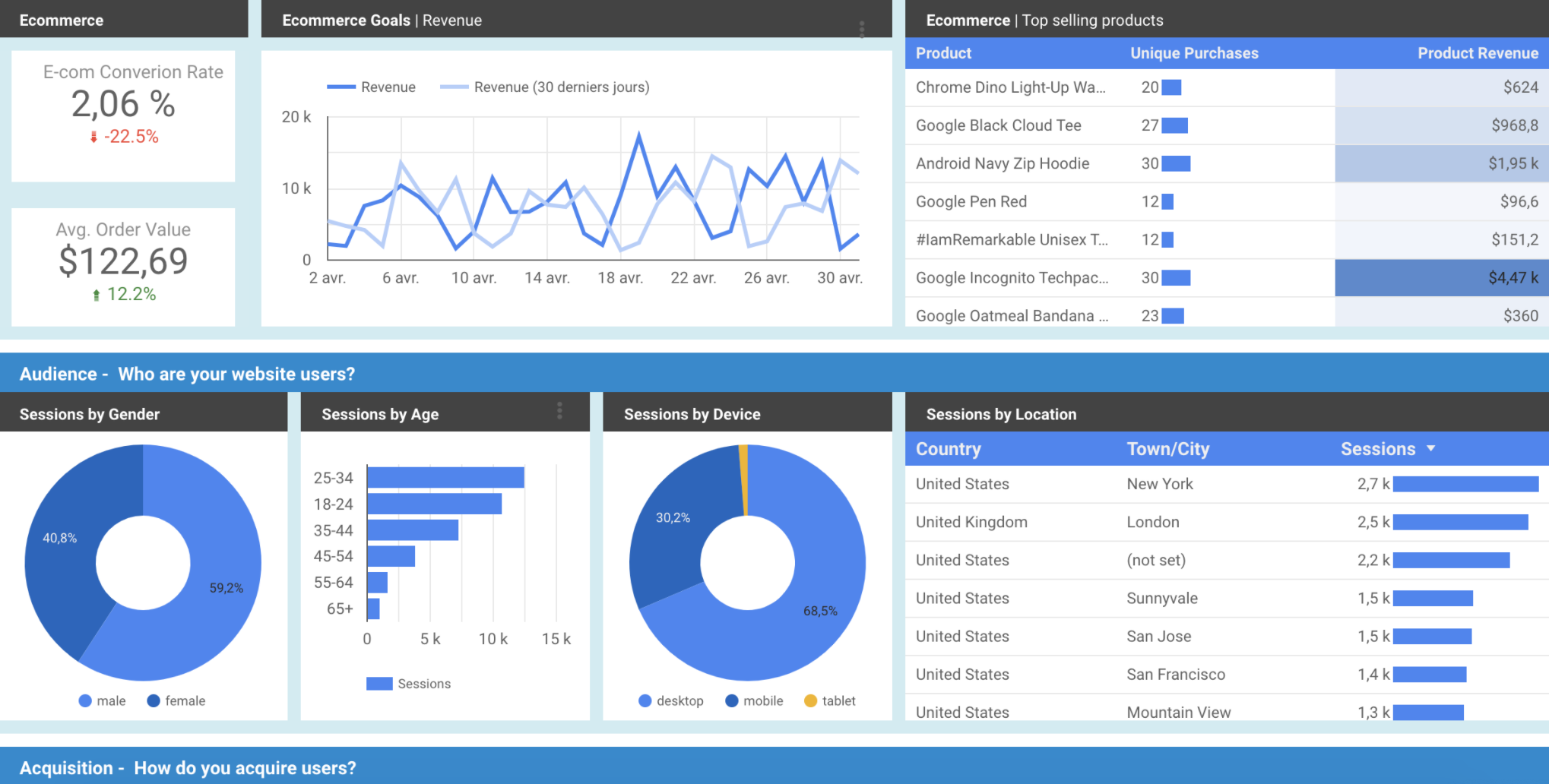

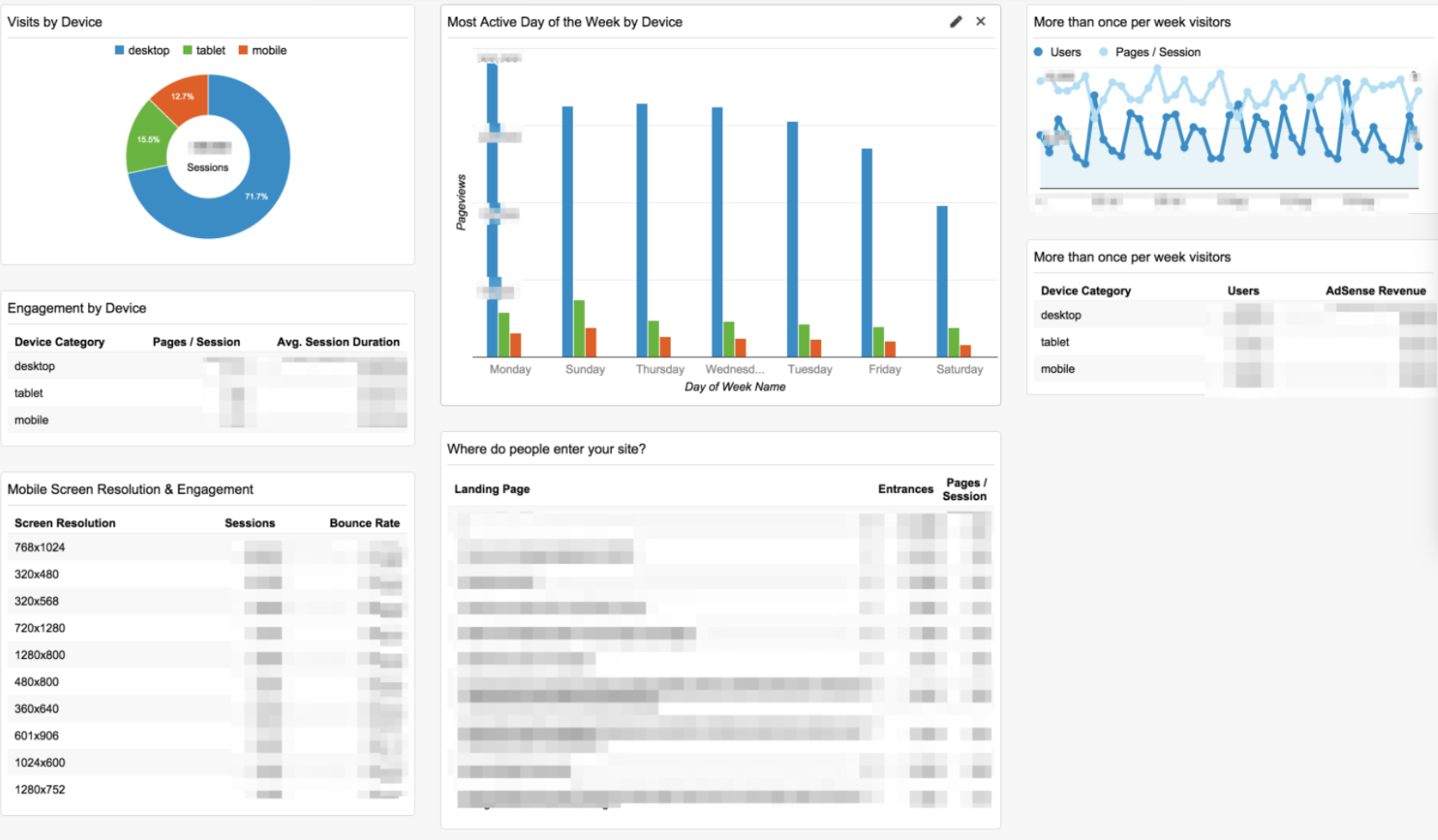

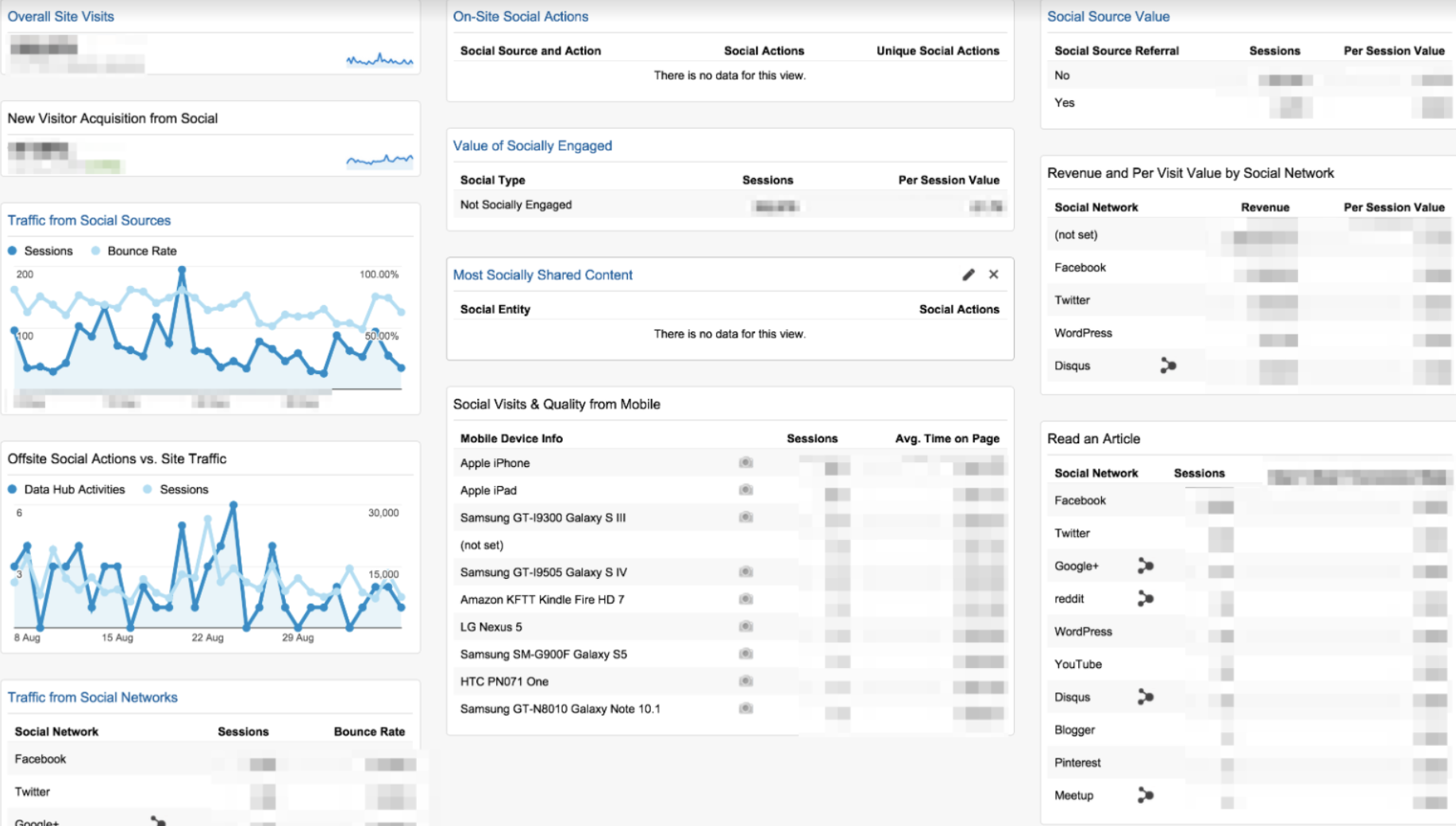

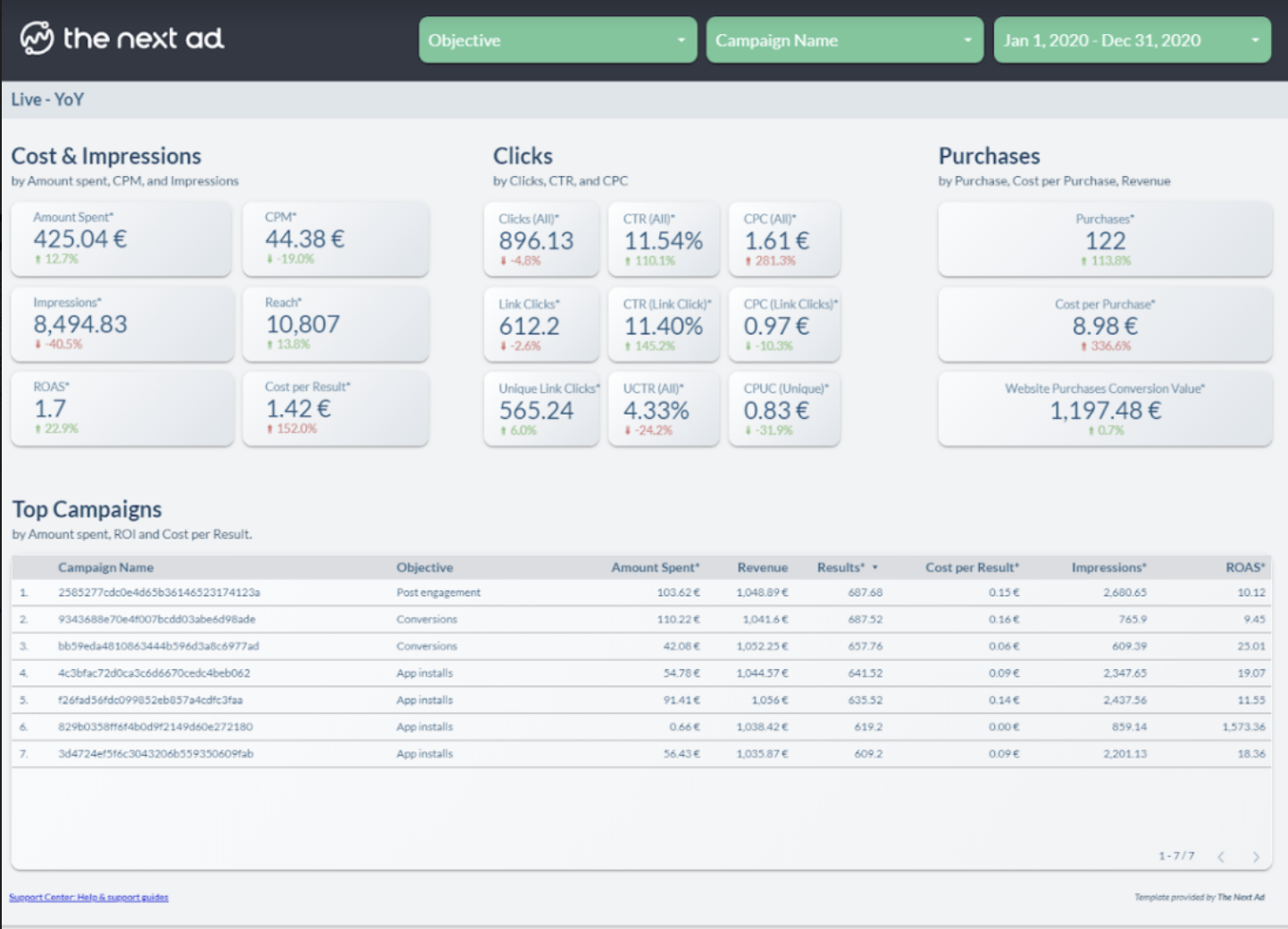

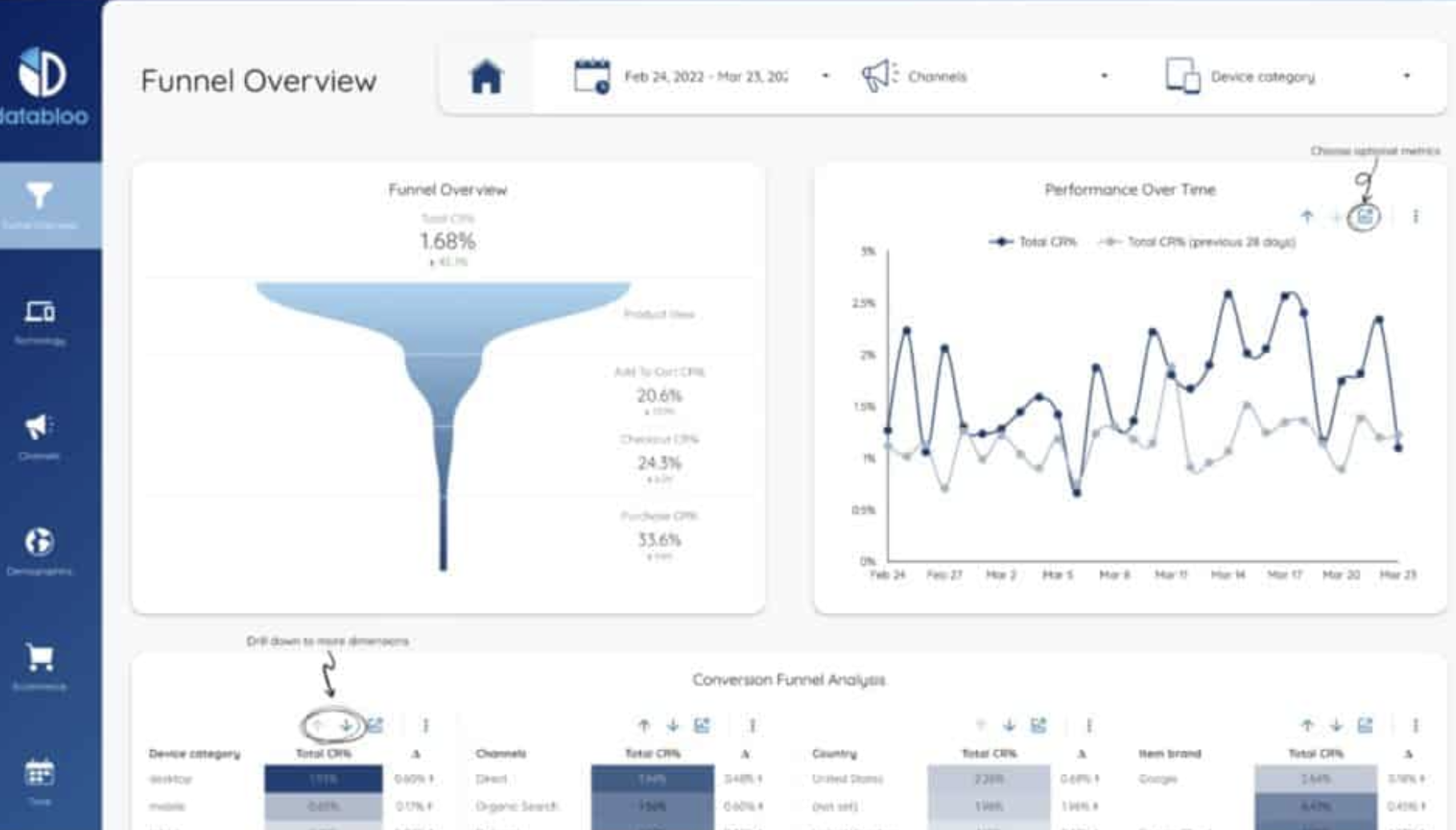

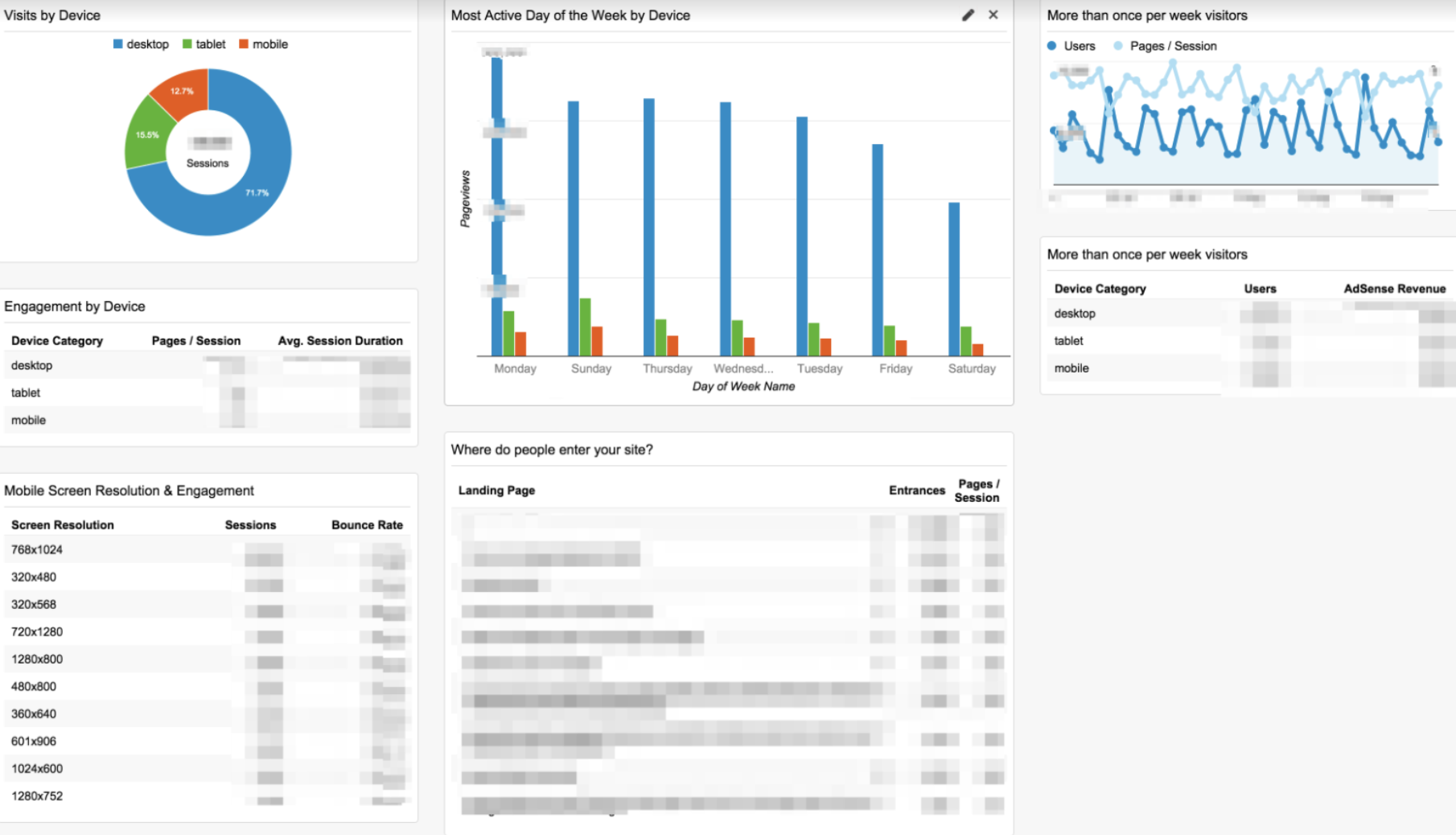

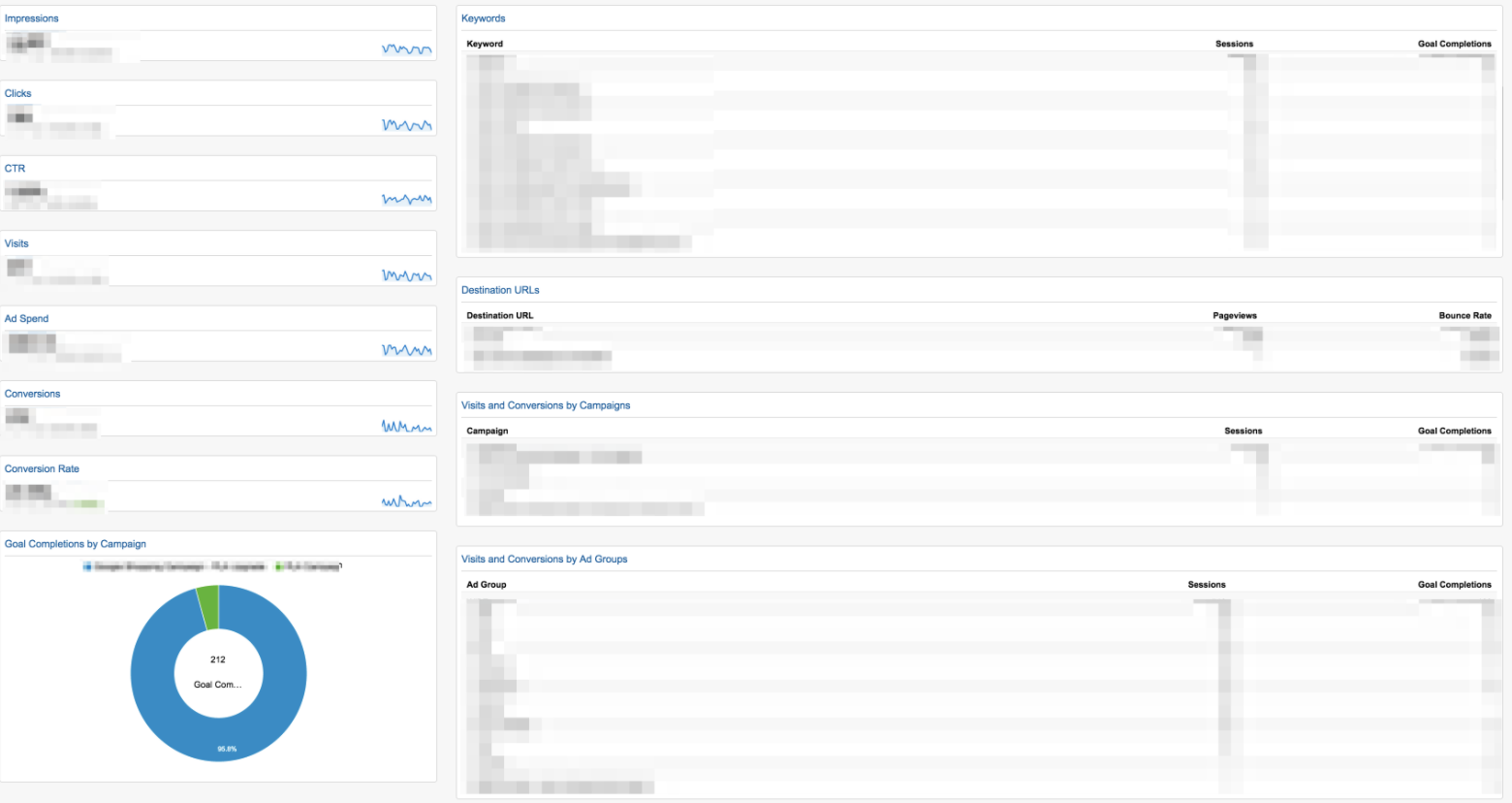

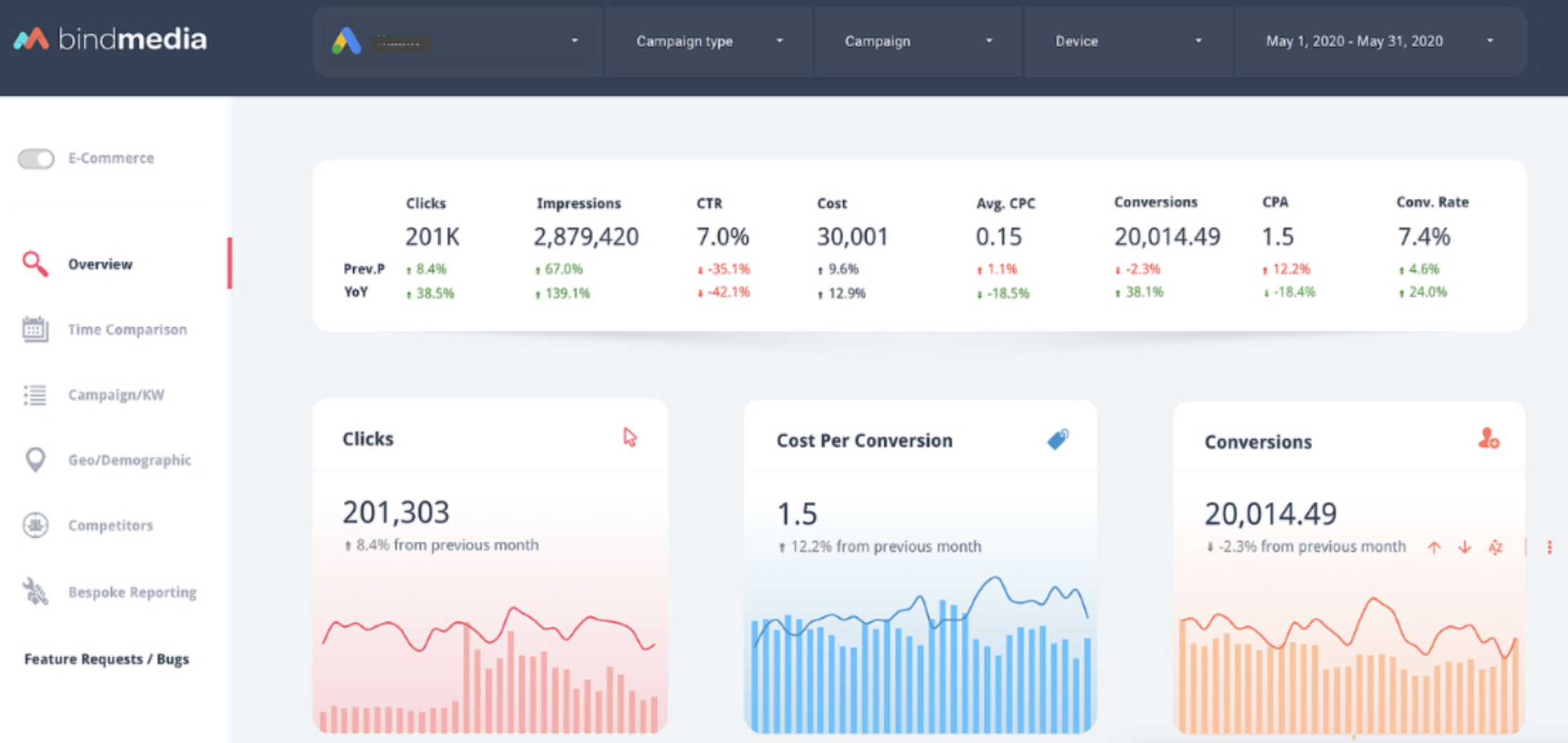

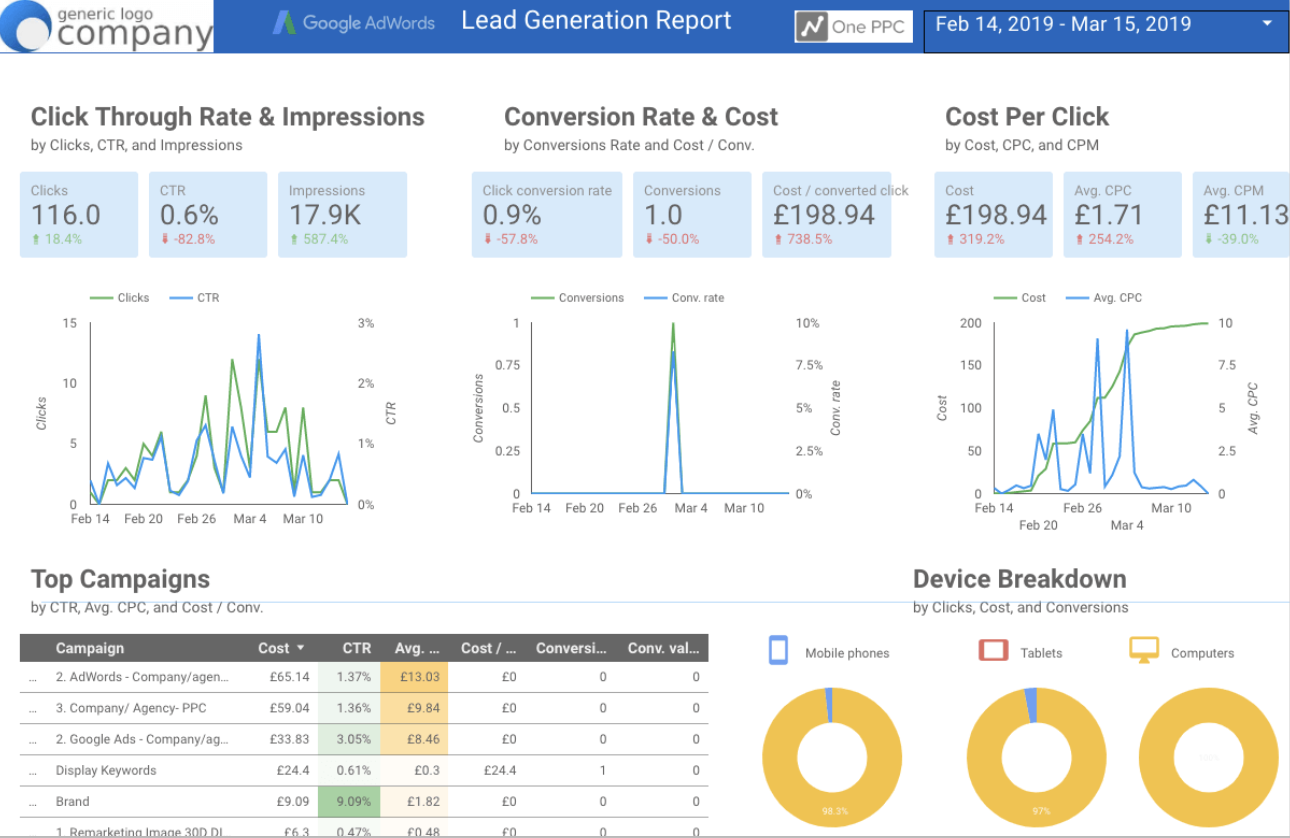

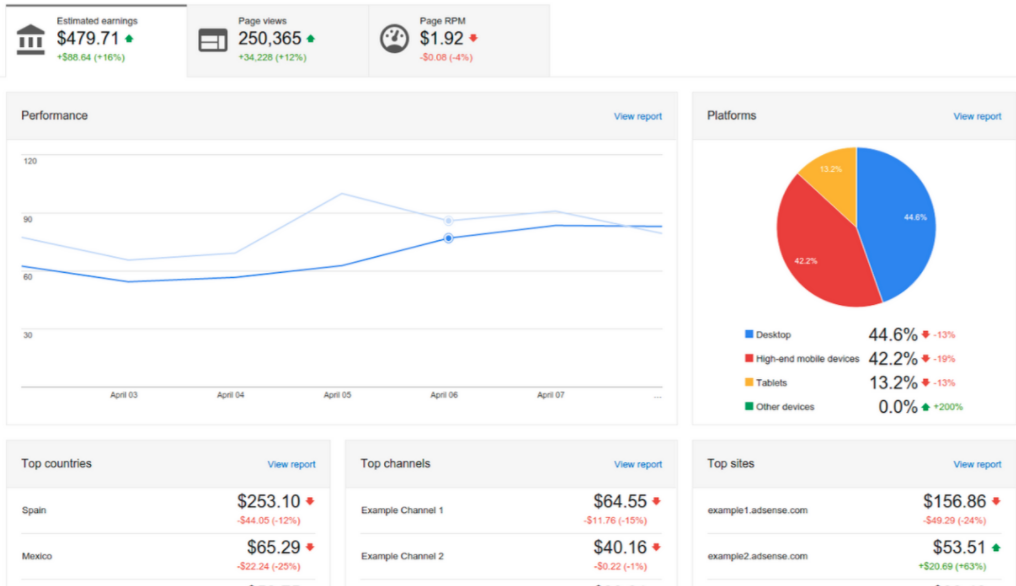

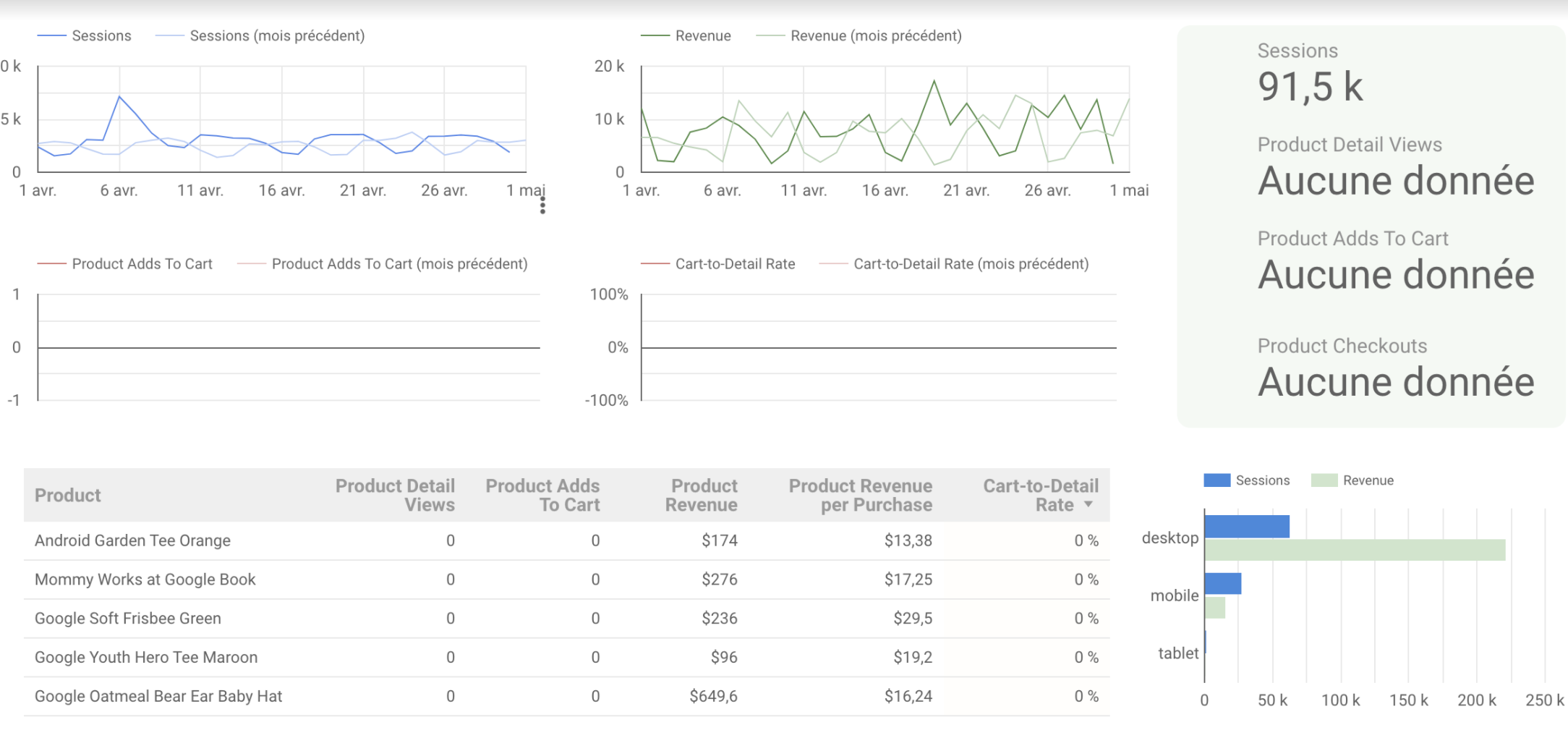

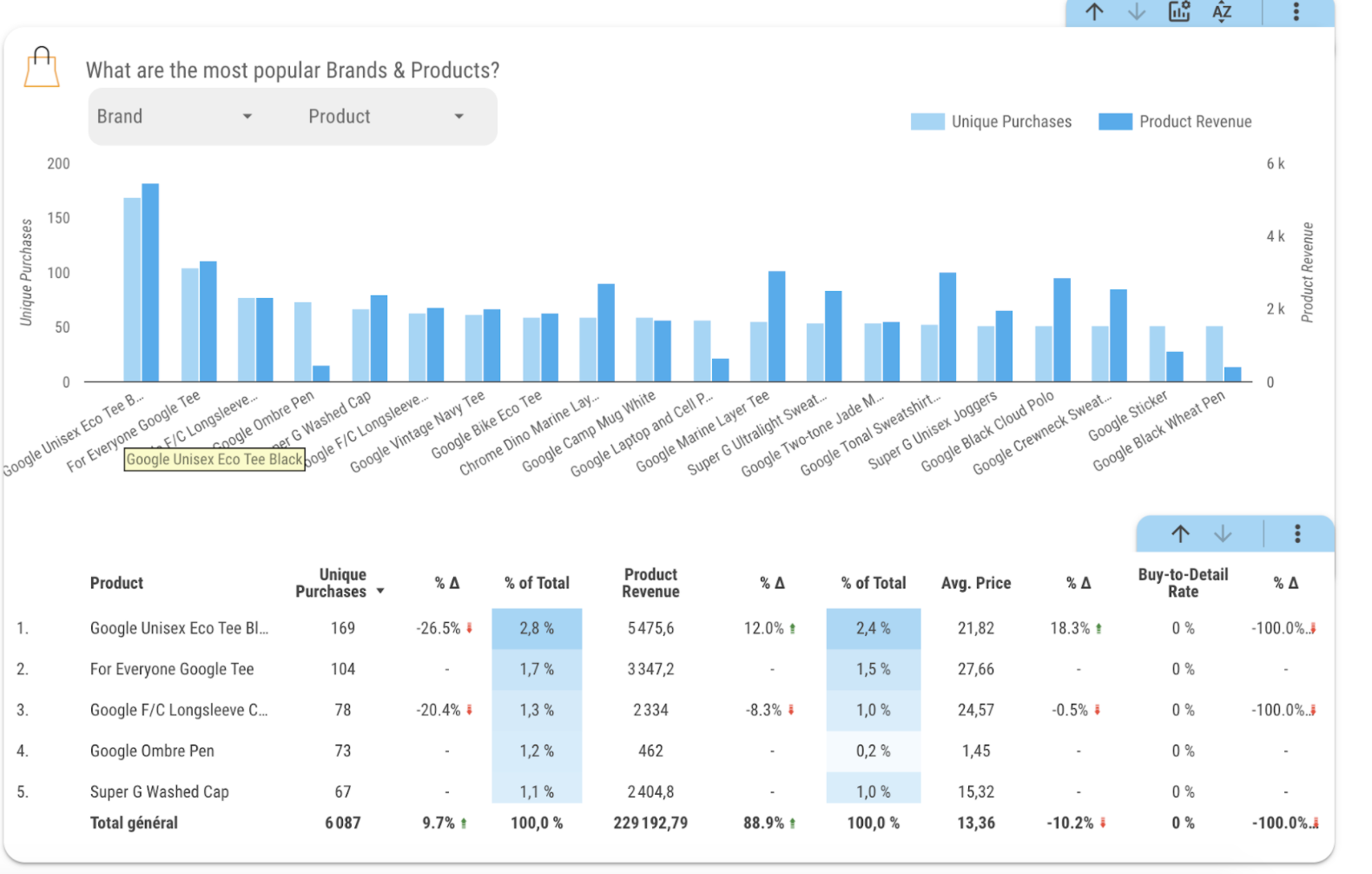

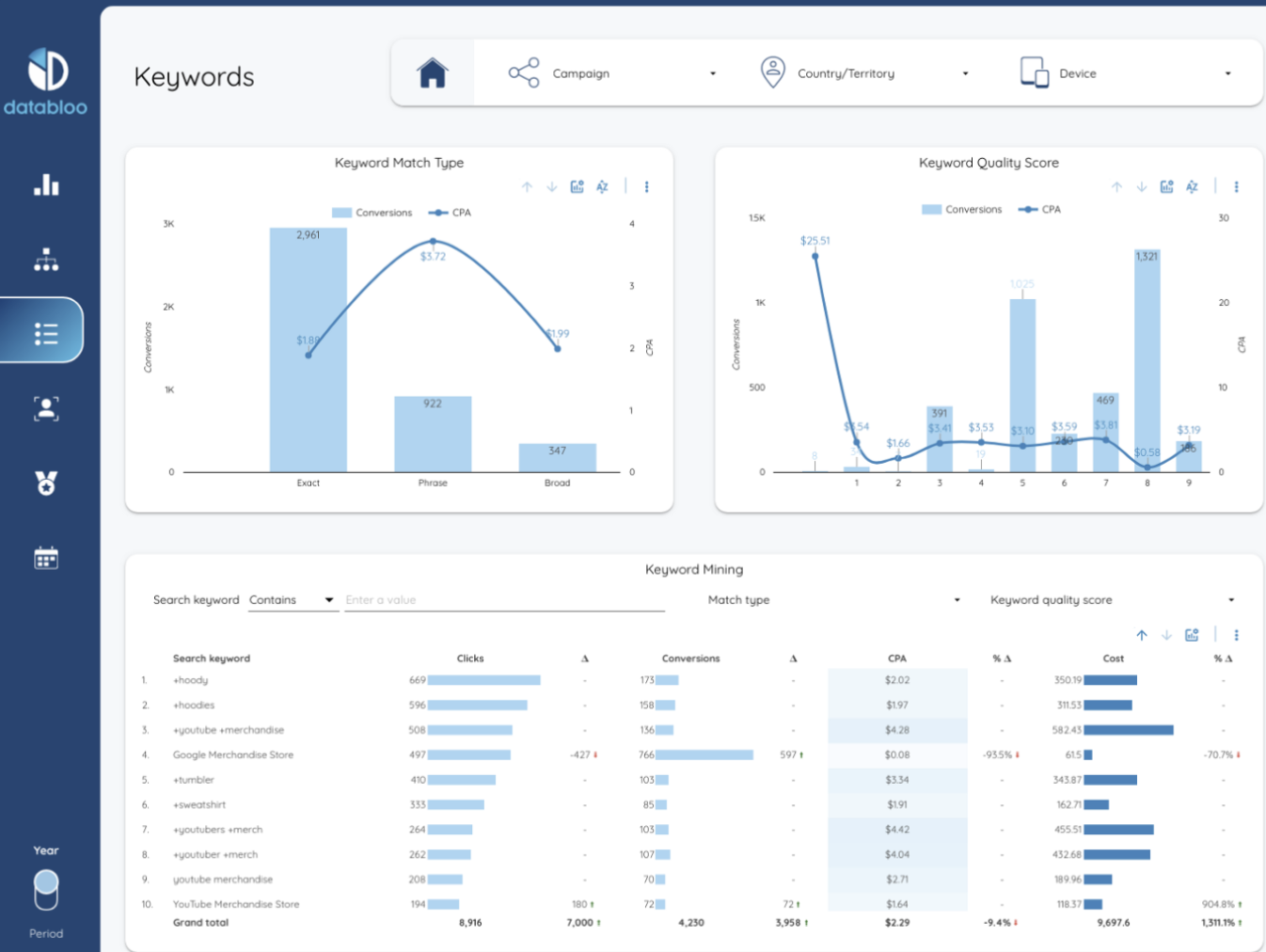

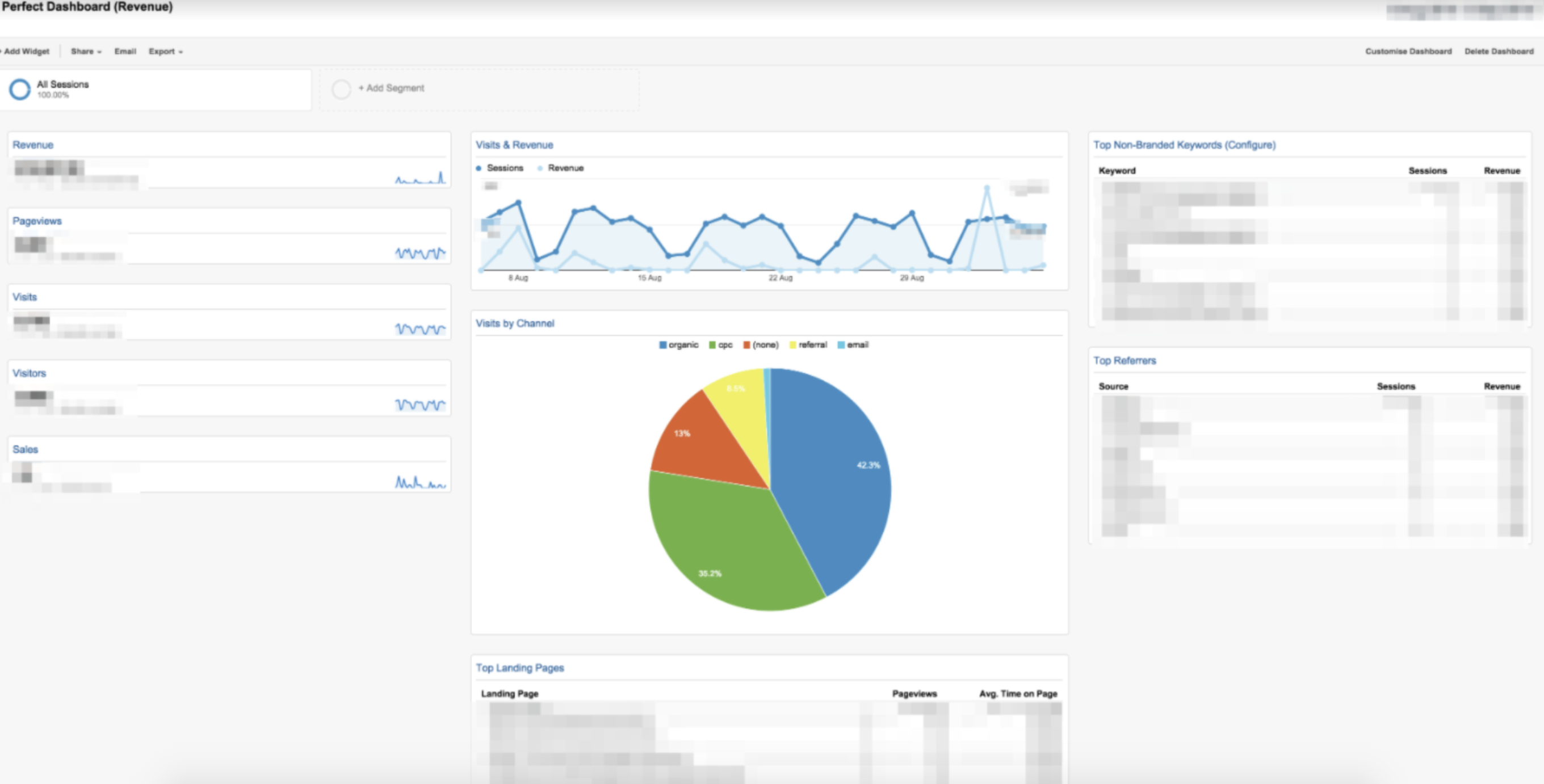

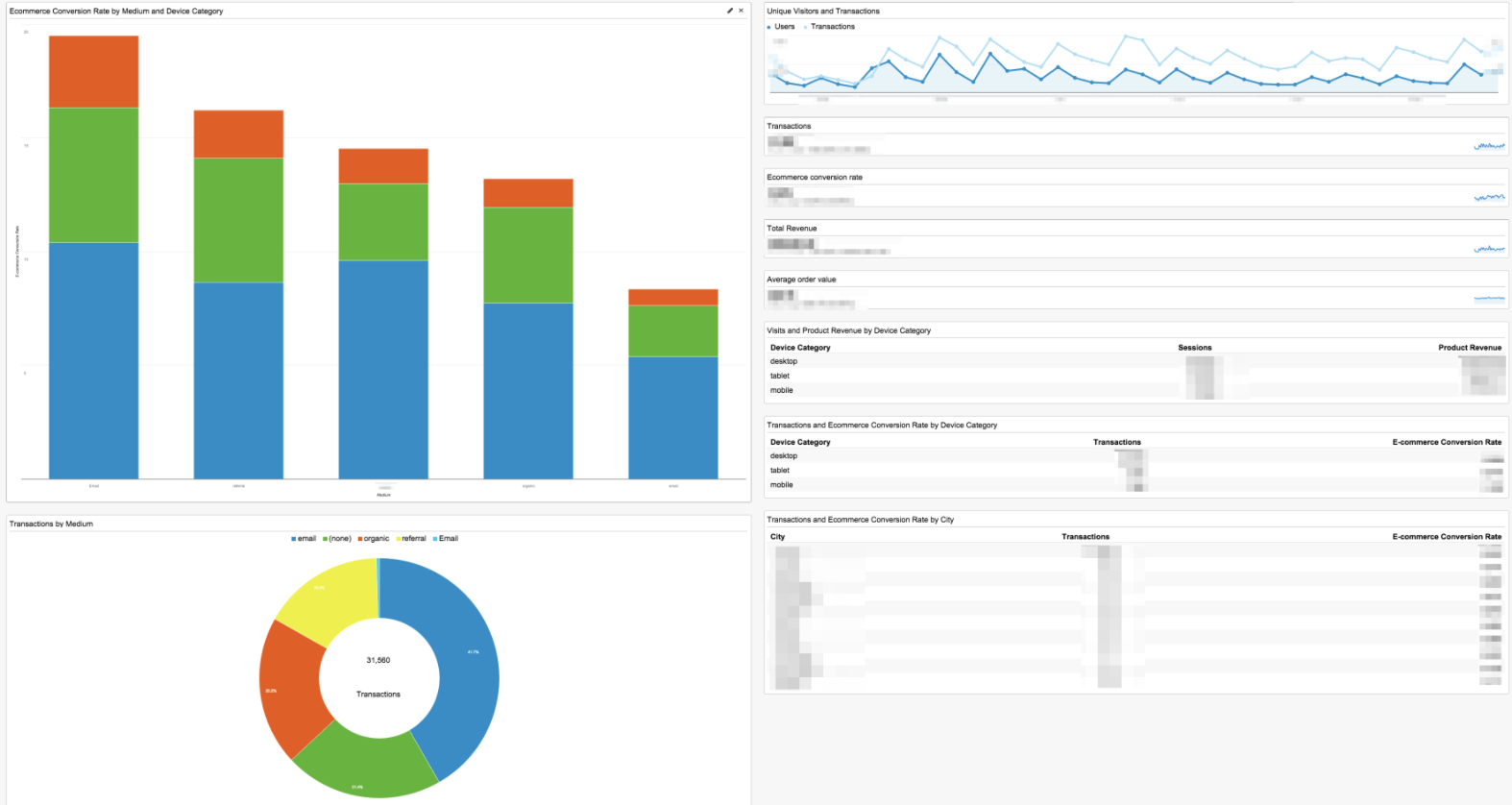

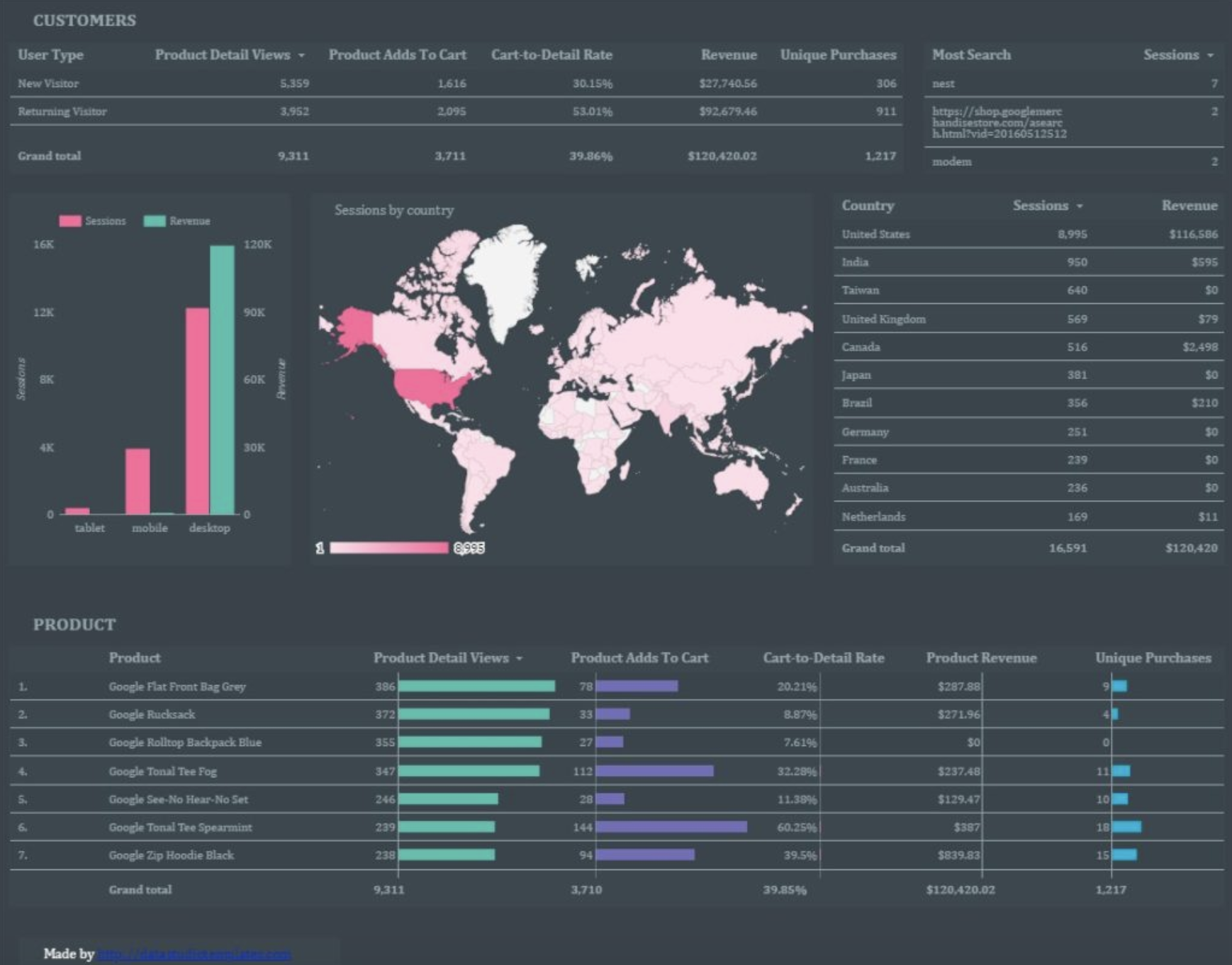

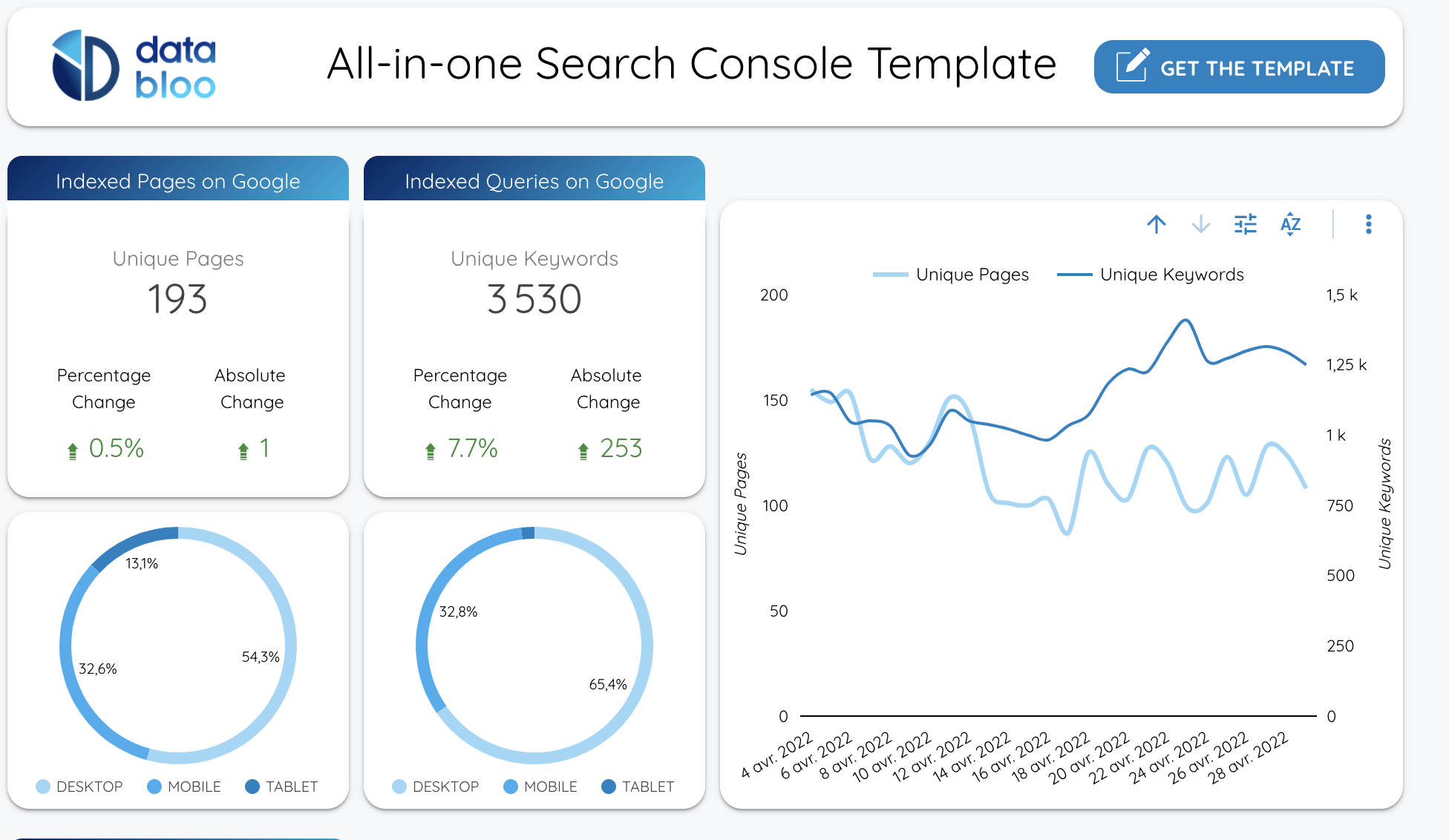

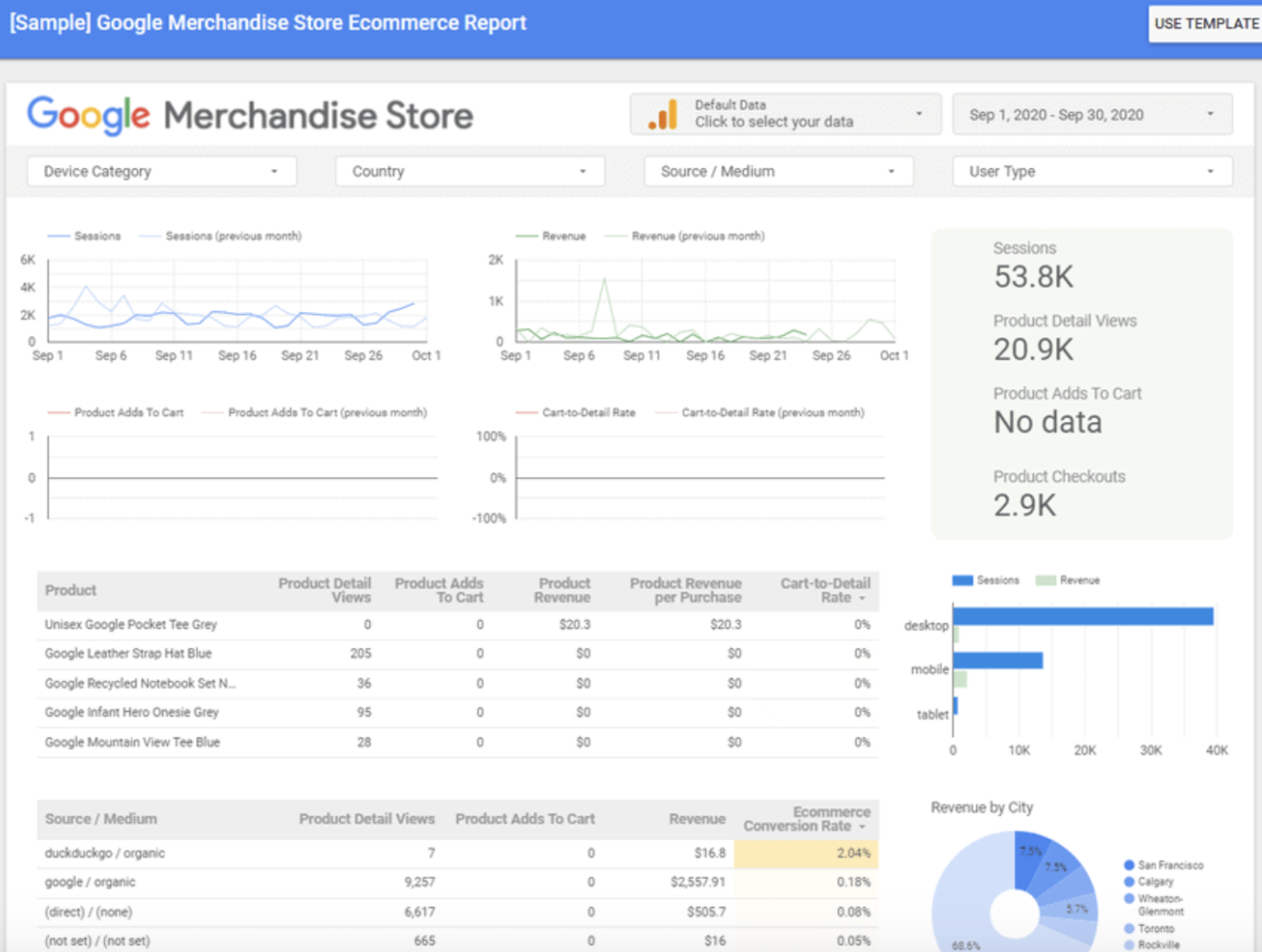

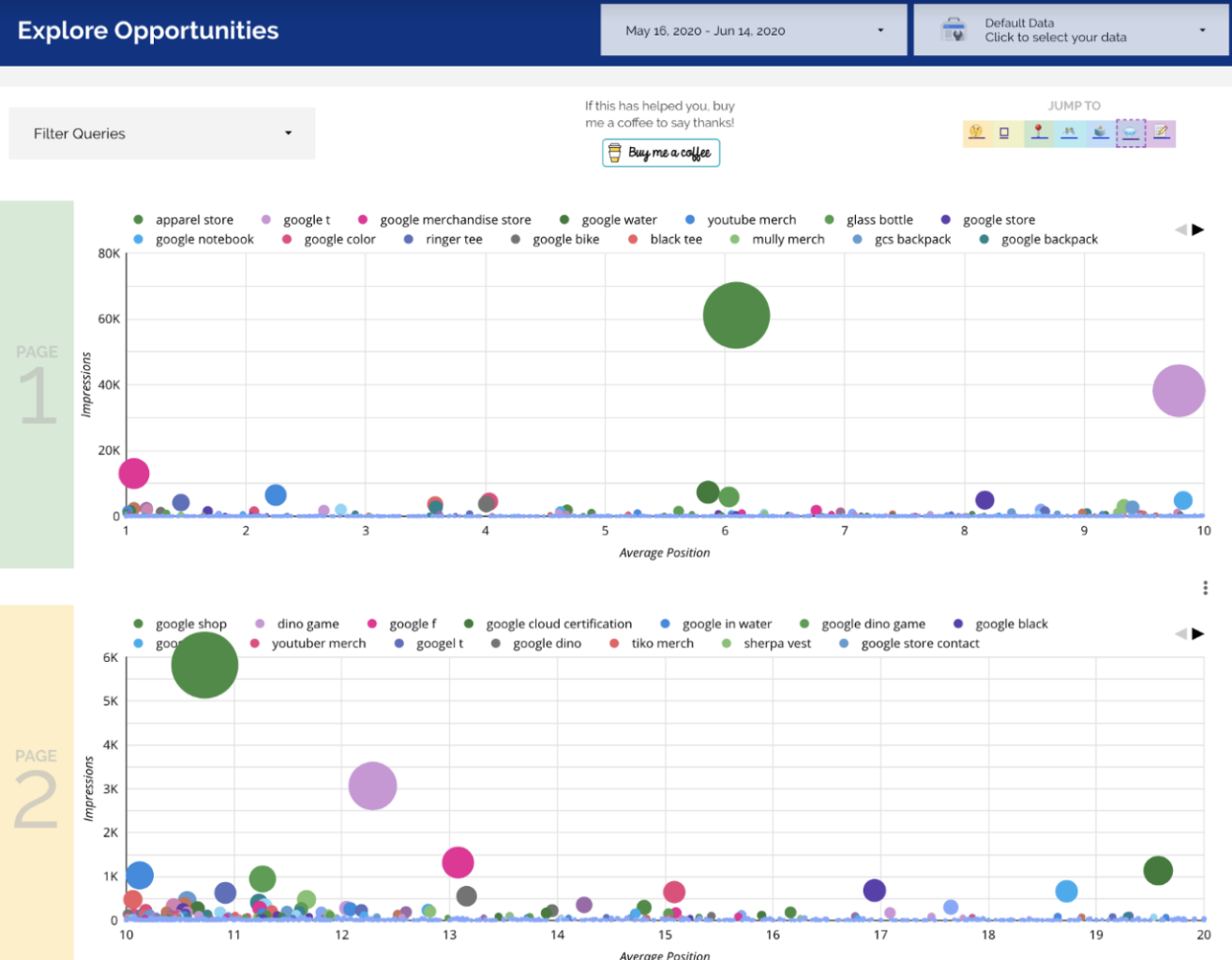

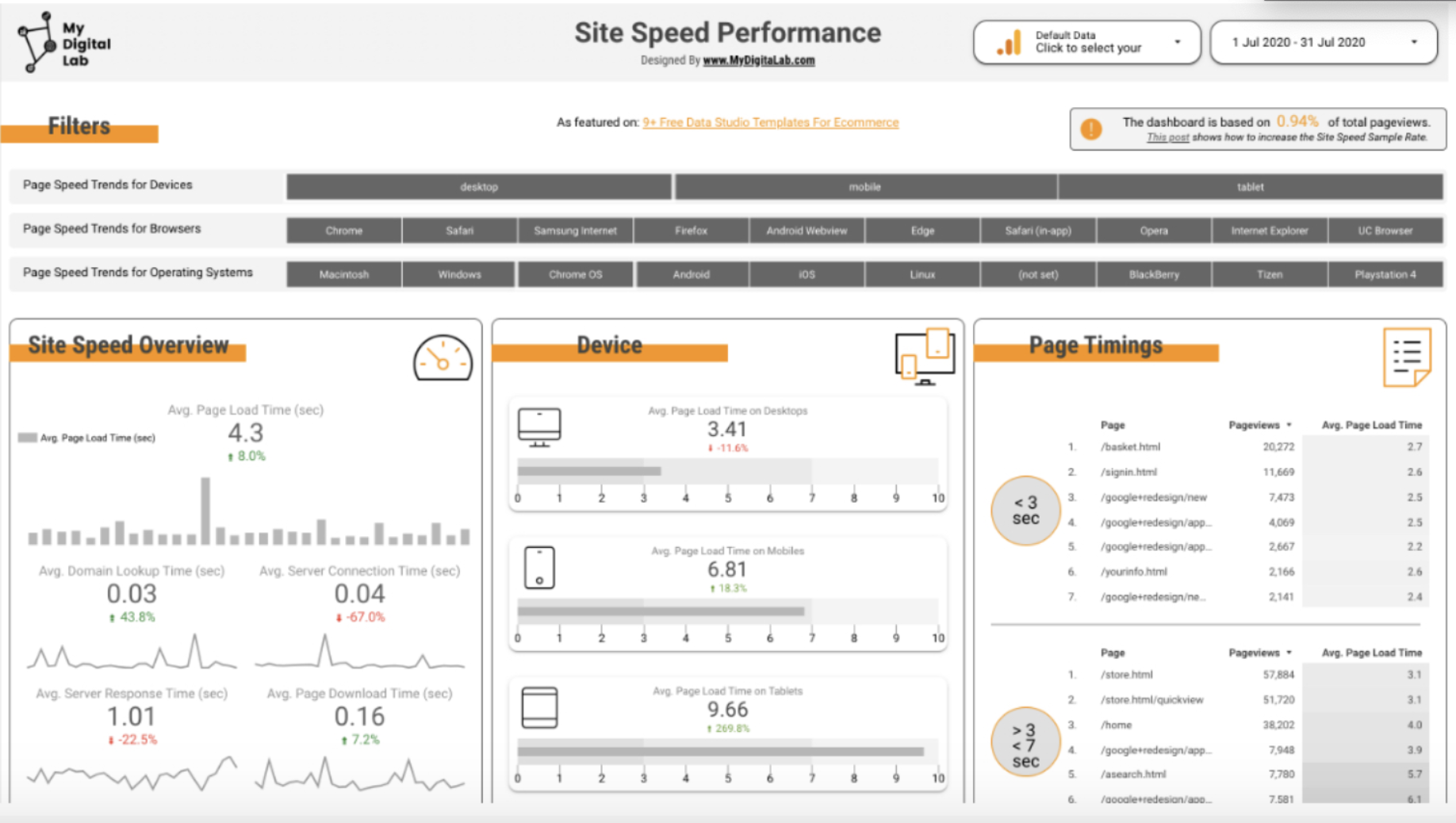

Utiliser des outils de visualisation

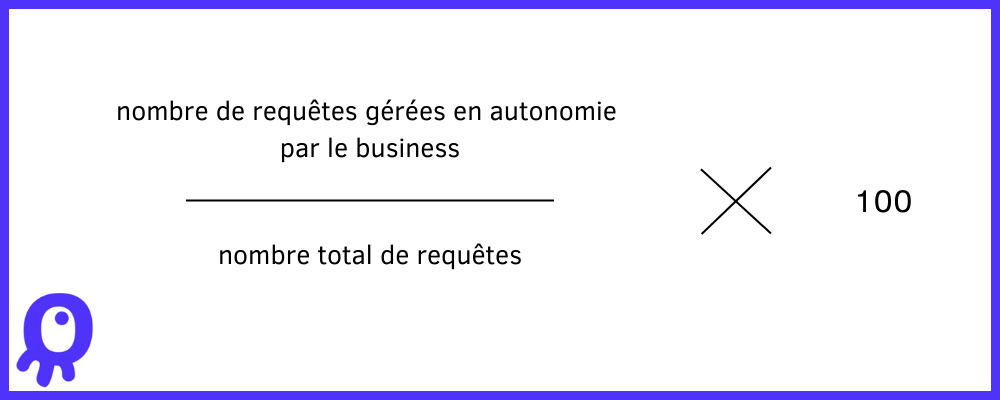

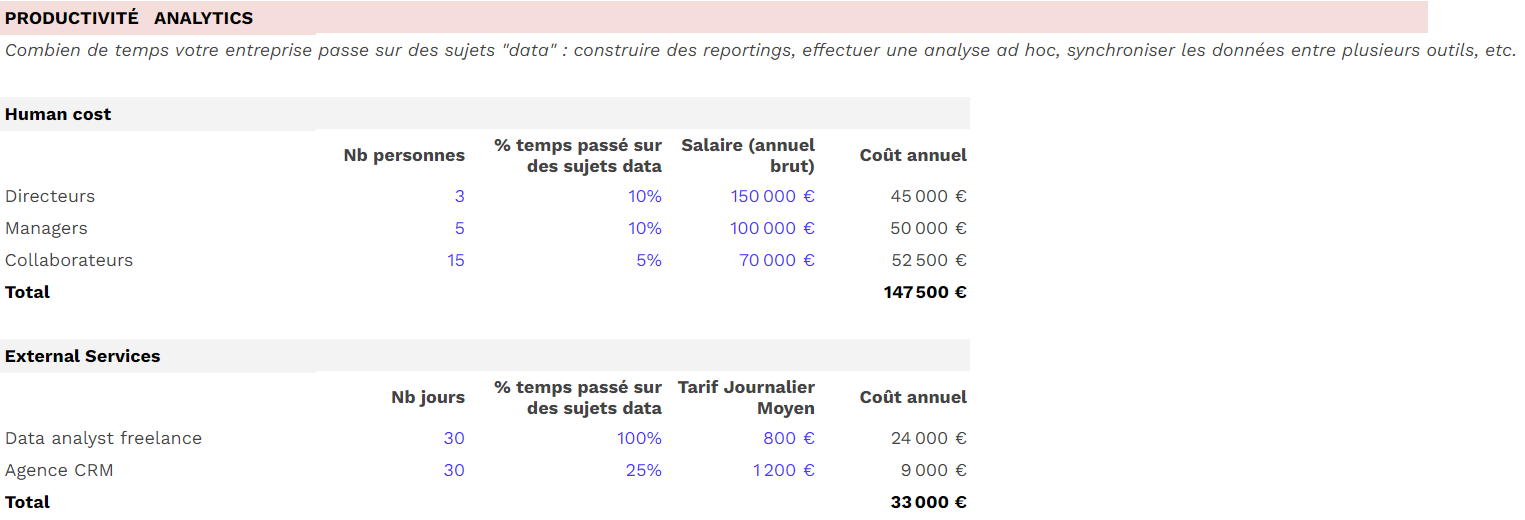

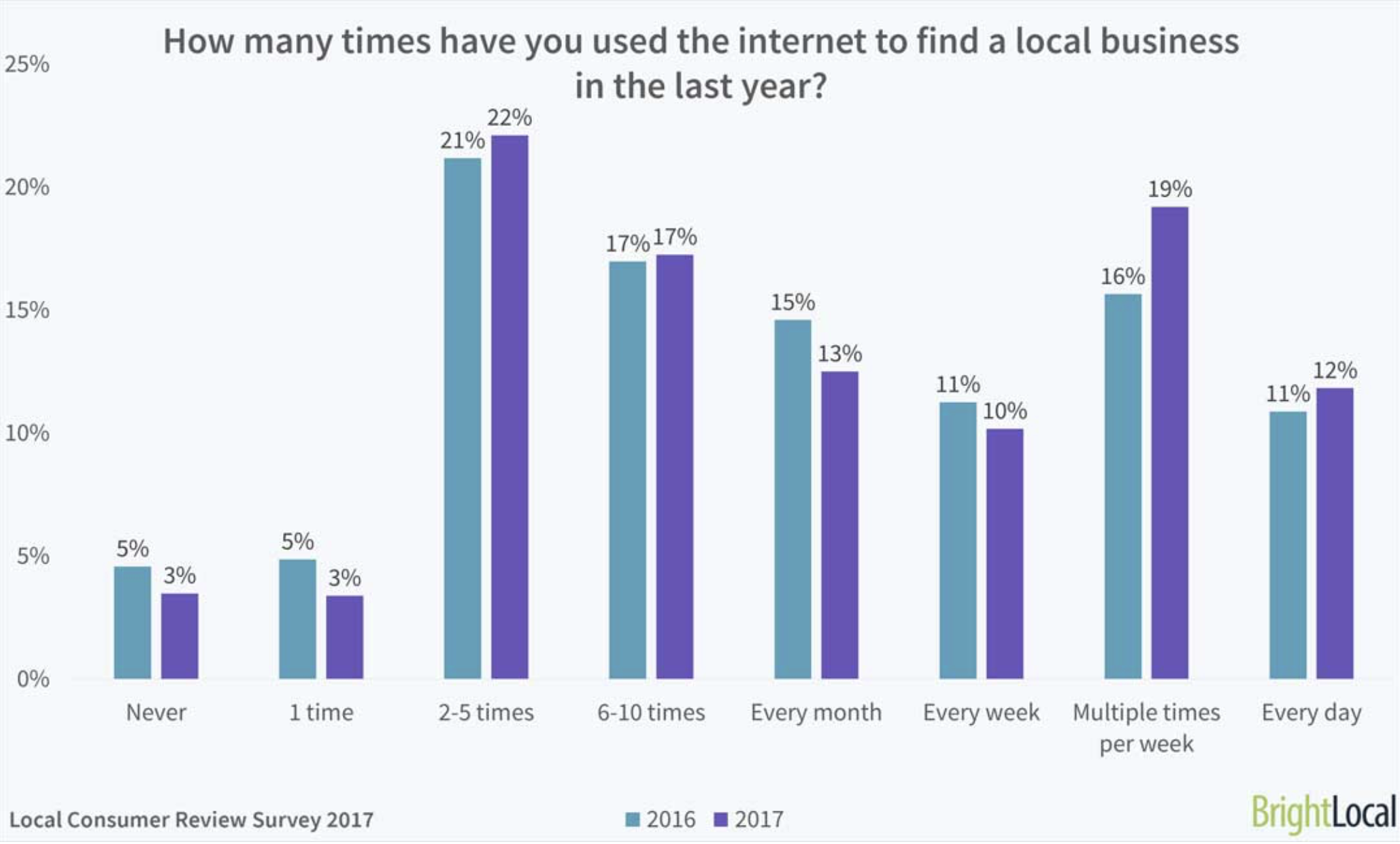

Les outils de visualisation tels que les graphiques, les tableaux et les tableaux de bord, couramment utilisés dans les logiciels de Business Intelligence, sont essentiels pour comprendre les données et prendre des décisions éclairées. Ils permettent également aux utilisateurs métier d’accéder aux analyses très facilement, sans pour autant dépendre des équipes data pour générer des rapports et exécuter des requêtes.

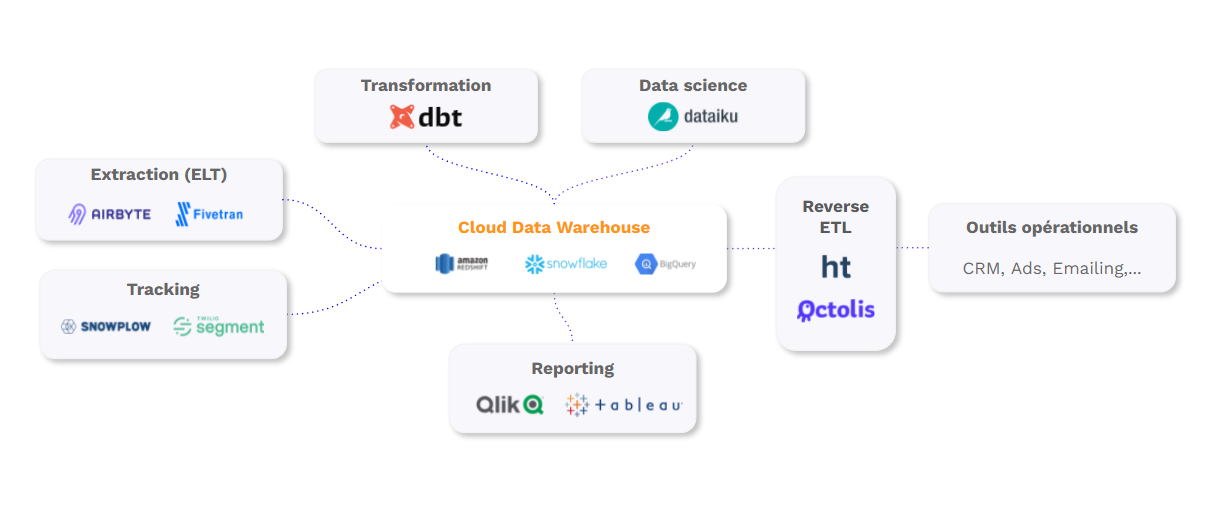

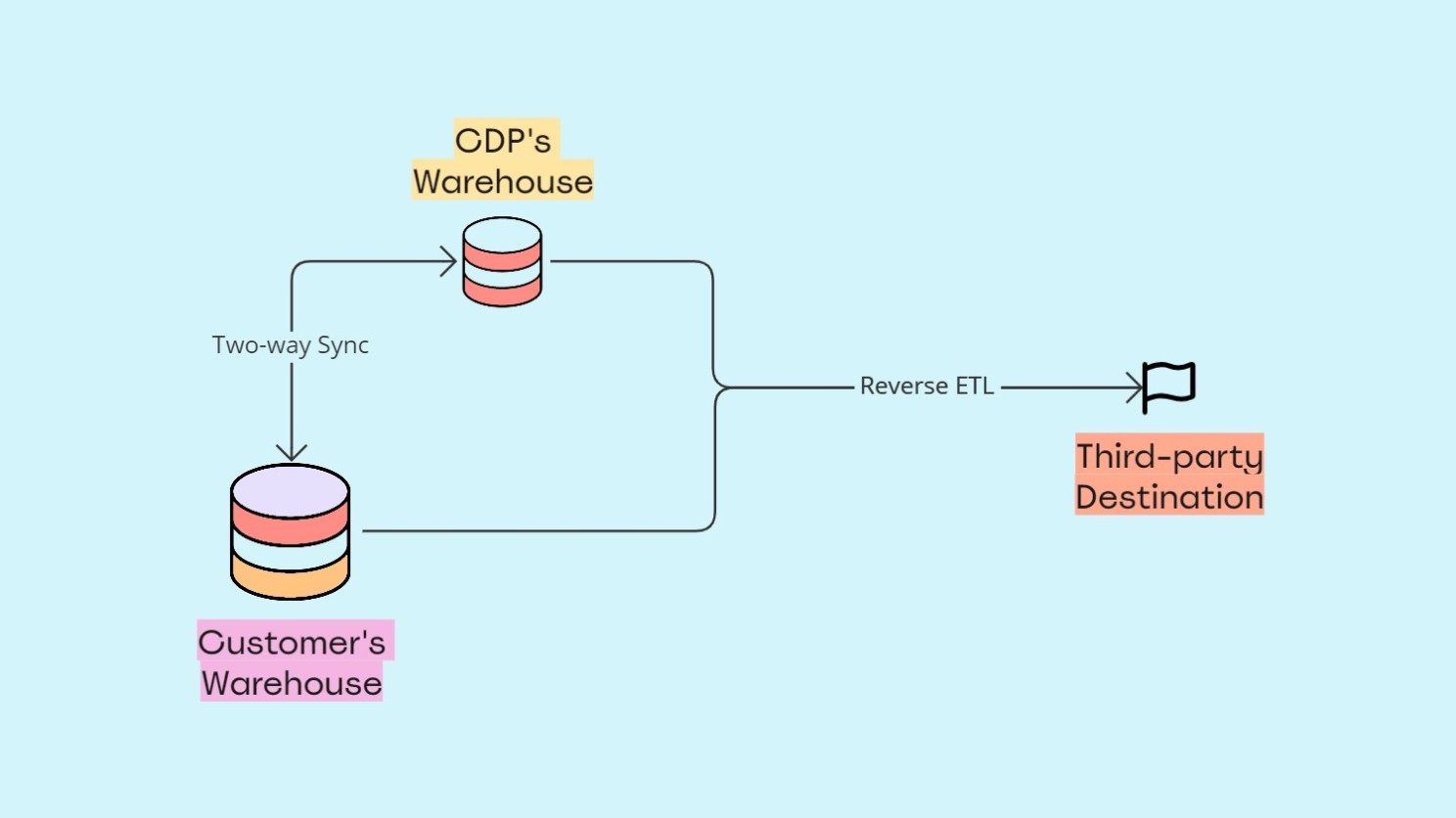

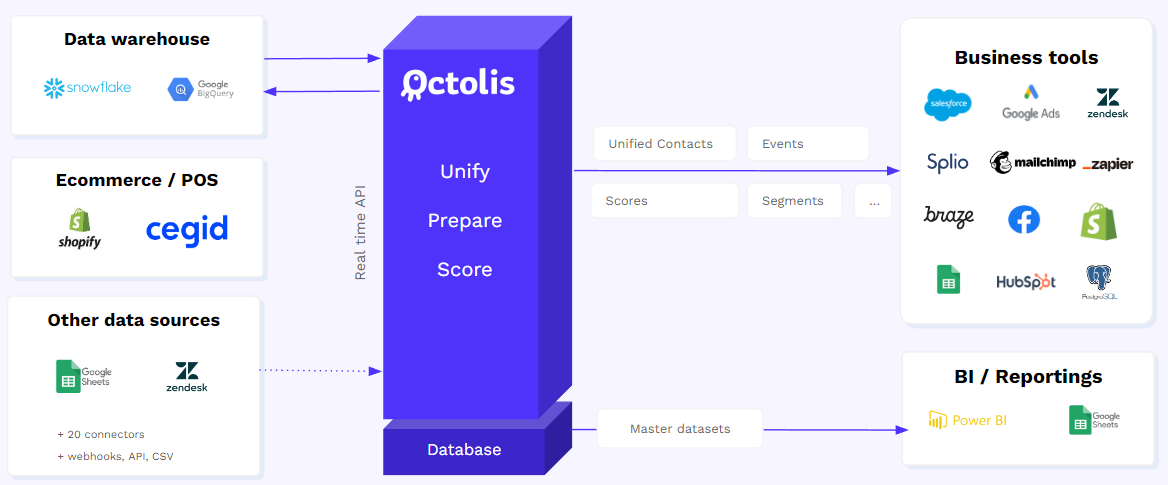

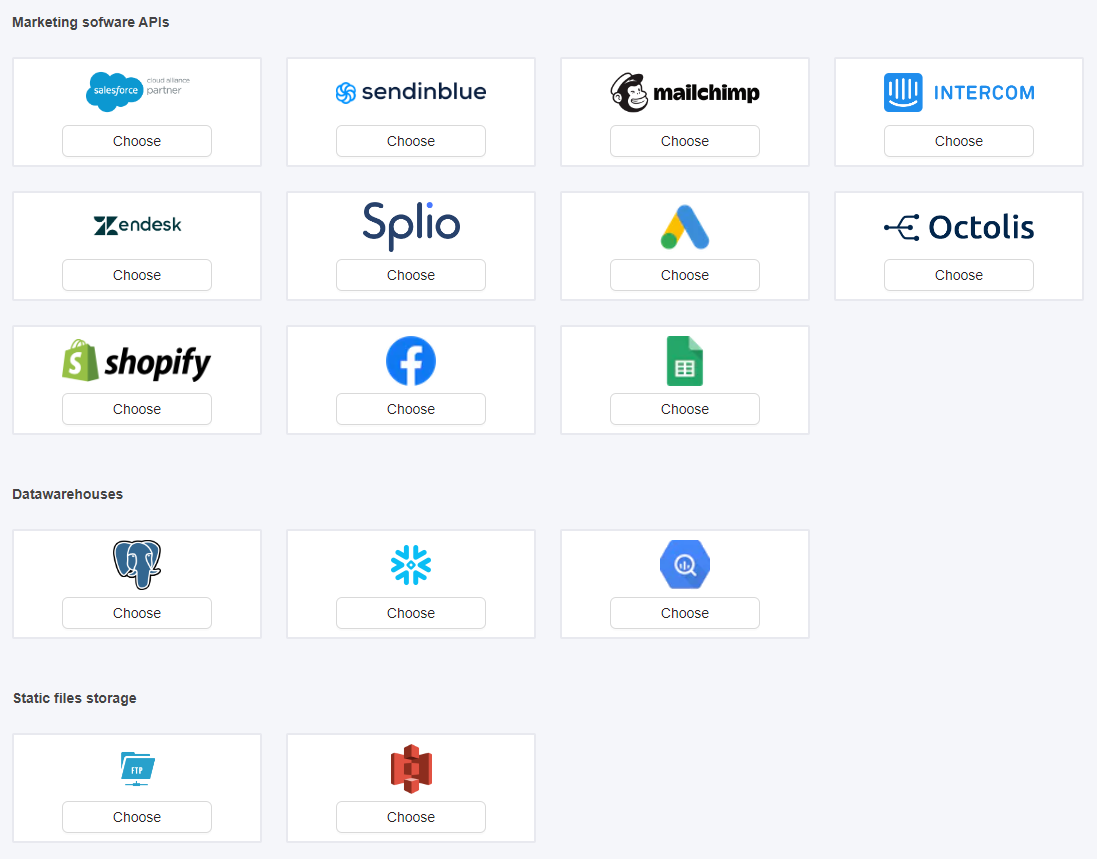

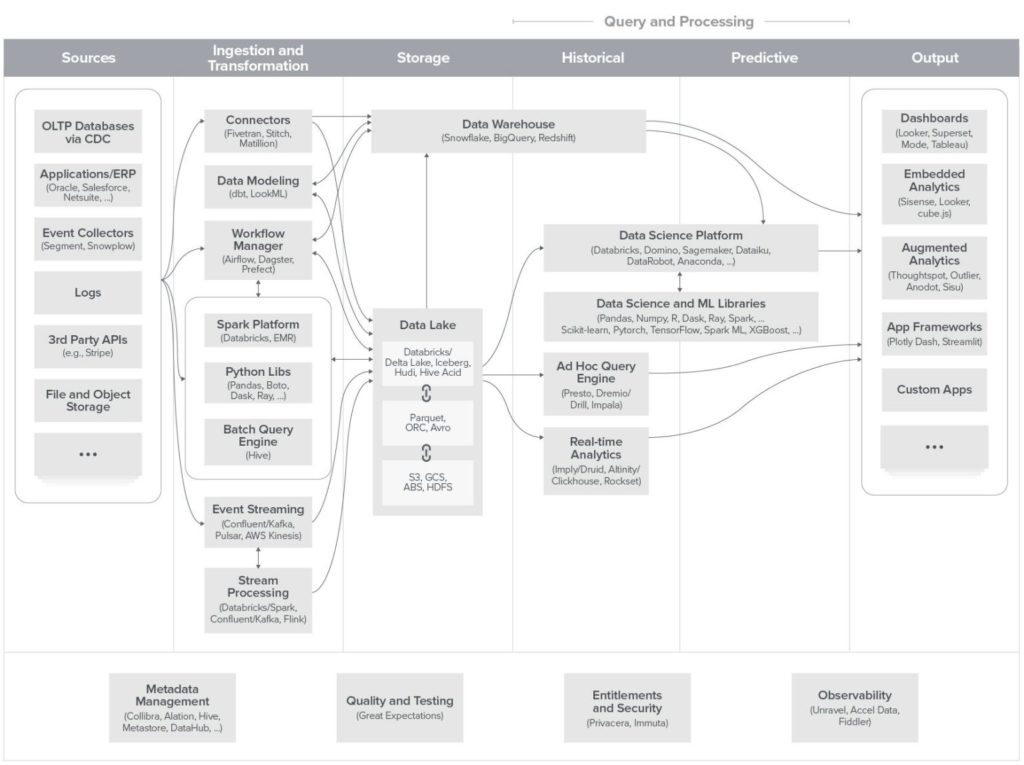

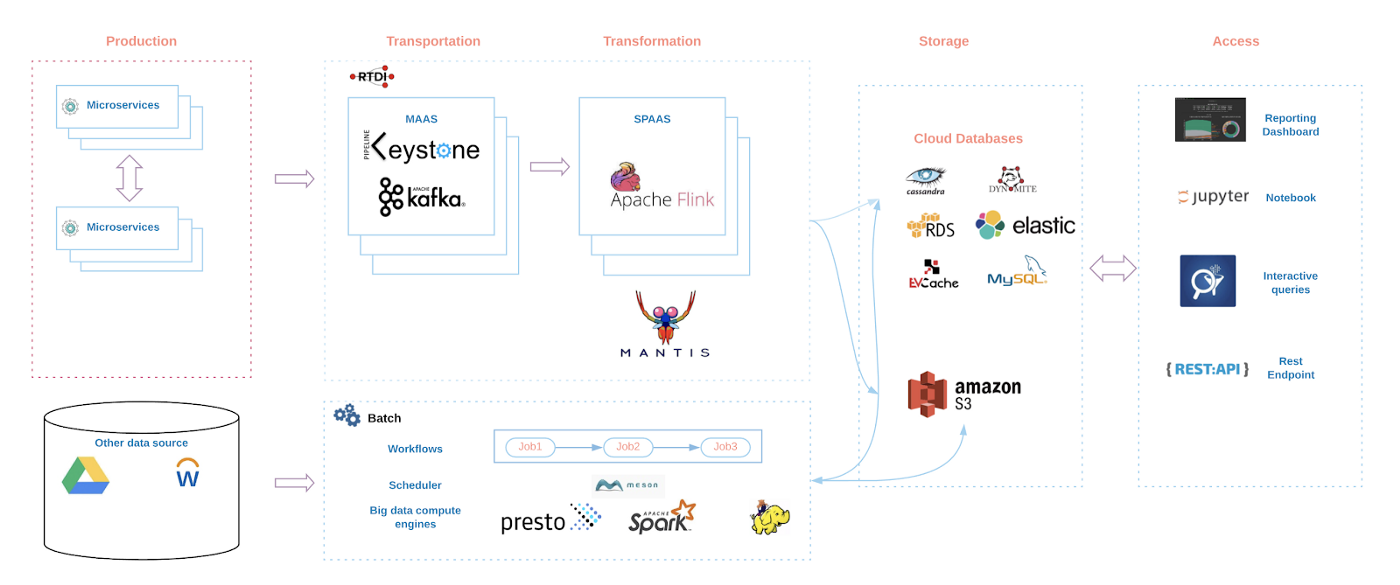

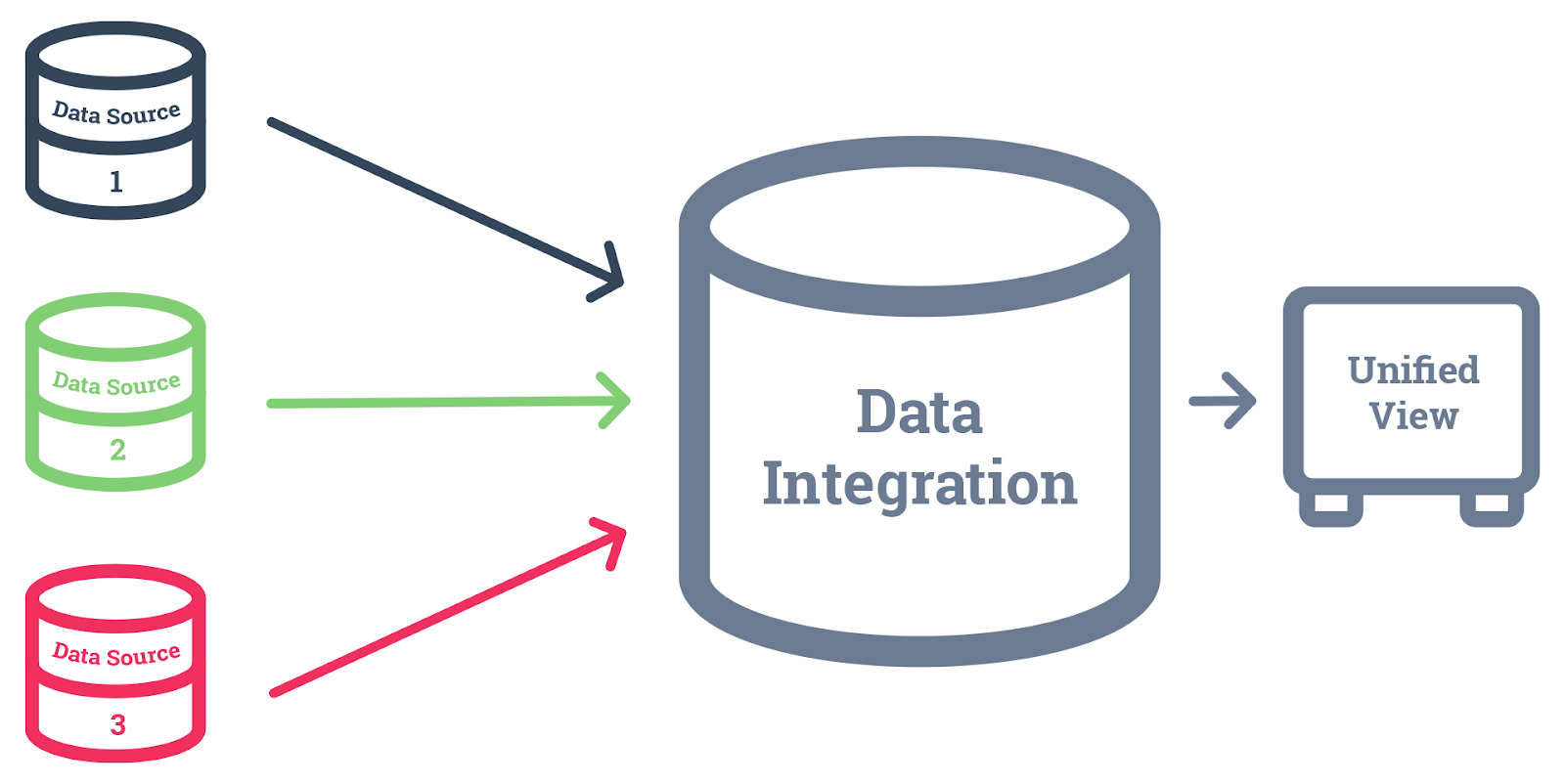

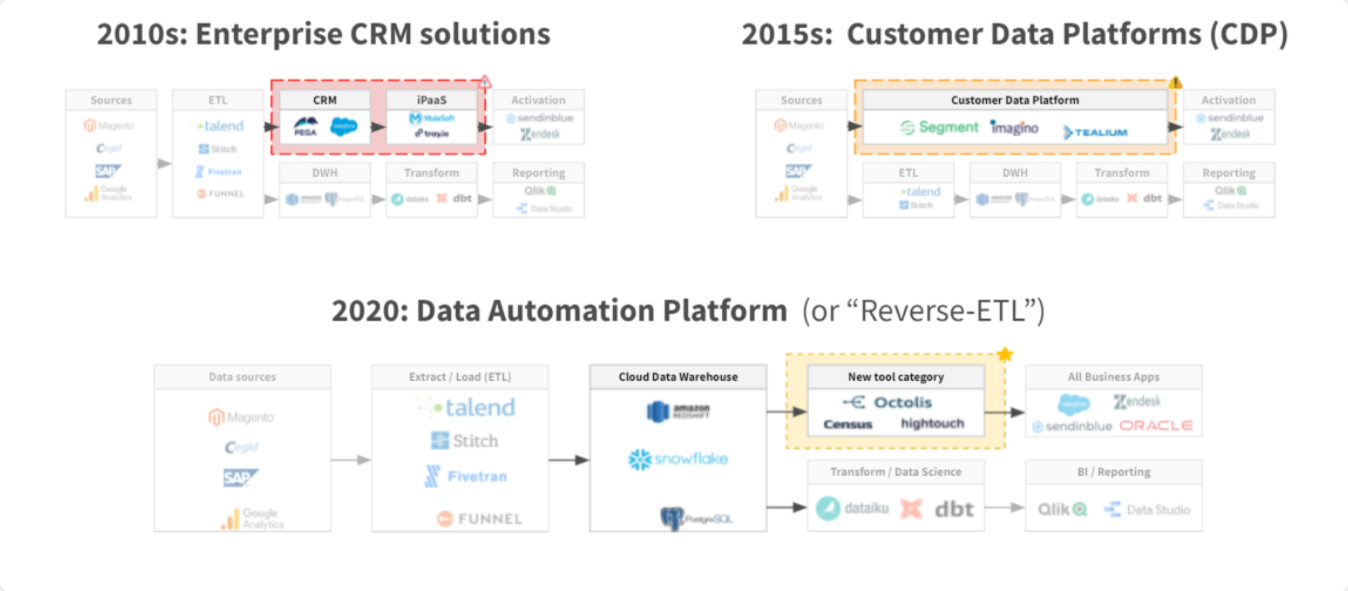

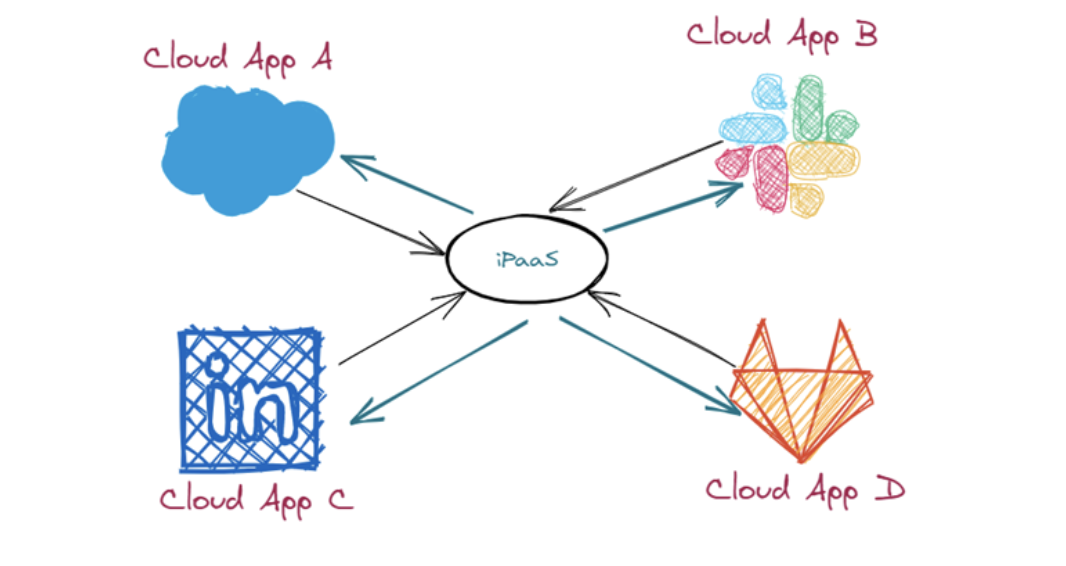

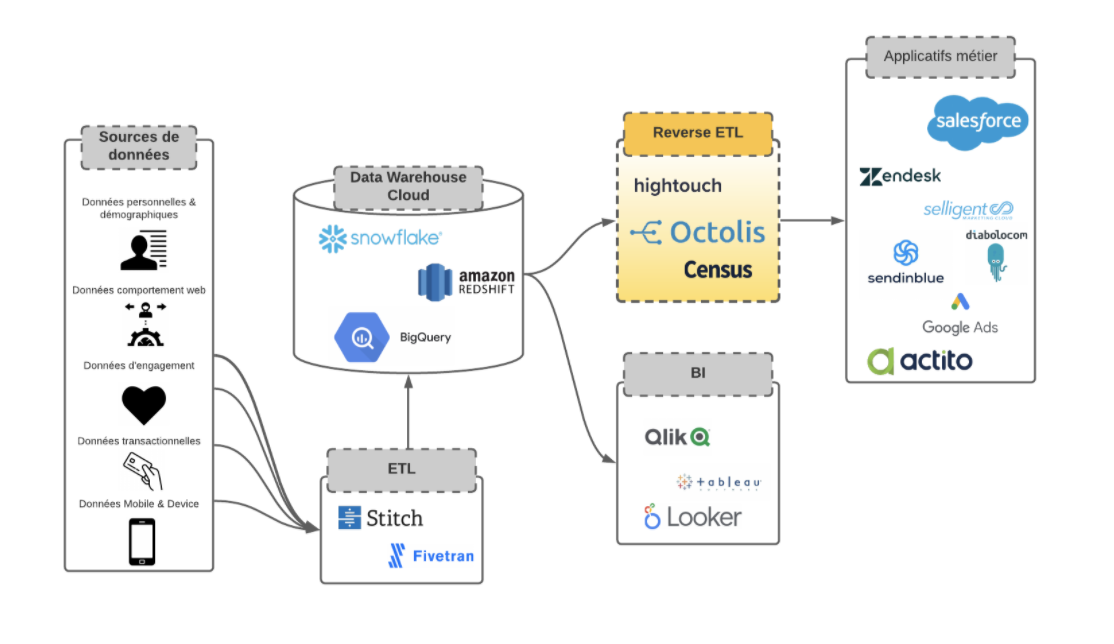

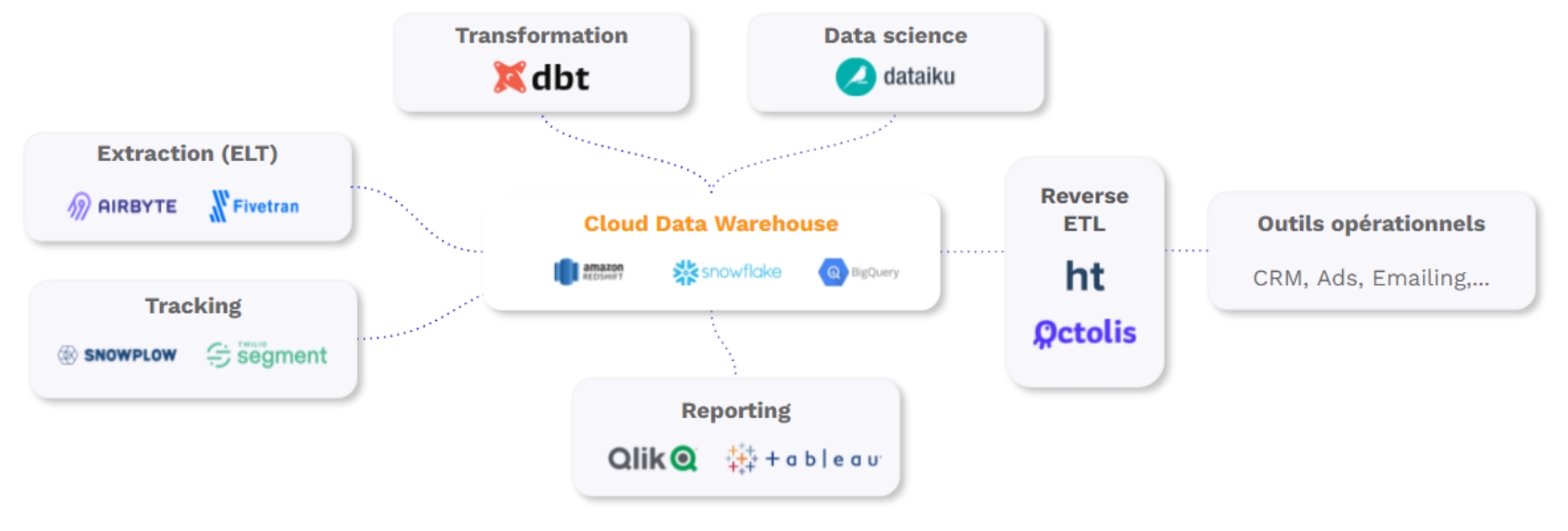

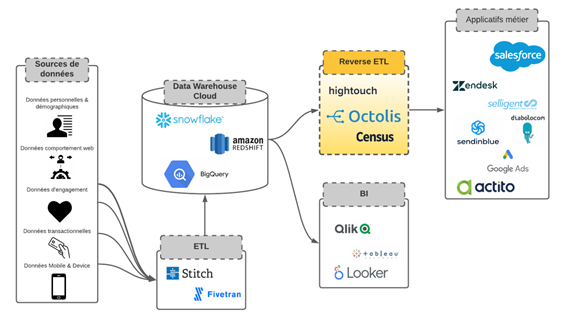

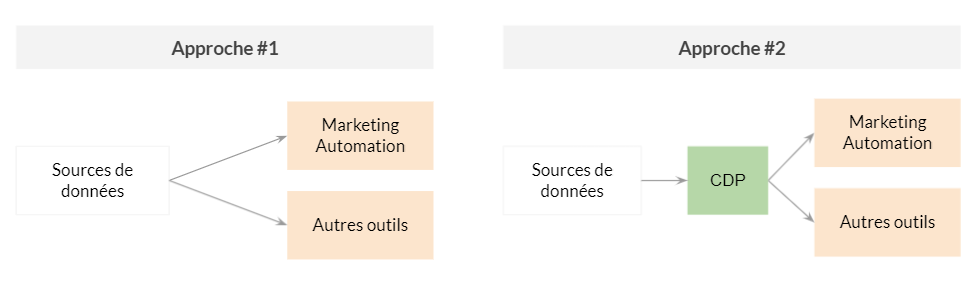

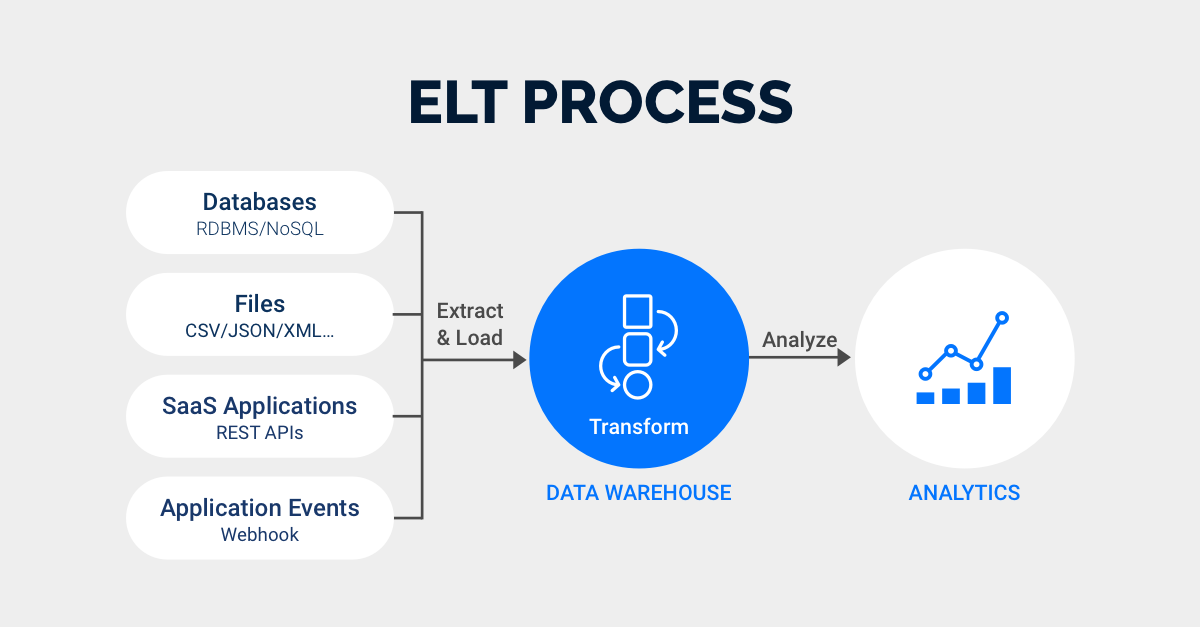

Analyser plusieurs sources de données

L’analyse de plusieurs sources de données peut aider les détaillants à obtenir une vue plus holistique de leur activité, d’autant plus que les mesures sont souvent interdépendantes. Une telle approche permet d’avoir une vision plus globale des opérations, et de prendre d’agir sur différents facteurs en même temps.

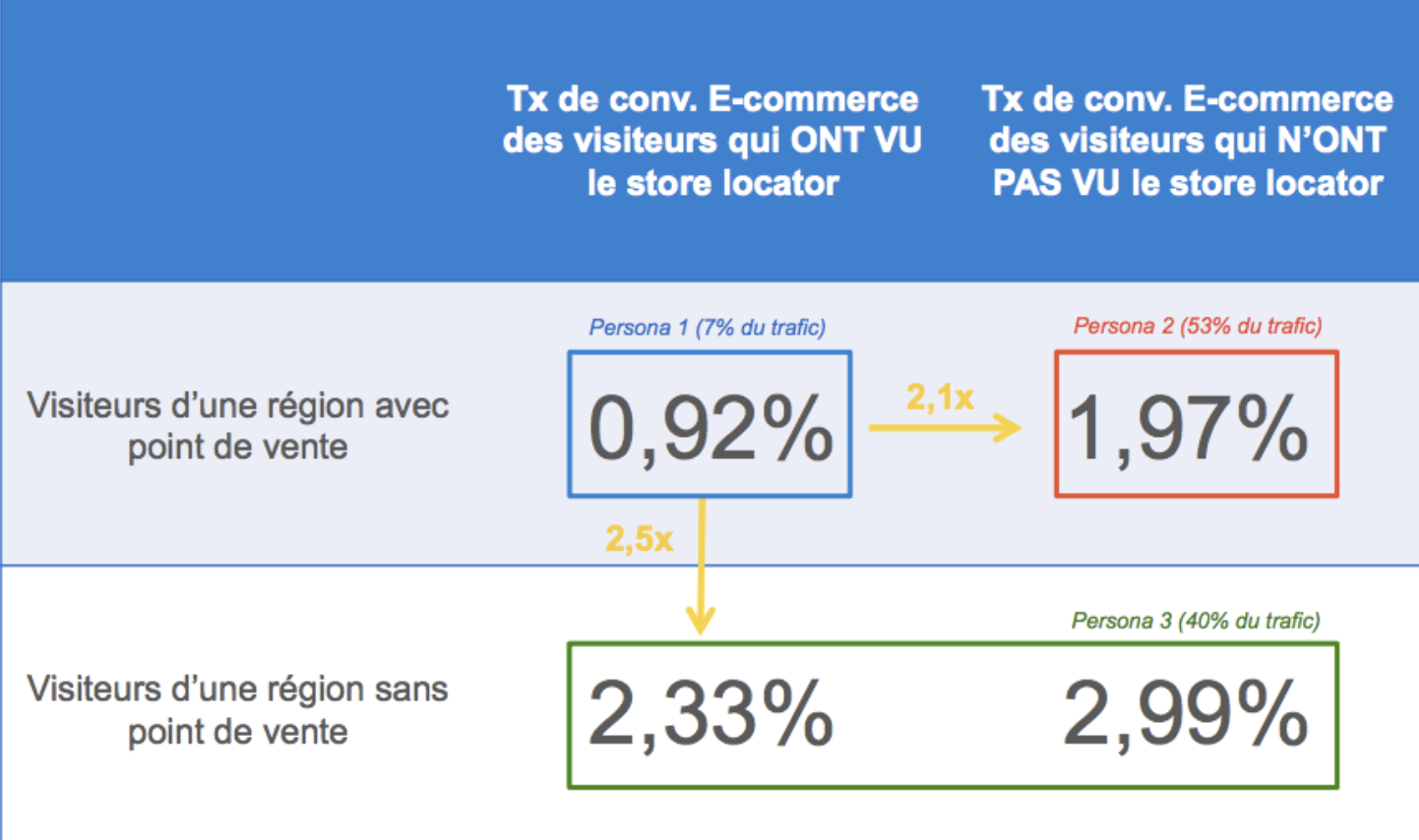

Par exemple, les détaillants peuvent corréler les analyses en magasin avec les analyses des attributs des produits pour déterminer comment optimiser l’aménagement d’un magasin physique afin de transformer les visiteurs en clients payants. L’analyse des stocks peut aider à s’assurer que le retailer dispose d’un stock suffisant pour soutenir l’aménagement du magasin.

Les détaillants doivent également être attentifs au fait que différentes applications peuvent avoir des définitions différentes des types de données, ce qui pourrait conduire à des analyses incorrectes si elles ne sont pas corrigées. C’est un argument en faveur de l’utilisation d’une plateforme unique pour l’analyse de données de vente au détail plutôt que d’adopter des applications dites « best-of-breed ».

Suivre les indicateurs clés de performance (KPI)

Le suivi des indicateurs clés de performance aide les détaillants à mesurer leurs performances et à identifier les domaines d’amélioration. Les bons détaillants ont tendance à adopter un suivi hebdomadaire de leurs KPIs, en comparant et en évaluant leur évolution d’une semaine à une autre, ce qui leur permet d’avoir une certaine agilité par rapport à leurs opérations et être réactifs face à leur marché et aux éventuels problèmes auxquels ils pourront faire face.

Dans leur suivi, ils ont tendance à présenter un review de ce qui s’est passé, suivi d’une analyse plus approfondie du “pourquoi” des choses.

Prioriser vos objectifs

Tout ce qui peut être mesuré, ne devrait pas obligatoirement l’être. Il est vrai que les données sont multiples, voire même infinies. Mais il est essentiel de discerner entre ce qui doit être mesuré, et ce qui ne doit pas forcément l’être. Lors de la priorisation de vos objectifs, l’idéal c’est d’adopter une approche “less is more”. Plus vous êtes concis dans le choix de vos objectifs, moins vous risquez d’accabler les décideurs avec des recommandations excessives. En tant que retailer, vous devez commencer par identifier les opportunités à haute priorité qui peuvent avoir un impact immédiat sur votre activité.

Pour conclure, les cinq bonnes pratiques qu’on partage avec vous sont interreliées. On vous recommande donc de les suivre toutes, en respectant cet ordre:

Commencez par un objectif, puis choisissez deux ou trois objectifs sous-jacents. Les KPIs qui mesureraient votre progrès à ce niveau sont des KPIs “précurseurs”.

Par exemple: Objectif principal: Vous rapprocher de vos clients. Vous pourrez choisir comme KPIs sous-jacents :

- KPI #1 : Augmenter la CLV (ou Customer Lifetime Value) de 20%.

- KPI #2 : Atteindre un taux de conversion de 15% (year-to-year).

- KPI #3 : Optimiser les niveaux de stock pour soutenir les objectifs clients.

Les outils de visualisation vous permettront de présenter votre progrès aux dirigeants de votre entreprise et d’initier des actions correctives, sans pour autant les bombarder d’informations excessives et incohérentes.

Pour aller plus loin – Les opinions d’expert métier

Afin de vous fournir un contenu de qualité, on se tourne très souvent vers les experts du métier pour qu’ils challengent nos ressources, et partagent avec nous leur expertise sur le sujet.

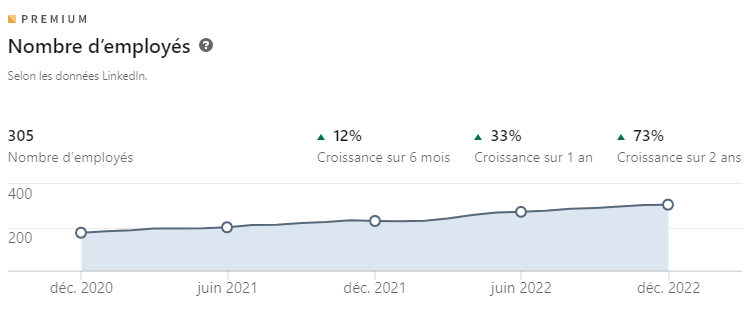

En préparant cet article, nous avons sollicité Grégoire Mialet– le Managing Partner de la boîte C-Ways, Faustine Caradeux – la Growth Marketing Manager d’Unifai, et Thomas Bertail – le Regional Marketing Manager d’Akeneo – qui nous ont tous les deux beaucoup assistés sur la sélection des meilleurs indicateurs pour votre analyse produit, et qu’on remercie beaucoup d’ailleurs pour leur aide précieuse.

Lors de nos échanges avec eux, on a soulevé beaucoup de questions sur les bonnes pratiques de l’analyse produit. Et comme petit cadeau pour nous avoir suivis jusque-là, on a décidé de partager avec vous les pro tips qu’on a récoltés :

Tip #1 : Sur quelle durée baser mon analyse ?

Il faut avoir en tête qu’une analyse produit est généralement basée sur une durée de 12 mois. Le problème, c’est que l’on veut parfois avoir un retour sur un produit qui a été lancé il y a moins de 12 mois. Par exemple, dans le cas d’un lancement d’un nouveau produit qui a été lancé il y a quelques mois. Il faut donc être vigilant sur les périodes de comparaison. Si cela ne fait que quelques mois et qu’on veut déjà réaliser une analyse, alors une solution est de comparer avec des produits similaires qui viennent de la même famille.

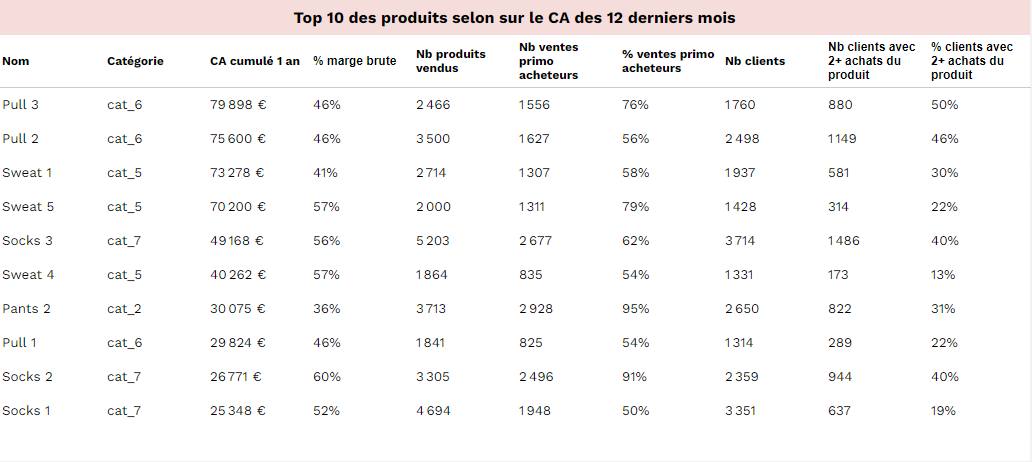

Tip #2 : Faut-il analyser produit par produit ou des ensembles ?

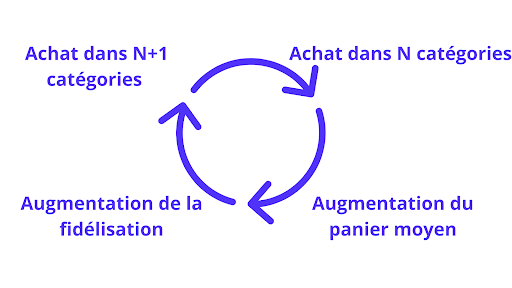

Souvent, on a une logique de bestseller quand on analyse ses produits. On veut savoir, : Quel est le produit que mon entreprise vend le plus ? Quel est le produit qui me ramène le plus de clients (produit recrutant) ou quel est le produit qui fait rester mes clients (produit fidélisant) ? De ce fait, on regarde les produits qui m’apportent le plus de revenus, clients… C’est important mais il ne faut pas hésiter à analyser aussi quels sont mes produits associés, c’est-à-dire, quels sont mes produits que mes clients associent ensemble. Bien comprendre et optimiser ces associations permet de booster ses ventes. En conclusion, il ne faut donc pas oublier de regarder des ensembles de produits plutôt qu’un par un.

Tip #3 : Quels sont vos conseils pour améliorer les performances de ses produits ?

Il y a beaucoup d’indicateurs importants à prendre en compte mais un en particulier que je ne vois pas assez souvent est le taux de retour par produit. Cet indicateur est critique car il est directement lié à la satisfaction client. De plus, c’est l’indicateur qui tire la sonnette d’alarme et qui est une des têtes de lance de la satisfaction client. Il faut, bien sûr, une fois le nombre de retour calculé, conduire des recherches sur les raisons de ces retours et les catégoriser. Une raison ne va pas demander les mêmes changements qu’une autre.

Au-delà de l’analyse effectuée sur un produit en particulier, Il y a une erreur commise par des entreprises, surtout en e-commerce. Ils ne réfléchissent pas assez à comment présenter leurs produits. Ils ne regardent pas l’entièreté de la fiche produit et, de ce fait, si la fiche produit n’est pas optimale, les performances ne le seront pas non plus.

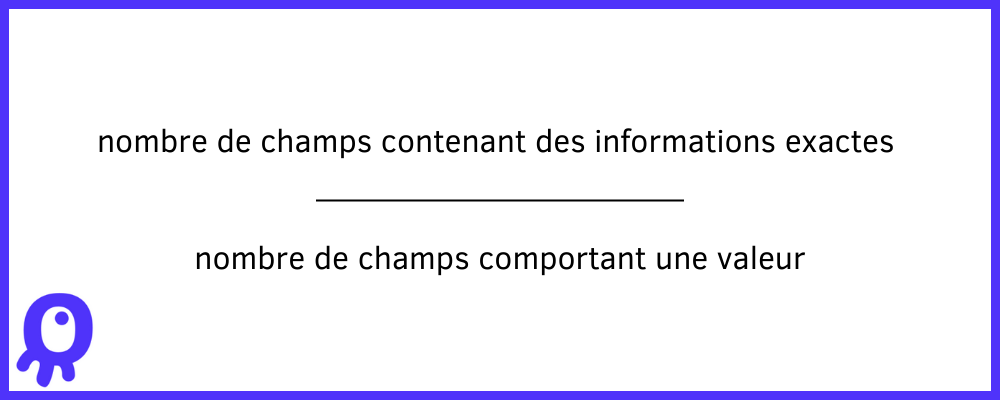

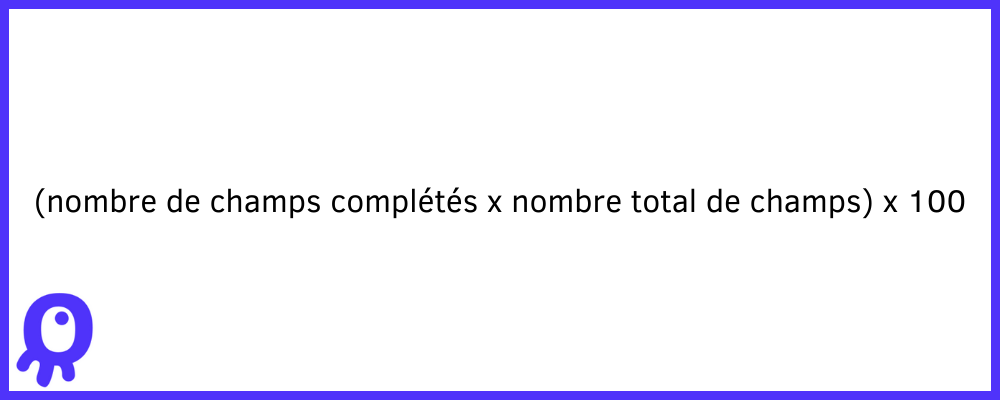

Tip #4 : L’importance cruciale des fiches produit

Un point qui est souvent négligé est la complétion des fiches produits. Or, il y a de nombreux bénéfices à bien compléter l’information sur ces produits. Ainsi, des fiches produits complètes ont un taux de conversion 56% plus élevé que celles qui sont pauvres en informations. En plus de convertir mieux, la complétion de vos fiches produits vous garantit :

- Une meilleure expérience client

- Un meilleur référencement

- Un nombre de retours produits réduit

On a pu donc observer que les consommateurs préfèrent payer un peu plus cher pour un produit qui offre davantage d’informations plutôt que d’acheter un produit plus bon marché avec moins d’informations. Des attributs complets aident les clients à prendre des décisions d’achat éclairées et les rassurent dans leurs achats. De cette façon, on remarque 65% des consommateurs pourraient acheter un produit différent de celui qu’ils envisageaient au départ faute d’informations à la hauteur. Et inversement, 2 acheteurs sur 3 ont déjà abandonné un achat par manque d’informations.

En plus de compléter la fiche produit, il faut s’assurer que les données utilisées dans la fiche produit sont de bonne qualité. Il faut donc prévoir et anticiper des erreurs de classification des produits, qui pourraient entraîner des problèmes tels que des produits publiés dans la mauvaise catégorie ou des dimensions incorrectes, ce qui peut nuire à la satisfaction des clients.

Voilà, nous avons fait le tour de la ressource. N’hésitez pas à l’utiliser et à nous partager vos retours & suggestions 🙂

Dashboard Indicateurs Analyse Produit – Télécharger notre Template

Pour accéder à la ressource, il vous suffit de vous inscrire en quelques clics.

Au clic sur le bouton ci-dessous, vous arriverez sur un formulaire d'inscription rapide. Une fois inscrit, il y a un onglet "Ressources" qui apparaîtra dans le menu du haut qui vous permettra d'accéder à l'ensemble des ressources en téléchargement gratuit.

Avec un peu de chance, vous aurez une bonne surprise, il y aura d'autres ressources qui vous seront utiles 😊